Alex Jones afirmó que la eliminación de la plataforma perjudicó sus ingresos. Crédito:Vic Hinterlang/Shutterstock

Al teórico de la conspiración y personalidad mediática de extrema derecha estadounidense Alex Jones se le ordenó recientemente pagar 45 millones de dólares (37 millones de libras esterlinas) por daños y perjuicios a la familia de un niño que murió en el tiroteo en la escuela de Sandy Hook en 2012.

Jones había afirmado que ser expulsado o "retirado" de los principales sitios de redes sociales por sus puntos de vista extremos lo afectó negativamente financieramente, comparando la situación con la "cárcel". Pero durante el juicio, el economista forense Bernard Pettingill estimó que el sitio web de conspiración de Jones, InfoWars, ganó más dinero después de que se le prohibiera Facebook y Twitter en 2018.

Entonces, ¿realmente funciona la eliminación de plataformas en línea? No es posible medir la influencia de una manera científicamente rigurosa, por lo que es difícil decir qué sucede con la influencia general de una persona o un grupo cuando se eliminan de la plataforma. En general, la investigación sugiere que la eliminación de plataformas puede reducir la actividad de los actores infames en esos sitios. Sin embargo, tiene un precio. A medida que las personas y los grupos sin plataformas migran a otros lugares, pueden perder seguidores, pero también volverse más odiosos y tóxicos.

Por lo general, la eliminación de plataformas implica acciones realizadas por los propios sitios de redes sociales. Pero lo pueden hacer terceros como las instituciones financieras que brindan servicios de pago en estas plataformas, como PayPal.

Cerrar un grupo también es una forma de eliminar la plataforma, incluso si las personas que lo integran siguen siendo libres de usar los sitios. Por ejemplo, el subreddit The_Donald (un foro en el sitio web Reddit) se cerró por albergar contenido de odio y amenazante, como una publicación que alentaba a los miembros a asistir a un mitin de supremacistas blancos.

Parcelas de Jhaver at al. Publicación de niveles de actividad y puntajes de toxicidad severa de los seguidores de tres celebridades de Twitter eliminadas de la plataforma antes y después de la eliminación de la plataforma.

¿Funciona la eliminación de plataformas?

La investigación muestra que la eliminación de la plataforma tiene efectos positivos en la plataforma de la que se expulsó a la persona o al grupo. Cuando Reddit prohibió ciertos foros que victimizaban a personas con sobrepeso y afroamericanos, muchos usuarios que estaban activos en estos odiosos subreddits dejaron de publicar en Reddit por completo. Aquellos que se mantuvieron activos publicaron contenido menos extremo.

Pero el grupo o la persona sin plataforma puede migrar. Alex Jones continúa trabajando fuera de las principales redes sociales, operando principalmente a través de su sitio web y podcasts InfoWars. Una prohibición de la gran tecnología puede verse como un castigo por desafiar el statu quo sin censura, reforzando los lazos y el sentido de pertenencia entre los seguidores.

Gab se creó como una red social alternativa en 2016, dando la bienvenida a los usuarios que han sido baneados de otras plataformas. Desde la insurrección del Capitolio de EE. UU., Gab ha estado tuiteando sobre estas prohibiciones como una insignia de honor y dijo que ha visto un aumento en los usuarios y las solicitudes de empleo.

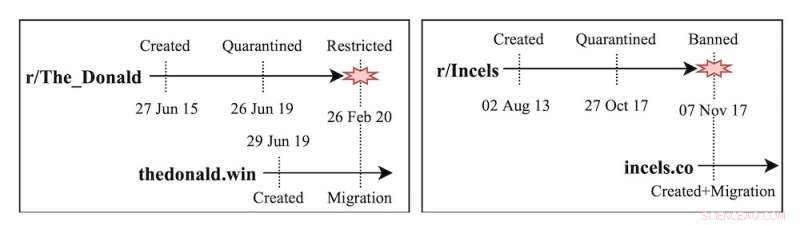

La investigación de mi equipo analizó los subreddits The_Donald e Incels (una comunidad en línea masculina hostil hacia las mujeres), que se trasladaron a sitios web independientes después de que Reddit los prohibiera. Descubrimos que a medida que las comunidades peligrosas migraban a diferentes plataformas, sus huellas se reducían, pero los usuarios se volvían significativamente más extremos. Del mismo modo, los usuarios que fueron prohibidos en Twitter o Reddit mostraron un mayor nivel de actividad y toxicidad al trasladarse a Gab.

Otros estudios sobre el nacimiento de redes sociales marginales como Gab, Parler o Gettr han encontrado patrones relativamente similares. Estas plataformas se comercializan a sí mismas como bastiones de la libertad de expresión, dando la bienvenida a los usuarios prohibidos o suspendidos de otras redes sociales. La investigación muestra que no solo aumenta el extremismo como resultado de una moderación laxa, sino que también los primeros usuarios del sitio tienen una influencia desproporcionada en la plataforma.

Las consecuencias no deseadas de la eliminación de plataformas no se limitan a las comunidades políticas, sino que se extienden a los grupos de desinformación sobre salud y teoría de la conspiración. Por ejemplo, cuando Facebook prohibió los grupos que discutían sobre las vacunas contra el COVID-19, los usuarios ingresaron a Twitter y publicaron aún más contenido contra las vacunas.

Cronologías de creación, cuarentena y prohibición de los subreddits de Incels y The_Donald.

Soluciones alternativas

¿Qué más se puede hacer para evitar la concentración de odio en línea que puede fomentar la eliminación de plataformas? Las redes sociales han estado experimentando con intervenciones de moderación suave que no eliminan contenido ni prohíben a los usuarios. Limitan la visibilidad del contenido (prohibición oculta), restringen la capacidad de otros usuarios para interactuar con el contenido (responder o compartir) o agregan etiquetas de advertencia.

Estos enfoques están mostrando resultados alentadores. Algunas etiquetas de advertencia han llevado a los usuarios del sitio a desacreditar afirmaciones falsas. La moderación suave a veces reduce las interacciones de los usuarios y el extremismo en los comentarios.

Sin embargo, existe la posibilidad de un sesgo de popularidad (actuar o ignorar el contenido en función de los rumores que se generan) sobre los temas en los que las plataformas como Twitter deciden intervenir. Mientras tanto, las etiquetas de advertencia parecen funcionar con menos eficacia para las publicaciones falsas si se inclinan hacia la derecha.

Tampoco está claro si la moderación suave crea vías adicionales para el acoso, por ejemplo, burlarse de los usuarios que reciben etiquetas de advertencia en sus publicaciones o irritar a los usuarios que no pueden volver a compartir contenido.

Ejemplos de moderación suave en Twitter:etiquetas de advertencia y prohibición oculta.

Mirando hacia adelante

Un aspecto crucial de la eliminación de plataformas es el tiempo. Cuanto antes actúen las plataformas para detener a los grupos que utilizan las plataformas principales para hacer crecer los movimientos extremistas, mejor. En teoría, una acción rápida podría frenar los esfuerzos de los grupos para reunir y radicalizar grandes bases de usuarios.

Pero esto también necesitaría un esfuerzo coordinado de las principales plataformas y otros medios para que funcione. Los programas de entrevistas de radio y las noticias por cable juegan un papel crucial en la promoción de narrativas marginales en los EE. UU.

Necesitamos un diálogo abierto sobre la compensación de desplataforma. Como sociedad, debemos discutir si nuestras comunidades deberían tener menos personas expuestas a grupos extremistas, incluso si aquellos que se involucran se vuelven cada vez más aislados y radicalizados.

Por el momento, la eliminación de plataformas está gestionada casi exclusivamente por grandes empresas tecnológicas. Las empresas tecnológicas no pueden resolver el problema solas, pero tampoco los investigadores ni los políticos. Las plataformas deben trabajar con los reguladores, las organizaciones de derechos civiles y los investigadores para hacer frente al contenido extremo en línea. El tejido de la sociedad puede depender de ello.

Este artículo se vuelve a publicar de The Conversation bajo una licencia Creative Commons. Lea el artículo original. Se necesita repensar para detener la difusión de material odioso en línea