Cuando la información en línea causa miedo, puede provocar odio y violencia. Crédito:UVgreen / Shutterstock.com

Cuando un senador de EE. UU. Le preguntó al director ejecutivo de Facebook, Mark Zuckerberg, "¿Puedes definir el discurso de odio?" Podría decirse que fue la pregunta más importante que enfrentan las redes sociales:cómo identificar el extremismo dentro de sus comunidades.

Los delitos de odio en el siglo XXI siguen un patrón familiar en el que una diatriba en línea se convierte en acciones violentas. Antes de abrir fuego en la sinagoga Tree of Life en Pittsburgh, el agresor acusado se había desahogado en la red social de extrema derecha Gab sobre migrantes hondureños que viajaban hacia la frontera de Estados Unidos, y la supuesta conspiración judía detrás de todo. Luego declaró, "No puedo sentarme y ver cómo matan a mi gente. Al diablo con tus ópticas, Voy a entrar ". El patrón de los extremistas descargando su intolerancia en línea ha sido una característica inquietante de algunos crímenes de odio recientes. Pero la mayoría del odio en línea no es tan flagrante, o tan fácil de detectar.

Como encontré en mi estudio de 2017 sobre extremismo en redes sociales y blogs políticos, en lugar de intolerancia abierta, la mayoría del odio en línea se parece mucho al miedo. No se expresa en insultos raciales o llamadas a la confrontación, sino en acusaciones infundadas de invasores hispanos que invaden el país, crimen en blanco y negro o la ley Sharia que se infiltra en las ciudades estadounidenses. Narrativas histéricas como estas se han convertido en el vehículo preferido de los extremistas de hoy, y pueden ser más efectivas para provocar violencia en el mundo real que el discurso de odio estereotipado.

La facilidad de esparcir el miedo

En Twitter, un meme popular que viaja recientemente muestra la "Red terrorista islámica" distribuida en un mapa de los Estados Unidos, mientras que una cuenta de Facebook llamada "America Under Attack" comparte un artículo con sus 17, 000 seguidores sobre los "jóvenes enojados y gangbangers" marchando hacia la frontera. Y en Gab, innumerables perfiles hablan de planes judíos para sabotear la cultura estadounidense, soberanía y el presidente.

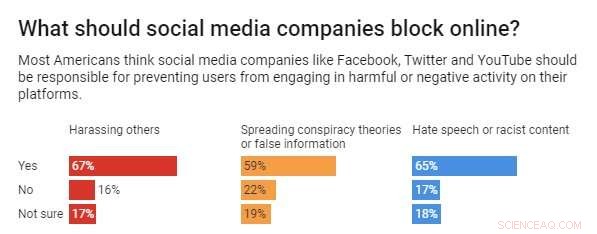

Crédito:Gráfico:La conversación, CC-BY-ND Fuente:HuffPost / YouGov

Aunque no es abiertamente antagónico, estas notas le van bien a una audiencia que ha encontrado en las redes sociales un lugar donde poder expresar su intolerancia abiertamente, siempre que coloreen dentro de las líneas. Pueden evitar la exposición que atrae el discurso de odio tradicional. Mientras que la reunión de los nacionalistas blancos en Charlottesville fue de alto perfil y reveladora, las redes sociales pueden ser anónimas y discretas, y por tanto liberador para los racistas no declarados. Eso presenta un gran desafío para plataformas como Facebook, Twitter y YouTube.

Luchando contra el odio

Por supuesto, esto no es solo un desafío para las empresas de redes sociales. El público en general se enfrenta a la compleja cuestión de cómo responder a narrativas incendiarias y prejuiciosas que avivan los temores raciales y la consiguiente hostilidad. Sin embargo, Las redes sociales tienen la capacidad única de bajar el volumen de la intolerancia si determinan que un usuario ha incumplido sus condiciones de servicio. Por ejemplo, en abril de 2018, Facebook eliminó dos páginas asociadas con el nacionalista blanco Richard Spencer. Unos meses después, Twitter suspendió varias cuentas asociadas con el grupo de extrema derecha The Proud Boys por violar su política de "prohibir los grupos extremistas violentos".

Todavía, algunos críticos argumentan que las redes no se están moviendo lo suficientemente rápido. Existe una presión creciente para que estos sitios web controlen el extremismo que ha florecido en sus espacios, o de lo contrario ser vigilados ellos mismos. Una encuesta reciente de Huffpost / YouGov reveló que dos tercios de los estadounidenses querían que las redes sociales evitaran que los usuarios publicaran "discursos de odio o contenido racista".

En respuesta, Facebook ha intensificado sus esfuerzos contra el extremismo, informando en mayo que había eliminado "2,5 millones de discursos de incitación al odio, "más de un tercio de los cuales se identificó mediante inteligencia artificial, el resto por monitores humanos o marcados por usuarios. Pero incluso cuando Zuckerberg prometió más acciones en noviembre de 2018, La empresa reconoció que enseñar su tecnología para identificar el discurso del odio es extremadamente difícil debido a todos los contextos y matices que pueden alterar drásticamente estos significados.

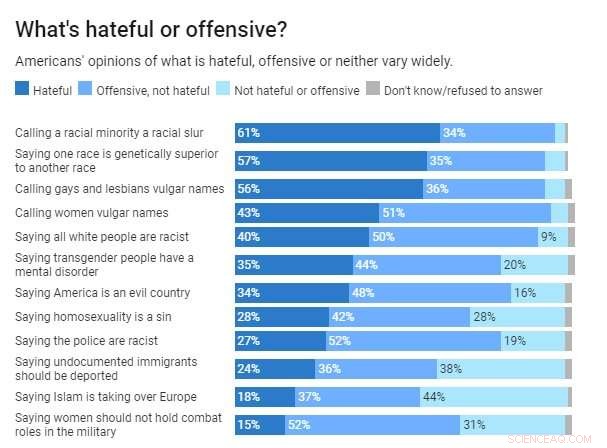

Es posible que los porcentajes totales no sean exactamente iguales a 100 debido al redondeo. Crédito:Gráfico:La conversación, CC-BY-ND Fuente:Cato Institute

Es más, el consenso público sobre lo que realmente constituye un discurso de odio es, en el mejor de los casos, ambiguo. El conservador Instituto Cato encontró un amplio desacuerdo entre los estadounidenses sobre el tipo de discurso que debería calificarse como odio, o discurso ofensivo, o crítica justa. Y entonces, Estas discrepancias plantean la pregunta obvia:¿Cómo puede un algoritmo identificar el discurso de odio si los humanos apenas podemos definirlo nosotros mismos?

El miedo enciende la mecha

La ambigüedad de lo que constituye el discurso del odio está proporcionando una amplia cobertura para que los extremistas modernos infundan ansiedades culturales en las redes populares. Eso presenta quizás el peligro más claro:preparar la paranoia racial de las personas también puede ser extremadamente poderoso para estimular la hostilidad.

El difunto estudioso de la comunicación George Gerbner descubrió que, contrario a la creencia popular, La fuerte exposición a la violencia de los medios de comunicación no hizo que la gente se volviera más violenta. Bastante, les hizo más temerosos de que otros les hicieran violencia, lo que a menudo conduce a una desconfianza corrosiva y un resentimiento cultural. Eso es precisamente lo que están aprovechando los racistas de hoy, y lo que las redes sociales deben aprender a detectar.

Los mensajes que hablan de complots judíos para destruir América, o crimen en blanco y negro, no están llamando directamente a la violencia, pero amplifican puntos de vista prejuiciosos que pueden incitar a los seguidores a actuar. Eso es precisamente lo que sucedió antes de los ataques mortales en una histórica iglesia negra en Charleston en 2015, y la sinagoga de Pittsburgh el mes pasado.

Para redes sociales, el desafío es doble. Primero deben decidir si continúan acogiendo a racistas no violentos como Richard Spencer, que ha pedido una "limpieza étnica pacífica, "y permanece activo en Twitter. O para el caso, El líder de la Nación del Islam Louis Farrakhan, que recientemente comparó a los judíos con las termitas, y continúa publicando en su página de Facebook.

Cuando Twitter y Facebook permiten que estos perfiles permanezcan activos, las empresas prestan la credibilidad de sus comunidades en línea a estos provocadores del racismo o el antisemitismo. Pero también indican que sus definiciones de odio pueden ser demasiado limitadas.

El discurso de odio más peligroso aparentemente ya no se transmite con insultos étnicos o retórica delirante sobre la supremacía blanca. Bastante, está en todas las redes sociales, a la vista, llevando hashtags como #WhiteGenocide, # Crímenes Negros, #MigrantInvasion y #AmericaUnderAttack. Crean una ilusión de amenaza inminente de la que prosperan los radicales, ya lo que han respondido los inclinados a la violencia.

Este artículo se ha vuelto a publicar de The Conversation con una licencia de Creative Commons. Lea el artículo original.