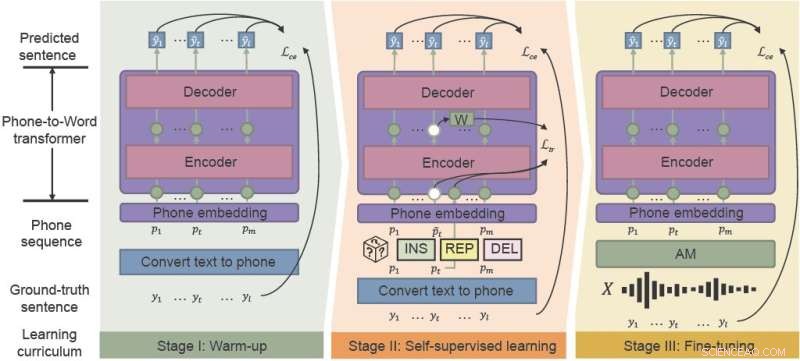

El marco de preentrenamiento fonético-semántico (PSP) utiliza el aprendizaje de un "plan de estudios consciente del ruido" para mejorar de manera efectiva el rendimiento de ASR en entornos ruidosos. integrando el calentamiento, el aprendizaje autosupervisado y el ajuste fino. Crédito:Investigación de inteligencia artificial de CAAI , Prensa de la Universidad de Tsinghua

Asistentes de voz populares como Siri y Amazon Alexa han introducido el reconocimiento automático de voz (ASR) al público en general. Aunque se fabricaron durante décadas, los modelos ASR luchan por la consistencia y la confiabilidad, especialmente en entornos ruidosos. Investigadores chinos desarrollaron un marco que mejora efectivamente el rendimiento de ASR para el caos de los entornos acústicos cotidianos.

Investigadores de la Universidad de Ciencia y Tecnología de Hong Kong y WeBank propusieron un nuevo marco:entrenamiento previo fonético-semántico (PSP) y demostraron la solidez de su nuevo modelo frente a conjuntos de datos de voz sintéticos con mucho ruido.

Su estudio fue publicado en CAAI Artificial Intelligence Research el 28 de agosto.

"La robustez es un desafío de larga data para ASR", dijo Xueyang Wu, del Departamento de Ciencias de la Computación e Ingeniería de la Universidad de Ciencia y Tecnología de Hong Kong. "Queremos aumentar la solidez del sistema ASR chino a bajo costo".

ASR utiliza el aprendizaje automático y otras técnicas de inteligencia artificial para traducir automáticamente el habla en texto para usos como sistemas activados por voz y software de transcripción. Pero las nuevas aplicaciones centradas en el consumidor exigen cada vez más que el reconocimiento de voz funcione mejor:gestione más idiomas y acentos y funcione de manera más confiable en situaciones de la vida real, como videoconferencias y entrevistas en vivo.

Tradicionalmente, entrenar los modelos acústicos y de lenguaje que componen ASR requiere grandes cantidades de datos específicos del ruido, lo que puede resultar prohibitivo en términos de tiempo y costo.

El modelo acústico (AM) convierte las palabras en "teléfonos", que son secuencias de sonidos básicos. El modelo de lenguaje (LM) decodifica los teléfonos en oraciones de lenguaje natural, generalmente con un proceso de dos pasos:un LM rápido pero relativamente débil genera un conjunto de oraciones candidatas, y un LM potente pero computacionalmente costoso selecciona la mejor oración de los candidatos.

"Los modelos de aprendizaje tradicionales no son robustos contra las salidas ruidosas del modelo acústico, especialmente para las palabras polifónicas chinas con pronunciación idéntica", dijo Wu. "Si la primera pasada de la decodificación del modelo de aprendizaje es incorrecta, es extremadamente difícil que la segunda pasada lo recupere".

El marco PSP recientemente propuesto facilita la recuperación de palabras mal clasificadas. Al entrenar previamente un modelo que traduce las salidas de AM directamente a oraciones junto con la información de contexto completa, los investigadores pueden ayudar al LM a recuperarse de manera eficiente de las salidas ruidosas de AM.

El marco de PSP permite que el modelo mejore a través de un régimen de capacitación previa llamado plan de estudios consciente del ruido que introduce gradualmente nuevas habilidades, comenzando de manera fácil y pasando gradualmente a tareas más complejas.

"La parte más crucial de nuestro método propuesto, el aprendizaje del plan de estudios consciente del ruido, simula el mecanismo de cómo los seres humanos reconocen una oración del habla ruidosa", dijo Wu.

El calentamiento es la primera etapa, donde los investigadores entrenan previamente un transductor de teléfono a palabra en una secuencia de teléfono limpia, que se traduce solo a partir de datos de texto sin etiquetar, para reducir el tiempo de anotación. Esta etapa "calienta" el modelo, inicializando los parámetros básicos para mapear secuencias telefónicas a palabras.

En la segunda etapa, aprendizaje autosupervisado, el transductor aprende de datos más complejos generados por técnicas y funciones de entrenamiento autosupervisado. Finalmente, el transductor de teléfono a palabra resultante se ajusta con datos de voz del mundo real.

Los investigadores demostraron experimentalmente la efectividad de su marco en dos conjuntos de datos de la vida real recopilados de escenarios industriales y ruido sintético. Los resultados mostraron que el marco de PSP mejora efectivamente la canalización ASR tradicional, reduciendo las tasas de error relativo de caracteres en un 28,63 % para el primer conjunto de datos y en un 26,38 % para el segundo.

En los próximos pasos, los investigadores investigarán métodos de preentrenamiento de PSP más efectivos con conjuntos de datos no emparejados más grandes, buscando maximizar la efectividad del preentrenamiento para LM resistente al ruido. Uso del aprendizaje multitarea para la traducción de voz de baja latencia