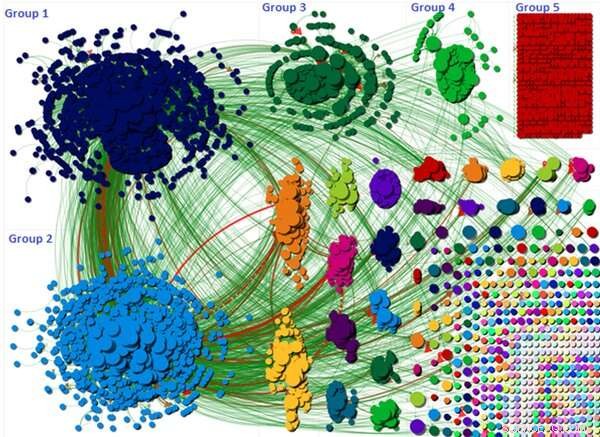

El gráfico muestra cómo la discusión de la teoría de la conspiración se dividió en diferentes grupos. Crédito:Wasim Ahmed, Autor proporcionado

Se cree ampliamente que las teorías de conspiración en las redes sociales están impulsadas por "bots" maliciosos y anónimos creados por terceros en la sombra. Pero mi nueva investigación, que examinó una teoría de la conspiración COVID-19 extremadamente exitosa, ha demostrado que los relatos de los ciudadanos comunes pueden ser igualmente culpables cuando se trata de difundir mentiras peligrosas y desinformación.

La pandemia ha alimentado al menos diez teorías de conspiración este año. Algunos relacionaron la propagación de la enfermedad con la red 5G, provocando actos de vandalismo en las antenas telefónicas. Otros argumentaron que COVID-19 era un arma biológica. La investigación ha demostrado que las teorías de la conspiración podrían contribuir a que las personas ignoren las reglas de distanciamiento social.

El movimiento #FilmYourHospital fue una de esas teorías. Animó a las personas a grabar videos de sí mismos en aparentemente vacíos, o menos concurrida, hospitales para demostrar que la pandemia es un engaño. Se compartieron muchos videos que mostraban pasillos y salas vacíos.

Nuestra investigación buscó identificar los impulsores de la conspiración y examinar si las cuentas que la impulsaron en abril de 2020 eran bots o personas reales.

Escala de la conspiración

La conspiración 5G atrajo a 6, 556 usuarios de Twitter en el transcurso de una sola semana. los #FilmYourHospital la conspiración era mucho más grande que 5G, con un total de 22, 785 tweets enviados durante un período de siete días a las 11, 333 usuarios. También tuvo un fuerte respaldo internacional.

La visualización anterior muestra a cada usuario de Twitter como un pequeño círculo y la discusión general está agrupada en varios grupos diferentes. Estos grupos se forman en función de cómo los usuarios se mencionaban y se reenvían a twittear entre sí.

La visualización destaca cómo los tres grupos más grandes fueron los responsables de difundir la conspiración más lejos. Por ejemplo, la discusión en los grupos uno y dos se centró en un solo tweet que fue muy retuiteado. El tuit sugirió que se estaba engañando al público y que los hospitales no estaban ocupados ni invadidos, como habían informado los principales medios de comunicación. Luego, el tweet solicitó a otros usuarios que filmaran sus hospitales usando el hashtag para que pudiera convertirse en un tema de tendencia. El gráfico muestra el alcance y el tamaño de estos grupos.

¿Dónde están los bots?

Usamos Botometer para detectar bots que se basan en un algoritmo de aprendizaje automático. La herramienta calcula una puntuación en la que las puntuaciones bajas indican el comportamiento humano y una puntuación alta indica un bot. Botometer funciona extrayendo varias funciones de una cuenta, como su perfil, amigos, red social, patrones en la actividad temporal, lenguaje y sentimiento. Nuestro estudio tomó una muestra representativa sistemática del 10% de usuarios para ejecutar a través de Botometer.

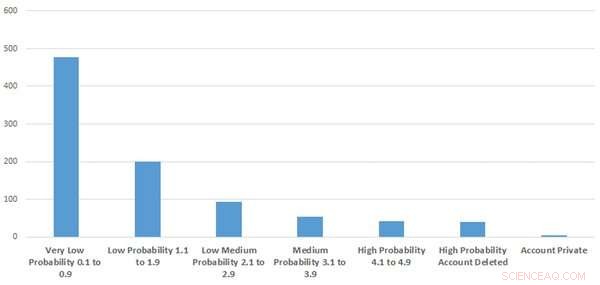

La figura muestra cuántas de las cuentas eran sospechosas o parecidas a un bot. Crédito:Wasim Ahmed, Autor proporcionado

Nuestros resultados indicaron que es probable que la tasa de cuentas automatizadas sea baja. Usamos las puntuaciones brutas de Botometer para adjuntar una etiqueta de probabilidad de si era probable que la cuenta fuera un bot. Estos iban desde muy bajos, bajo, probabilidad baja-media y alta.

A lo mejor, solo el 9.2% de la muestra que analizamos se parecía a un comportamiento de cuenta o bots altamente sospechosos. Eso significa que más del 90% de las cuentas que examinamos probablemente eran genuinas.

Curiosamente, También encontramos que las cuentas eliminadas y las cuentas automatizadas contenían palabras clave como "Trump" y "Make America Great Again" en sus biografías de usuarios. Casi al mismo tiempo, el presidente Donald Trump había estado en desacuerdo con los asesores científicos sobre cuándo levantar las reglas de bloqueo.

¿De dónde vino?

Cuando examinamos a los usuarios más influyentes conectados al hashtag, encontramos que la teoría de la conspiración fue impulsada por políticos conservadores influyentes y activistas políticos de extrema derecha. Los académicos han notado cómo la extrema derecha se ha aprovechado de la pandemia. Por ejemplo, algunos han configurado canales en Telegram, un servicio de mensajería instantánea basado en la nube, para discutir COVID-19 y haber amplificado la desinformación.

Pero una vez que la teoría de la conspiración comenzó a generar atención, fue sostenida por ciudadanos comunes. La campaña también parecía estar respaldada e impulsada por cuentas de Twitter pro-Trump y nuestra investigación encontró que algunas cuentas que se comportaban como "bots" y cuentas eliminadas tendían a ser pro-Trump. Es importante tener en cuenta que no todas las cuentas que se comportan como bots son bots, ya que puede haber usuarios muy activos que podrían recibir una puntuación alta. Y, en cambio, no todos los bots son dañinos, ya que algunos se han creado con fines legítimos.

Los usuarios de Twitter compartieron con frecuencia videos de YouTube en apoyo de la teoría y YouTube fue una fuente influyente.

¿Pueden ser detenidos?

Las organizaciones de redes sociales pueden monitorear cuentas y contenido sospechosos y si violan los términos de servicio, el contenido debe eliminarse rápidamente. Twitter experimentó adjuntando etiquetas de advertencia en los tweets. Inicialmente, esto no tuvo éxito porque Twitter accidentalmente etiquetó incorrectamente algunos tweets, lo que podría haber empujado inadvertidamente las conspiraciones más lejos. Pero si logran armar una mejor técnica de etiquetado, este podría ser un método eficaz.

Las conspiraciones también se pueden contrarrestar proporcionando información confiable, entregados por las autoridades de salud pública y los "influencers" de la cultura popular. Por ejemplo, Ayuntamiento de Oldham en el Reino Unido, contó con la ayuda del actor James Buckley, famoso por su papel de Jay en la comedia de situación de E4 The Inbetweeners, para difundir mensajes de salud pública.

Y otra investigación destaca que explicar los argumentos defectuosos y describir el consenso científico puede ayudar a reducir el efecto de la desinformación. Lamentablemente, no importa qué procedimientos y pasos se implementen, siempre habrá gente que crea en conspiraciones. La responsabilidad debe estar en las plataformas para asegurarse de que estas teorías no se difundan tan fácilmente.

Este artículo se vuelve a publicar de The Conversation bajo una licencia Creative Commons. Lea el artículo original.