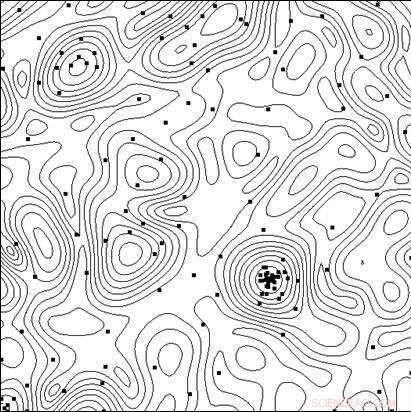

Líneas del nivel de la función objetivo y los puntos de las pruebas realizadas por el algoritmo en el proceso de encontrar el mínimo. Crédito:Universidad Lobachevsky

Crear sistemas técnicos y procesos tecnológicos de alta eficacia, además del uso de nuevos principios, nuevos materiales, nuevos efectos físicos y otras soluciones que determinan la estructura general del objeto que se está creando, Los investigadores deben elegir la mejor combinación de los parámetros del objeto (dimensiones geométricas, Características electricas, etc.), ya que cualquier cambio en los parámetros con una estructura de objeto general fija puede afectar significativamente los indicadores de efectividad.

En diseño asistido por computadora, la prueba de opciones se puede llevar a cabo analizando su modelo matemático para diferentes valores de parámetros. A medida que los modelos se vuelven cada vez más complejos, surge la necesidad de una selección específica de opciones en la búsqueda de la solución óptima (más eficaz).

Un equipo de científicos de la Universidad Estatal Lobachevsky de Nizhny Novgorod (UNN) dirigido por el profesor Roman Strongin ha estado estudiando las opciones específicas al buscar la solución óptima. Se trata de un análisis de un subconjunto de las posibles opciones con el objetivo de excluir casos evidentemente poco prometedores y concentrar la búsqueda en el subconjunto que contiene la mejor opción.

"Cuando los modelos matemáticos de los procesos que ocurren en un objeto se vuelven más complicados, las características de eficiencia no poseerán la propiedad de monotonicidad, es por eso que los métodos de búsqueda locales son insuficientes para evaluar la mejor opción, "dice el profesor Roman Strongin.

Los procedimientos de búsqueda global que se utilizan en tales problemas (también llamados problemas de optimización multi-extrema) aseguran que la búsqueda sea dirigida teniendo en cuenta la naturaleza limitada del cambio en las características del objeto cuando los cambios en sus parámetros son limitados. La formulación matemática resultante puede tomar la forma de la condición de Lipschitz, la condición uniforme de Hölder, etc.

Los problemas de optimización multi-extrema ofrecen un alcance limitado de oportunidades de investigación analítica, y se vuelven computacionalmente costosos cuando se buscan soluciones numéricas, dado que los costos computacionales crecen exponencialmente con la dimensión creciente del problema.

Según Konstantin Barkalov, Profesor asociado del Departamento de Software y Tecnologías de Supercomputación de la UNN, el uso de sistemas informáticos en paralelo modernos amplía el alcance de los métodos de optimización global. Sin embargo, al mismo tiempo, plantea el desafío de paralelizar eficazmente el proceso de búsqueda.

"Es por eso que los principales esfuerzos en esta área deben concentrarse en desarrollar métodos paralelos eficientes para resolver numéricamente problemas de optimización multi-extrema y crear software apropiado para sistemas informáticos modernos sobre la base de tales métodos, "dice Barkalov.

Generalmente, los métodos de optimización global (tanto secuenciales como paralelos) están destinados a resolver un solo problema de optimización. Para resolver una serie de problemas q, los problemas de la serie se resuelven secuencialmente, Uno después del otro. Por lo tanto, la estimación óptima en el i-ésimo problema de la serie permanece indefinida hasta que todos los problemas anteriores de la serie (con los índices 1, 2, . . . , I ? 1) se han resuelto por completo. En el caso de recursos computacionales limitados, las estimaciones óptimas en los problemas i + 1, . . . , q no se obtendrá si se agotan los recursos de cálculo mientras se resuelve el i-ésimo problema.

Las situaciones en las que hay q resolver una serie de problemas no son extraordinarias. Por ejemplo, surge una serie de problemas escalares cuando se busca un conjunto de Pareto para resolver problemas de optimización multiobjetivo. En este caso, la solución de un solo problema escalar corresponde a uno de los puntos óptimos de Pareto de un problema multiobjetivo. También surge una serie de problemas de optimización cuando se utilizan métodos de reducción de dimensiones para resolver problemas de optimización multidimensional. Finalmente, También se puede obtener una serie de problemas de prueba con la ayuda de un generador de problemas de prueba en particular.

Los científicos creen que al resolver un conjunto de problemas, es necesario tener estimaciones iniciales de soluciones para todos los problemas a la vez, para que en cualquier momento sea posible evaluar la conveniencia de continuar la búsqueda. En este caso, es deseable tener las estimaciones óptimas para todos los problemas con la misma precisión.

Ejecutar muchos procesos independientes en un sistema informático paralelo, cada uno de los procesos resuelve un problema de una serie, tiene una serie de inconvenientes. Primero, se producirá un desequilibrio de la carga de trabajo entre los procesadores. Si resolver el i-ésimo problema requiere considerablemente menos iteraciones del método que resolver el j-ésimo problema, el procesador encargado de manejar el i-ésimo problema permanecería inactivo después de completar la tarea. Segundo, las estimaciones de los óptimos se obtendrán con diferente precisión en diferentes problemas. Los problemas más simples se resolverán con mayor precisión, mientras que la precisión será menor para problemas más complejos.

El objetivo de la investigación realizada en la Universidad Lobachevsky fue desarrollar un nuevo método para resolver una serie de problemas de optimización global que aseguraran:(i) una carga uniforme de todos los núcleos / procesadores empleados; (ii) una convergencia uniforme a las soluciones de todos los problemas de la serie.

En la parte teórica de su artículo, Los científicos de la UNN también demostraron el teorema de la convergencia uniforme del nuevo algoritmo. La parte experimental del trabajo consistió en resolver una serie de varios cientos de problemas de prueba de diferentes dimensiones, y los resultados han demostrado de manera convincente la presencia de una convergencia uniforme.

También los científicos de la UNN consideran problemas de optimización global computacionalmente intensivos, para resolver qué sistemas de supercomputación con rendimiento exaflops pueden ser necesarios. Para superar tal complejidad computacional, los investigadores proponen esquemas computacionales paralelos generalizados, lo que puede implicar numerosos algoritmos paralelos eficientes de optimización global. Los esquemas propuestos incluyen métodos de descomposición multinivel de cálculos paralelos para garantizar la eficiencia computacional de los sistemas de supercomputación con multiprocesadores de memoria compartida y distribuida que utilizan miles de procesadores para cumplir con los desafíos de optimización global.