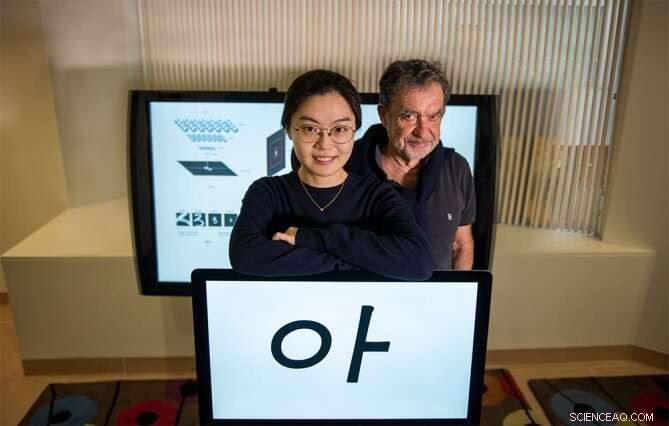

Yena Han (izquierda) y Tomaso Poggio se colocan con un ejemplo de los estímulos visuales utilizados en un nuevo estudio de psicofísica. Crédito:Kris Brewer

Suponga que mira brevemente desde unos metros de distancia a una persona a la que nunca ha conocido antes. Retroceda unos pasos y vuelva a mirar. ¿Serás capaz de reconocer su rostro? "Sí, por supuesto, "probablemente estés pensando. Si esto es cierto, significaría que nuestro sistema visual, haber visto una sola imagen de un objeto, como una cara específica, lo reconoce de forma robusta a pesar de los cambios en la posición y escala del objeto, por ejemplo. Por otra parte, sabemos que los clasificadores de última generación, como las redes profundas de vainilla, fallará esta simple prueba.

Para reconocer un rostro específico bajo una serie de transformaciones, Las redes neuronales deben entrenarse con muchos ejemplos de la cara en las diferentes condiciones. En otras palabras, pueden lograr la invariancia mediante la memorización, pero no puede hacerlo si solo hay una imagen disponible. Por lo tanto, Comprender cómo la visión humana puede lograr esta notable hazaña es relevante para los ingenieros que buscan mejorar sus clasificadores existentes. También es importante para los neurocientíficos que modelan el sistema visual de los primates con redes profundas. En particular, Es posible que la invariancia con el aprendizaje de una sola vez exhibida por la visión biológica requiera una estrategia computacional bastante diferente a la de las redes profundas.

Un nuevo artículo del MIT Ph.D. candidata en ingeniería eléctrica e informática Yena Han y sus colegas en Informes científicos de la naturaleza , titulado "Escala e invariancia de traducción para objetos nuevos en la visión humana, "analiza cómo estudian este fenómeno con más detenimiento para crear nuevas redes de inspiración biológica.

"Los seres humanos pueden aprender de muy pocos ejemplos, a diferencia de las redes profundas. Esta es una gran diferencia con vastas implicaciones para la ingeniería de sistemas de visión y para comprender cómo funciona realmente la visión humana. "afirma el coautor Tomaso Poggio, director del Center for Brains, Minds and Machines (CBMM) y el profesor Eugene McDermott de ciencias cognitivas y cerebrales en el MIT. "Una razón clave de esta diferencia es la invariancia relativa del sistema visual de los primates a la escala, cambio, y otras transformaciones. Extrañamente, esto se ha descuidado principalmente en la comunidad de IA, en parte porque los datos psicofísicos no estaban tan bien definidos. El trabajo de Han ha establecido ahora medidas sólidas de invariancias básicas de la visión humana ".

Para diferenciar la invariancia que surge de la computación intrínseca con la de la experiencia y la memorización, el nuevo estudio midió el rango de invariancia en el aprendizaje de una sola vez. Se realizó una tarea de aprendizaje de una sola vez mediante la presentación de estímulos de letras coreanas a sujetos humanos que no estaban familiarizados con el idioma. Estas letras se presentaron inicialmente una sola vez bajo una condición específica y se probaron en diferentes escalas o posiciones que la condición original. El primer resultado experimental es que, tal como adivinó, los humanos mostraron un reconocimiento invariante de escala significativo después de una sola exposición a estos nuevos objetos. El segundo resultado es que el rango de invariancia de posición es limitado, dependiendo del tamaño y la ubicación de los objetos.

Próximo, Han y sus colegas realizaron un experimento similar en redes neuronales profundas diseñadas para reproducir este desempeño humano. Los resultados sugieren que para explicar el reconocimiento invariante de objetos por parte de los humanos, Los modelos de redes neuronales deben incorporar explícitamente la invariancia de escala incorporada. Además, La invariancia de posición limitada de la visión humana se replica mejor en la red al aumentar los campos receptivos de las neuronas modelo a medida que se alejan del centro del campo visual. Esta arquitectura es diferente de los modelos de redes neuronales de uso común, donde una imagen se procesa con una resolución uniforme con los mismos filtros compartidos.

"Nuestro trabajo proporciona una nueva comprensión de la representación cerebral de objetos bajo diferentes puntos de vista. También tiene implicaciones para la IA, ya que los resultados proporcionan nuevos conocimientos sobre lo que es un buen diseño arquitectónico para redes neuronales profundas, "comenta Han, Investigador del CBMM y autor principal del estudio.

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre la investigación del MIT, innovación y docencia.