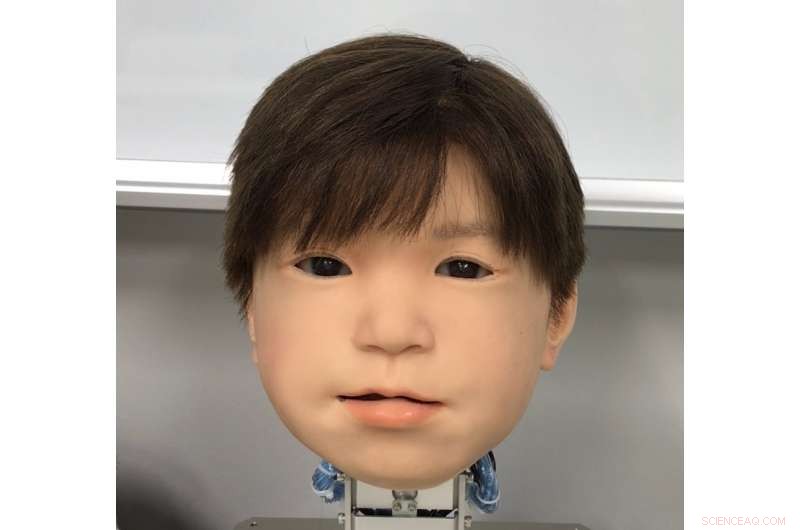

El rostro recién desarrollado del robot androide infantil Affetto. El rostro de Affetto se reveló por primera vez en una investigación publicada en 2011. Crédito:Universidad de Osaka

El afecto de Japón por los robots no es ningún secreto. Pero, ¿el sentimiento es mutuo en los increíbles androides del país? Los roboticistas están ahora un paso más cerca de darles a los androides mayores expresiones faciales con las que comunicarse.

A pesar de los avances, capturar expresiones humanistas en un rostro robótico sigue siendo un desafío difícil de alcanzar. Aunque las propiedades de su sistema se han abordado en general, Las expresiones faciales de los androides no se han examinado en detalle. Esto se debe a factores como la gran variedad y la asimetría de los movimientos faciales humanos naturales, las restricciones de los materiales utilizados en la piel de Android, y la intrincada ingeniería y matemáticas que impulsan los movimientos de los robots.

Un trío de investigadores de la Universidad de Osaka ha encontrado un método para identificar y evaluar cuantitativamente los movimientos faciales en la cabeza de su niño robot androide. Llamado Affetto, el modelo de primera generación se informó en una publicación de 2011. Los investigadores ahora han desarrollado un sistema para hacer que el Affetto de segunda generación sea más expresivo. Sus hallazgos ofrecen un camino para que los androides expresen mayores rangos de emociones, y, en última instancia, tener una interacción más profunda con los humanos.

Los investigadores informaron sus hallazgos en la revista. Fronteras en robótica e inteligencia artificial .

"Las deformaciones de la superficie son un problema clave para controlar las caras de Android, "explica el coautor del estudio, Minoru Asada." Los movimientos de su suave piel facial crean inestabilidad, y este es un gran problema de hardware al que nos enfrentamos. Buscamos una mejor manera de medirlo y controlarlo ".

Los investigadores investigaron 116 puntos faciales diferentes en Affetto para medir su movimiento tridimensional. Los puntos faciales estaban respaldados por las llamadas unidades de deformación. Cada unidad comprende un conjunto de mecanismos que crean una contorsión facial distintiva, como bajar o levantar parte de un labio o párpado. Las mediciones de estos luego se sometieron a un modelo matemático para cuantificar sus patrones de movimiento de superficie.

Si bien los investigadores encontraron desafíos para equilibrar la fuerza aplicada y ajustar la piel sintética, pudieron emplear su sistema para ajustar las unidades de deformación para un control preciso de los movimientos de la superficie facial de Affetto.

"Las caras de los robots de Android han persistido en ser un problema de caja negra:se han implementado pero solo se han juzgado en términos vagos y generales, ", dice el primer autor del estudio, Hisashi Ishihara." Nuestros hallazgos precisos nos permitirán controlar eficazmente los movimientos faciales de los androides para introducir expresiones más matizadas, como sonreír y fruncir el ceño ".