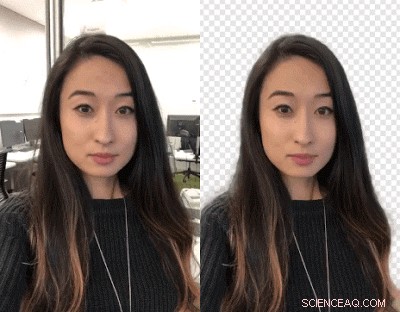

Crédito:Google

Creadores de videos:¿Quieres intercambiar fondos? Golpeeos a vosotros mismos. Los investigadores de Google han estado trabajando en una forma de permitirle intercambiar sus fondos de video mediante una red neuronal, sin necesidad de una pantalla verde.

Se está implementando en YouTube Stories en dispositivos móviles de manera limitada, dijo TechCrunch .

John Anon, Titulares de Android , dijo que los creadores de YouTube pueden cambiar el fondo para crear videos más atractivos.

Valentin Bazarevsky y Andrei Tkachenka, ingenieros de software, Investigación de Google, hizo el anuncio, titulado "Segmentación de vídeo en tiempo real para móviles".

Los creadores de contenido de video saben que el fondo de una escena se puede separar del fondo tratado como dos capas diferentes. La maniobra se realiza para lograr un estado de ánimo, o inserte una ubicación divertida o resalte el impacto del mensaje.

La operacion, dijeron los dos en el sitio de investigación de Google, es "un proceso manual que requiere mucho tiempo (por ejemplo, un artista rotoscopiando cada fotograma) o requiere un entorno de estudio con una pantalla verde para la eliminación del fondo en tiempo real (una técnica conocida como incrustación cromática)".

Traducción:Hillary Grigonis en Tendencias digitales dijo, "Reemplazar el fondo de un video generalmente requiere un software de escritorio avanzado y mucho tiempo libre, o un estudio completo con pantalla verde ".

Ahora los dos han anunciado una nueva técnica, y funcionará en teléfonos móviles.

Su técnica permitirá a los creadores reemplazar y modificar fondos sin equipo especializado.

Lo llamaron el nuevo formato de video ligero de YouTube, diseñado específicamente para los creadores de YouTube.

Emitieron un anuncio el 1 de marzo de un "preciso, tiempo real, segmentación de video móvil en el dispositivo a la aplicación de YouTube mediante la integración de esta tecnología en las historias ".

¿Cómo hicieron esto? Anon dijo que "el quid de todo es el aprendizaje automático".

Bazarevsky y Tkachenka dijeron que aprovecharon "el aprendizaje automático para resolver una tarea de segmentación semántica utilizando redes neuronales convolucionales".

Traducción:"Google está desarrollando una alternativa de inteligencia artificial que funciona en tiempo real, desde la cámara de un teléfono inteligente, ", Escribió Grigonis.

Los dos ingenieros describieron una arquitectura y un procedimiento de formación adecuados para teléfonos móviles. Tenían en cuenta que "una solución móvil debe ser liviana y ejecutarse al menos entre 10 y 30 veces más rápido que los modelos de segmentación fotográfica de vanguardia existentes".

En cuanto a un conjunto de datos, ellos "anotaron decenas de miles de imágenes". Estos capturaron un amplio espectro de poses en primer plano y configuraciones de fondo.

"Con ese conjunto de datos, el grupo entrenó el programa para separar el fondo del primer plano, "dijo Grigonis.

Devin Coldewey en TechCrunch :"La red aprendió a identificar las características comunes de la cabeza y los hombros, y una serie de optimizaciones redujo la cantidad de datos que necesitaba procesar para poder hacerlo ".

Tendencias digitales explicó cómo funciona:"Una vez que el software enmascara el fondo de la primera imagen, el programa usa esa misma máscara para predecir el fondo en el siguiente cuadro. Cuando el siguiente cuadro tenga solo ajustes menores desde el primero ... el programa hará pequeños ajustes a la máscara. Cuando el siguiente fotograma sea muy diferente del anterior ... el software descartará la predicción de la máscara por completo y creará una nueva máscara ".

Un resultado final de su trabajo, como se dice en el blog de investigación de Google, es que "nuestra red funciona muy rápido en dispositivos móviles, lograr 100+ FPS en iPhone 7 y 40+ FPS en Pixel 2 con alta precisión (obteniendo 94.8% IOU en nuestro conjunto de datos de validación), entregando una variedad de efectos de respuesta y funcionamiento fluido en las historias de YouTube ".

¿Que sigue?

Está en versión beta limitada. "Nuestro objetivo inmediato es utilizar la implementación limitada en las historias de YouTube para probar nuestra tecnología en este primer conjunto de efectos. A medida que mejoramos y expandimos nuestra tecnología de segmentación a más etiquetas, planeamos integrarlo en los servicios de realidad aumentada más amplios de Google ".

© 2018 Tech Xplore