Vídeos naturalistas y presentación en MRI bore. (A) Cuadros de ejemplo de videoclips que se muestran a los participantes. (B) Bhubo, una mezcla de Boxer de 4 años, mira videos mientras se somete a una resonancia magnética funcional despierto. Crédito:Diario de Experimentos Visualizados (2022). DOI:10.3791/64442

Los científicos han decodificado imágenes visuales del cerebro de un perro, ofreciendo un primer vistazo a cómo la mente canina reconstruye lo que ve. El Diario de Experimentos Visualizados publicó la investigación realizada en la Universidad de Emory.

Los resultados sugieren que los perros están más en sintonía con las acciones de su entorno que con quién o qué está realizando la acción.

Los investigadores registraron los datos neuronales de fMRI para dos perros despiertos y sin restricciones mientras miraban videos en tres sesiones de 30 minutos, por un total de 90 minutos. Luego usaron un algoritmo de aprendizaje automático para analizar los patrones en los datos neuronales.

"Demostramos que podemos monitorear la actividad en el cerebro de un perro mientras mira un video y, al menos hasta cierto punto, reconstruir lo que está mirando", dice Gregory Berns, profesor de psicología de Emory y autor correspondiente del artículo. . "El hecho de que podamos hacer eso es extraordinario".

El proyecto se inspiró en los avances recientes en aprendizaje automático y fMRI para decodificar estímulos visuales del cerebro humano, proporcionando nuevos conocimientos sobre la naturaleza de la percepción. Más allá de los humanos, la técnica se ha aplicado solo a un puñado de otras especies, incluidos algunos primates.

"Si bien nuestro trabajo se basa en solo dos perros, ofrece una prueba de concepto de que estos métodos funcionan en caninos", dice Erin Phillips, primera autora del artículo, quien realizó el trabajo como especialista en investigación en el Laboratorio de Neurociencia Cognitiva Canina de Berns. "Espero que este documento ayude a allanar el camino para que otros investigadores apliquen estos métodos en perros, así como en otras especies, para que podamos obtener más datos y una mayor comprensión de cómo funcionan las mentes de diferentes animales".

Phillips, nativo de Escocia, llegó a Emory como becario Bobby Jones, un programa de intercambio entre Emory y la Universidad de St Andrews. Actualmente es estudiante de posgrado en ecología y biología evolutiva en la Universidad de Princeton.

Berns y sus colegas fueron pioneros en técnicas de entrenamiento para hacer que los perros caminen hacia un escáner fMRI y se mantengan completamente quietos y sin restricciones mientras se mide su actividad neuronal. Hace una década, su equipo publicó las primeras imágenes cerebrales de resonancia magnética funcional de un perro completamente despierto y sin restricciones. Eso abrió la puerta a lo que Berns llama The Dog Project, una serie de experimentos que exploran la mente de las especies domesticadas más antiguas.

A lo largo de los años, su laboratorio ha publicado investigaciones sobre cómo el cerebro canino procesa la visión, las palabras, los olores y las recompensas, como recibir elogios o comida.

Mientras tanto, la tecnología detrás de los algoritmos informáticos de aprendizaje automático siguió mejorando. La tecnología ha permitido a los científicos decodificar algunos patrones de actividad cerebral humana. La tecnología "lee la mente" al detectar dentro de patrones de datos cerebrales los diferentes objetos o acciones que un individuo ve mientras ve un video.

"Empecé a preguntarme:'¿Podemos aplicar técnicas similares a los perros?'", recuerda Berns.

El primer desafío fue crear contenido de video que un perro pudiera encontrar lo suficientemente interesante como para verlo durante un período prolongado. El equipo de investigación de Emory colocó una grabadora de video en un cardán y un palo para selfies que les permitió tomar imágenes estables desde la perspectiva de un perro, aproximadamente a la altura de la cintura de un humano o un poco más abajo.

Usaron el dispositivo para crear un video de media hora de escenas relacionadas con la vida de la mayoría de los perros. Las actividades incluyeron perros acariciados por personas y recibiendo golosinas de personas. Las escenas con perros también los mostraban olfateando, jugando, comiendo o paseando con correa. Las escenas de actividad mostraban autos, bicicletas o un scooter pasando por una carretera; un gato caminando en una casa; un ciervo cruzando un camino; gente sentada; gente abrazándose o besándose; personas que ofrecen un hueso de goma o una pelota a la cámara; y gente comiendo.

Los datos de video se segmentaron por marcas de tiempo en varios clasificadores, incluidos clasificadores basados en objetos (como perros, automóviles, humanos, gatos) y clasificadores basados en acciones (como olfatear, jugar o comer).

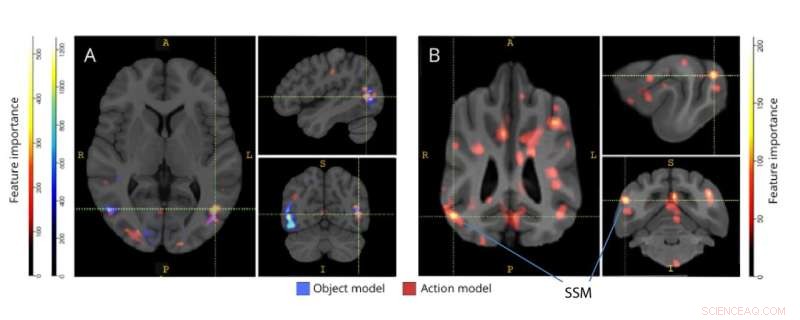

Regiones importantes para la discriminación de modelos de objetos de tres clases y de acción de cinco clases. (A) Participantes humanos y (B) caninos. Los vóxeles se clasificaron según la importancia de sus características utilizando un clasificador de bosque aleatorio, promediado en todas las iteraciones de los modelos. El 5% superior de los vóxeles (es decir, los que se utilizan para entrenar modelos) se presentan aquí, agregados por especie y transformados en espacio de grupo para fines de visualización. Las etiquetas muestran regiones del cerebro del perro con puntajes de importancia de característica altos, según las identificadas por Johnson et al. Abreviatura:SSM =la circunvolución suprasilviana. Crédito:Diario de Experimentos Visualizados (2022). DOI:10.3791/64442

Solo dos de los perros que habían sido entrenados para experimentos en una fMRI tenían el enfoque y el temperamento para quedarse completamente quietos y ver el video de 30 minutos sin interrupción, incluidas tres sesiones por un total de 90 minutos. Estos dos caninos "superestrellas" eran Daisy, una raza mixta que puede ser en parte Boston terrier, y Bhubo, una raza mixta que puede ser en parte boxeador.

"Ni siquiera necesitaban golosinas", dice Phillips, quien monitoreó a los animales durante las sesiones de fMRI y observó sus ojos siguiendo el video. "Fue divertido porque es ciencia seria, y se dedicó mucho tiempo y esfuerzo, pero se redujo a estos perros viendo videos de otros perros y humanos actuando un poco tontos".

Dos humanos también se sometieron al mismo experimento, viendo el mismo video de 30 minutos en tres sesiones separadas, mientras estaban acostados en una resonancia magnética funcional.

Los datos del cerebro podrían mapearse en los clasificadores de video utilizando marcas de tiempo.

Se aplicó a los datos un algoritmo de aprendizaje automático, una red neuronal conocida como Ivis. Una red neuronal es un método para hacer aprendizaje automático al hacer que una computadora analice ejemplos de entrenamiento. En este caso, la red neuronal fue entrenada para clasificar el contenido de datos cerebrales.

Los resultados de los dos sujetos humanos encontraron que el modelo desarrollado usando la red neuronal mostró una precisión del 99 % en el mapeo de los datos del cerebro en los clasificadores basados en objetos y en acciones.

En el caso de decodificar contenido de video de los perros, el modelo no funcionó para los clasificadores de objetos. Sin embargo, tuvo una precisión del 75 % al 88 % al decodificar las clasificaciones de acción para los perros.

Los resultados sugieren diferencias importantes en cómo funcionan los cerebros de humanos y perros.

"Los humanos estamos muy orientados a objetos", dice Berns. "Hay 10 veces más sustantivos que verbos en el idioma inglés porque tenemos una obsesión particular con nombrar objetos. Los perros parecen estar menos preocupados por quién o qué están viendo y más preocupados por la acción en sí".

Los perros y los humanos también tienen grandes diferencias en sus sistemas visuales, señala Berns. Los perros solo ven en tonos de azul y amarillo, pero tienen una densidad ligeramente mayor de receptores de visión diseñados para detectar movimiento.

"Tiene mucho sentido que los cerebros de los perros estén muy sintonizados con las acciones en primer lugar", dice. "Los animales deben estar muy preocupados por las cosas que suceden en su entorno para evitar que se los coman o para controlar a los animales que podrían querer cazar. La acción y el movimiento son primordiales".

Para Philips, comprender cómo los diferentes animales perciben el mundo es importante para su investigación de campo actual sobre cómo la reintroducción de depredadores en Mozambique puede afectar los ecosistemas. "Históricamente, no ha habido mucha superposición en informática y ecología", dice ella. "Pero el aprendizaje automático es un campo en crecimiento que está comenzando a encontrar aplicaciones más amplias, incluso en ecología".

Otros autores del artículo incluyen a Daniel Dilks, profesor asociado de psicología de Emory, y Kirsten Gillette, quien trabajó en el proyecto como estudiante de pregrado en neurociencia y biología del comportamiento de Emory. Desde entonces, Gilette se graduó y ahora está en un programa de posgrado en la Universidad de Carolina del Norte.

Daisy es propiedad de Rebecca Beasley y Bhubo es propiedad de Ashwin Sakhardande. El dilema de un perro:¿Prefieren los caninos los elogios o la comida?