Crédito:La conversación

Facebook ha estado experimentando discretamente con la reducción de la cantidad de contenido político que pone en las noticias de los usuarios. La medida es un reconocimiento tácito de que la forma en que funcionan los algoritmos de la empresa puede ser un problema.

El meollo del asunto es la distinción entre provocar una respuesta y proporcionar el contenido que la gente quiere. Los algoritmos de las redes sociales, las reglas que siguen sus computadoras para decidir el contenido que ve, dependen en gran medida del comportamiento de las personas para tomar estas decisiones. En particular, miran el contenido al que las personas responden o con el que "interaccionan" dando me gusta, comentando y compartiendo.

Como científico informático que estudia las formas en que un gran número de personas interactúan mediante la tecnología, entiendo la lógica de utilizar la sabiduría de las multitudes en estos algoritmos. También veo dificultades sustanciales en la forma en que las empresas de redes sociales lo hacen en la práctica.

De leones en la sabana a me gusta en Facebook

El concepto de la sabiduría de las multitudes supone que el uso de señales de las acciones, opiniones y preferencias de los demás como guía conducirá a decisiones acertadas. Por ejemplo, las predicciones colectivas suelen ser más precisas que las individuales. La inteligencia colectiva se utiliza para predecir mercados financieros, deportes, elecciones e incluso brotes de enfermedades.

A lo largo de millones de años de evolución, estos principios se han codificado en el cerebro humano en forma de sesgos cognitivos que vienen con nombres como familiaridad, mera exposición y efecto de carro. Si todos empiezan a correr, tú también deberías empezar a correr; tal vez alguien vio a un león venir y correr podría salvarte la vida. Puede que no sepa por qué, pero es mejor hacer las preguntas más tarde.

Su cerebro recoge pistas del entorno, incluidos sus compañeros, y usa reglas simples para traducir rápidamente esas señales en decisiones:Vaya con el ganador, siga a la mayoría, copie a su vecino. Estas reglas funcionan notablemente bien en situaciones típicas porque se basan en suposiciones sólidas. Por ejemplo, asumen que las personas a menudo actúan racionalmente, es poco probable que muchos se equivoquen, el pasado predice el futuro, etc.

La tecnología permite que las personas accedan a señales de un número mucho mayor de otras personas, la mayoría de las cuales no conocen. Las aplicaciones de inteligencia artificial hacen un uso intensivo de estas señales de popularidad o "compromiso", desde la selección de resultados del motor de búsqueda hasta la recomendación de música y videos, y desde la sugerencia de amigos hasta la clasificación de publicaciones en las fuentes de noticias.

No todo lo viral merece serlo

Nuestra investigación muestra que prácticamente todas las plataformas de tecnología web, como las redes sociales y los sistemas de recomendación de noticias, tienen un fuerte sesgo de popularidad. Cuando las aplicaciones están impulsadas por señales como el compromiso en lugar de consultas explícitas del motor de búsqueda, el sesgo de popularidad puede tener consecuencias dañinas no deseadas.

Las redes sociales como Facebook, Instagram, Twitter, YouTube y TikTok dependen en gran medida de los algoritmos de inteligencia artificial para clasificar y recomendar contenido. Estos algoritmos toman como entrada lo que le "gusta", comenta y comparte; en otras palabras, el contenido con el que interactúa. El objetivo de los algoritmos es maximizar la participación averiguando lo que le gusta a la gente y clasificándolo en la parte superior de sus feeds.

En la superficie esto parece razonable. Si a la gente le gustan las noticias creíbles, las opiniones de expertos y los videos divertidos, estos algoritmos deberían identificar ese contenido de alta calidad. Pero la sabiduría de las multitudes hace una suposición clave aquí:recomendar lo que es popular ayudará a que el contenido de alta calidad "salga".

Probamos esta suposición mediante el estudio de un algoritmo que clasifica los elementos utilizando una combinación de calidad y popularidad. Descubrimos que, en general, es más probable que el sesgo de popularidad reduzca la calidad general del contenido. La razón es que el compromiso no es un indicador confiable de calidad cuando pocas personas han estado expuestas a un artículo. En estos casos, el compromiso genera una señal ruidosa y es probable que el algoritmo amplifique este ruido inicial. Una vez que la popularidad de un artículo de baja calidad es lo suficientemente grande, seguirá ampliándose.

Los algoritmos no son lo único afectado por el sesgo de participación, también puede afectar a las personas. La evidencia muestra que la información se transmite a través de un "contagio complejo", lo que significa que cuantas más veces alguien esté expuesto a una idea en línea, es más probable que la adopte y la comparta. Cuando las redes sociales les dicen a las personas que un elemento se está volviendo viral, sus sesgos cognitivos se activan y se traducen en la necesidad irresistible de prestarle atención y compartirlo.

Multitudes no tan sabias

Recientemente realizamos un experimento con una aplicación de alfabetización noticiosa llamada Fakey. Es un juego desarrollado por nuestro laboratorio, que simula un feed de noticias como los de Facebook y Twitter. Los jugadores ven una combinación de artículos actuales de noticias falsas, ciencia basura, fuentes hiperpartidistas y conspirativas, así como fuentes convencionales. Obtienen puntos por compartir o dar me gusta a noticias de fuentes confiables y por marcar artículos de baja credibilidad para verificación de hechos.

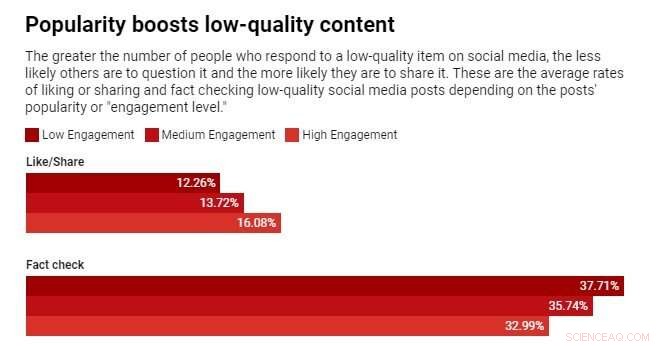

Descubrimos que es más probable que los jugadores den Me gusta o compartan y es menos probable que marquen artículos de fuentes de baja credibilidad cuando los jugadores pueden ver que muchos otros usuarios han interactuado con esos artículos. La exposición a las métricas de interacción crea una vulnerabilidad.

La sabiduría de las multitudes falla porque se basa en la falsa suposición de que la multitud se compone de fuentes diversas e independientes. Puede haber varias razones por las que este no es el caso.

Primero, debido a la tendencia de las personas a asociarse con personas similares, sus vecindarios en línea no son muy diversos. La facilidad con la que un usuario de las redes sociales puede dejar de ser amigo de aquellos con los que no está de acuerdo empuja a las personas a formar comunidades homogéneas, a menudo denominadas cámaras de eco.

En segundo lugar, debido a que los amigos de muchas personas son amigos entre sí, se influyen mutuamente. Un famoso experimento demostró que saber qué música les gusta a tus amigos afecta tus propias preferencias. Su deseo social de conformarse distorsiona su juicio independiente.

En tercer lugar, las señales de popularidad pueden jugarse. A lo largo de los años, los motores de búsqueda han desarrollado técnicas sofisticadas para contrarrestar las llamadas "granjas de enlaces" y otros esquemas para manipular los algoritmos de búsqueda. Las plataformas de redes sociales, por otro lado, recién comienzan a aprender sobre sus propias vulnerabilidades.

Las personas que buscan manipular el mercado de la información han creado cuentas falsas, como trolls y bots sociales, y han organizado redes falsas. Han inundado la red para crear la apariencia de que una teoría de la conspiración o un candidato político es popular, engañando tanto a los algoritmos de la plataforma como a los sesgos cognitivos de las personas a la vez. Incluso han alterado la estructura de las redes sociales para crear ilusiones sobre las opiniones mayoritarias.

Disminuir el compromiso

¿Qué hacer? Las plataformas tecnológicas están actualmente a la defensiva. Se están volviendo más agresivos durante las elecciones para eliminar cuentas falsas e información errónea dañina. Pero estos esfuerzos pueden ser similares a un juego de golpear un topo.

Un enfoque diferente y preventivo sería agregar fricción. En otras palabras, para ralentizar el proceso de difusión de la información. Los comportamientos de alta frecuencia, como los me gusta y el uso compartido automático, podrían inhibirse mediante las pruebas o tarifas de CAPTCHA. Esto no solo disminuiría las oportunidades de manipulación, sino que, con menos información, las personas podrían prestar más atención a lo que ven. Dejaría menos espacio para que el sesgo de participación afecte las decisiones de las personas.

También ayudaría si las empresas de redes sociales ajustaran sus algoritmos para depender menos del compromiso para determinar el contenido que le ofrecen.