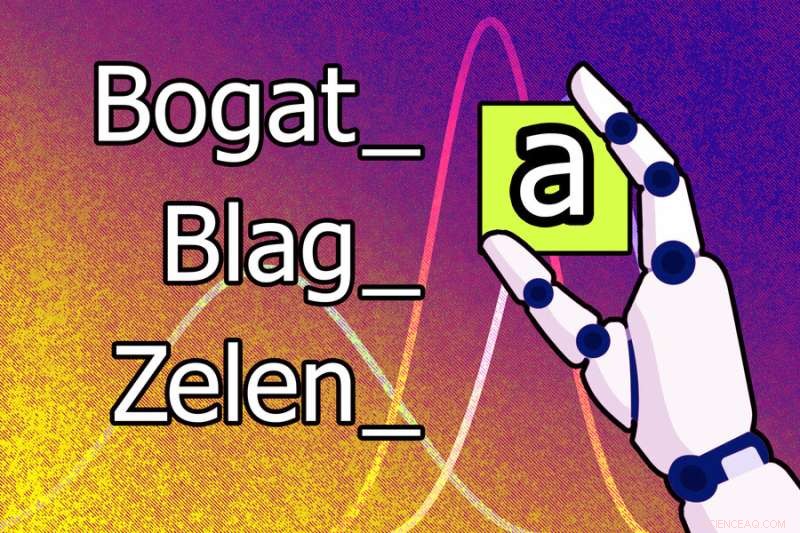

Un nuevo modelo de aprendizaje automático podría aprender que la letra "a" debe agregarse al final de una palabra para hacer que la forma masculina sea femenina en serbocroata. Por ejemplo, la forma masculina de la palabra “bogat” se convierte en el femenino “bogata”. Crédito:José-Luis Olivares, MIT

Los lenguajes humanos son notoriamente complejos, y los lingüistas han pensado durante mucho tiempo que sería imposible enseñarle a una máquina cómo analizar los sonidos del habla y las estructuras de las palabras de la forma en que lo hacen los investigadores humanos.

Pero los investigadores del MIT, la Universidad de Cornell y la Universidad McGill han dado un paso en esta dirección. Han demostrado un sistema de inteligencia artificial que puede aprender las reglas y patrones de los lenguajes humanos por sí solo.

Cuando se le dan palabras y ejemplos de cómo esas palabras cambian para expresar diferentes funciones gramaticales (como tiempo, caso o género) en un idioma, este modelo de aprendizaje automático presenta reglas que explican por qué cambian las formas de esas palabras. Por ejemplo, podría aprender que la letra "a" debe agregarse al final de una palabra para convertir la forma masculina en femenina en serbocroata.

Este modelo también puede aprender automáticamente patrones de lenguaje de nivel superior que se pueden aplicar a muchos idiomas, lo que le permite lograr mejores resultados.

Los investigadores entrenaron y probaron el modelo utilizando problemas de libros de texto de lingüística que presentaban 58 idiomas diferentes. Cada problema tenía un conjunto de palabras y los correspondientes cambios en la forma de las palabras. El modelo pudo generar un conjunto correcto de reglas para describir esos cambios en la forma de las palabras en el 60 % de los problemas.

Este sistema podría usarse para estudiar hipótesis lingüísticas e investigar similitudes sutiles en la forma en que diversos idiomas transforman palabras. Es especialmente único porque el sistema descubre modelos que los humanos pueden entender fácilmente y adquiere estos modelos a partir de pequeñas cantidades de datos, como unas pocas docenas de palabras. Y en lugar de usar un conjunto de datos masivo para una sola tarea, el sistema utiliza muchos conjuntos de datos pequeños, lo que se acerca más a cómo los científicos proponen hipótesis:analizan múltiples conjuntos de datos relacionados y crean modelos para explicar los fenómenos en esos conjuntos de datos.

"Una de las motivaciones de este trabajo fue nuestro deseo de estudiar sistemas que aprendan modelos de conjuntos de datos que se representen de una manera que los humanos puedan entender. En lugar de aprender pesos, ¿puede el modelo aprender expresiones o reglas? Y queríamos ver si podíamos podría construir este sistema para que aprendiera sobre una batería completa de conjuntos de datos interrelacionados, para que el sistema aprenda un poco sobre cómo modelar mejor cada uno", dice Kevin Ellis, profesor asistente de ciencias de la computación en la Universidad de Cornell y autor principal de el papel.

Junto a Ellis en el artículo están los miembros de la facultad del MIT Adam Albright, profesor de lingüística; Armando Solar-Lezama, profesor y director asociado del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL); y Joshua B. Tenenbaum, Profesor de Desarrollo de Carrera Paul E. Newton de Ciencias Cognitivas y Computación en el Departamento de Ciencias Cerebrales y Cognitivas y miembro de CSAIL; así como el autor principal Timothy J. O'Donnell, profesor asistente en el Departamento de Lingüística de la Universidad McGill y presidente de Canadá CIFAR AI en el Instituto de Inteligencia Artificial Mila-Quebec.

La investigación se publica hoy en Nature Communications .

Mirando el lenguaje

En su búsqueda por desarrollar un sistema de IA que pudiera aprender automáticamente un modelo a partir de múltiples conjuntos de datos relacionados, los investigadores optaron por explorar la interacción de la fonología (el estudio de los patrones de sonido) y la morfología (el estudio de la estructura de las palabras).

Los datos de los libros de texto de lingüística ofrecieron un banco de pruebas ideal porque muchos idiomas comparten características centrales y los problemas de los libros de texto muestran fenómenos lingüísticos específicos. Los estudiantes universitarios también pueden resolver los problemas de los libros de texto de una manera bastante sencilla, pero esos estudiantes suelen tener conocimientos previos sobre fonología de lecciones anteriores que utilizan para razonar sobre nuevos problemas.

Ellis, quien obtuvo su Ph.D. en el MIT y fue asesorado conjuntamente por Tenenbaum y Solar-Lezama, aprendió por primera vez sobre morfología y fonología en una clase del MIT impartida conjuntamente por O'Donnell, quien era un postdoctorado en ese momento, y Albright.

"Los lingüistas han pensado que para comprender realmente las reglas de un lenguaje humano, para empatizar con lo que hace que el sistema funcione, tienes que ser humano. Queríamos ver si podemos emular los tipos de conocimiento y razonamiento que los humanos (lingüistas) aportan a la tarea", dice Albright.

Para construir un modelo que pudiera aprender un conjunto de reglas para ensamblar palabras, lo que se denomina gramática, los investigadores utilizaron una técnica de aprendizaje automático conocida como aprendizaje de programa bayesiano. Con esta técnica, el modelo resuelve un problema escribiendo un programa de computadora.

En este caso, el programa es la gramática que el modelo cree que es la explicación más probable de las palabras y significados en un problema lingüístico. Construyeron el modelo utilizando Sketch, un sintetizador de programa popular que fue desarrollado en el MIT por Solar-Lezama.

Pero Sketch puede tomar mucho tiempo para razonar sobre el programa más probable. Para evitar esto, los investigadores hicieron que el modelo trabajara pieza por pieza, escribiendo un pequeño programa para explicar algunos datos, luego escribiendo un programa más grande que modifica ese pequeño programa para cubrir más datos, y así sucesivamente.

También diseñaron el modelo para que aprenda cómo tienden a ser los "buenos" programas. Por ejemplo, podría aprender algunas reglas generales sobre problemas simples en ruso que aplicaría a un problema más complejo en polaco porque los idiomas son similares. Esto facilita que el modelo resuelva el problema polaco.

Abordar problemas de libros de texto

Cuando probaron el modelo utilizando 70 problemas de libros de texto, fue capaz de encontrar una gramática que coincidía con todo el conjunto de palabras del problema en el 60 % de los casos y coincidía correctamente con la mayoría de los cambios de forma de palabra en el 79 % de los problemas.

Los investigadores también intentaron preprogramar el modelo con algunos conocimientos que "deberían" haber aprendido si estuviera tomando un curso de lingüística y demostraron que podía resolver mejor todos los problemas.

"Un desafío de este trabajo fue averiguar si lo que estaba haciendo el modelo era razonable. Esta no es una situación en la que hay un número que es la única respuesta correcta. Hay una variedad de posibles soluciones que podría aceptar como correctas, cerca de la derecha, etc.", dice Albright.

A la modelo a menudo se le ocurrían soluciones inesperadas. En un caso, descubrió la respuesta esperada a un problema de idioma polaco, pero también otra respuesta correcta que aprovechó un error en el libro de texto. Esto demuestra que el modelo podría "depurar" los análisis lingüísticos, dice Ellis.

Los investigadores también realizaron pruebas que demostraron que el modelo podía aprender algunas plantillas generales de reglas fonológicas que podían aplicarse a todos los problemas.

"Una de las cosas más sorprendentes es que pudimos aprender varios idiomas, pero no pareció marcar una gran diferencia", dice Ellis. "Eso sugiere dos cosas. Tal vez necesitamos mejores métodos para aprender a través de los problemas. Y tal vez, si no podemos encontrar esos métodos, este trabajo puede ayudarnos a probar diferentes ideas que tenemos sobre qué conocimiento compartir a través de los problemas". /P>

En el futuro, los investigadores quieren usar su modelo para encontrar soluciones inesperadas a problemas en otros dominios. También podrían aplicar la técnica a más situaciones en las que se pueda aplicar conocimiento de alto nivel a través de conjuntos de datos interrelacionados. Por ejemplo, tal vez podrían desarrollar un sistema para inferir ecuaciones diferenciales a partir de conjuntos de datos sobre el movimiento de diferentes objetos, dice Ellis.

"Este trabajo muestra que tenemos algunos métodos que pueden, hasta cierto punto, aprender sesgos inductivos. Pero no creo que hayamos descubierto, incluso para estos problemas de libros de texto, el sesgo inductivo que permite a un lingüista aceptar las gramáticas plausibles. y rechazar los ridículos”, añade.

"Este trabajo abre muchos lugares emocionantes para futuras investigaciones. Estoy particularmente intrigado por la posibilidad de que el enfoque explorado por Ellis y sus colegas (Bayesian Program Learning, BPL) pueda hablar sobre cómo los bebés adquieren el lenguaje", dice T. Florian Jaeger, un profesor de ciencias del cerebro y cognitivas y de informática en la Universidad de Rochester, que no fue autor de este artículo.

"El trabajo futuro podría preguntar, por ejemplo, bajo qué sesgos de inducción adicionales (suposiciones sobre la gramática universal) el enfoque BPL puede lograr con éxito un comportamiento de aprendizaje similar al humano en el tipo de datos que los bebés observan durante la adquisición del lenguaje. Creo que sería fascinante ver si los sesgos inductivos que son incluso más abstractos que los considerados por Ellis y su equipo, como los sesgos que se originan en los límites del procesamiento de la información humana (por ejemplo, restricciones de memoria en la duración de la dependencia o límites de capacidad en la cantidad de información que se puede procesar por tiempo ), sería suficiente para inducir algunos de los patrones observados en los lenguajes humanos". El modelo de aprendizaje automático puede identificar la acción en un videoclip y etiquetarla, sin la ayuda de humanos