Crédito:Ji Lin

Teléfonos inteligentes cámaras de seguridad, y los altavoces son solo algunos de los dispositivos que pronto ejecutarán más software de inteligencia artificial para acelerar las tareas de procesamiento de imágenes y voz. Una técnica de compresión conocida como cuantización está suavizando el camino al hacer que los modelos de aprendizaje profundo sean más pequeños para reducir los costos de computación y energía. Pero modelos más pequeños, resulta, facilitar que los atacantes malintencionados engañen a un sistema de IA para que se comporte mal, una preocupación ya que la toma de decisiones más compleja se transfiere a las máquinas.

En un nuevo estudio, Los investigadores de MIT e IBM muestran cuán vulnerables son los modelos de IA comprimidos a los ataques adversarios, y ofrecen una solución:agregan una restricción matemática durante el proceso de cuantificación para reducir las probabilidades de que una IA sea presa de una imagen ligeramente modificada y clasifique erróneamente lo que ven.

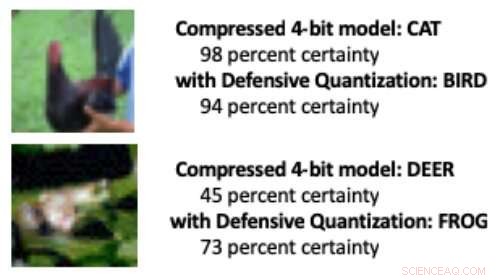

Cuando un modelo de aprendizaje profundo se reduce de los 32 bits estándar a una longitud de bits más baja, es más probable que se clasifiquen erróneamente las imágenes alteradas debido a un efecto de amplificación de error:la imagen manipulada se distorsiona más con cada capa adicional de procesamiento. Al terminar, es más probable que el modelo confunda un pájaro con un gato, por ejemplo, o una rana por un ciervo.

Los modelos cuantificados a 8 bits o menos son más susceptibles a los ataques adversarios, los investigadores muestran, con una precisión que cae de un ya bajo 30-40 por ciento a menos del 10 por ciento a medida que disminuye el ancho de bit. Pero controlar la restricción de Lipschitz durante la cuantificación restaura algo de resiliencia. Cuando los investigadores agregaron la restricción, vieron pequeñas mejoras de rendimiento en un ataque, con los modelos más pequeños en algunos casos superando al modelo de 32 bits.

Cuando se manipularon algunos píxeles en las imágenes anteriores para simular un ataque adverso, un modelo comprimido estándar clasificó erróneamente el pollo como "gato" y la rana como "ciervo". Pero cuando los investigadores agregaron una restricción durante la compresión, el modelo clasificó correctamente a los animales, incluso funciona mejor que un modelo de 32 bits de precisión total. Crédito:Instituto de Tecnología de Massachusetts

"Nuestra técnica limita la amplificación de errores e incluso puede hacer que los modelos de aprendizaje profundo comprimidos sean más robustos que los modelos de precisión total, "dice Song Han, profesor asistente en el Departamento de Ingeniería Eléctrica e Informática del MIT y miembro de los Laboratorios de Tecnología de Microsistemas del MIT. "Con la cuantificación adecuada, podemos limitar el error ".

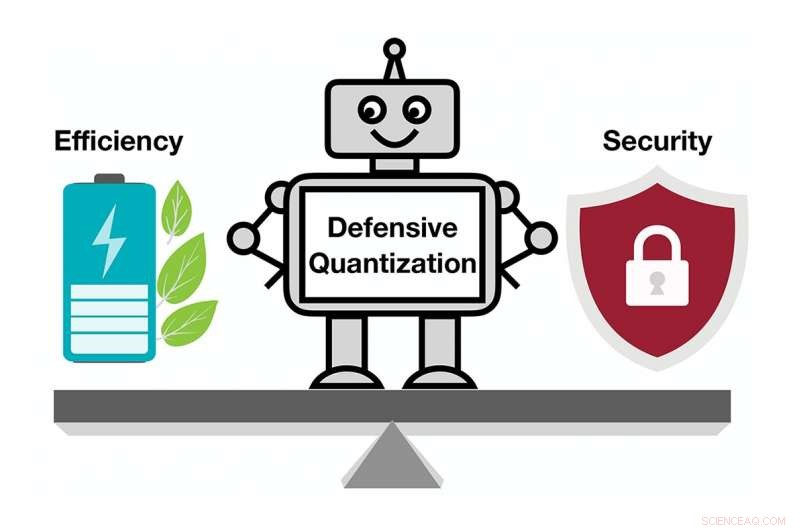

El equipo planea mejorar aún más la técnica entrenándola en conjuntos de datos más grandes y aplicándola a una gama más amplia de modelos. "Los modelos de aprendizaje profundo deben ser rápidos y seguros a medida que avanzan hacia un mundo de dispositivos conectados a Internet, "dice el coautor del estudio Chuang Gan, investigador del MIT-IBM Watson AI Lab. "Nuestra técnica de cuantificación defensiva ayuda en ambos frentes".

Los investigadores, que incluyen al estudiante graduado del MIT Ji Lin, presentar sus resultados en la Conferencia Internacional sobre Representaciones del Aprendizaje en mayo.

Al hacer que los modelos de IA sean más pequeños para que funcionen más rápido y consuman menos energía, Han está utilizando la propia IA para superar los límites de la tecnología de compresión de modelos. En un trabajo reciente relacionado, Han y sus colegas muestran cómo se puede utilizar el aprendizaje por refuerzo para encontrar automáticamente la longitud de bit más pequeña para cada capa en un modelo cuantificado en función de la rapidez con la que el dispositivo que ejecuta el modelo puede procesar imágenes. Este enfoque de ancho de bit flexible reduce la latencia y el uso de energía hasta en un 200 por ciento en comparación con un Modelo de 8 bits, dice Han. Los investigadores presentarán sus resultados en la conferencia Computer Vision and Pattern Recognition en junio.

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre la investigación del MIT, innovación y docencia.