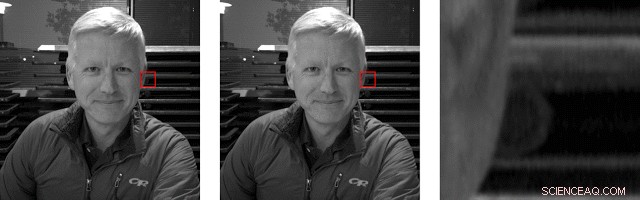

Las dos imágenes PDAF de la izquierda y del centro se ven muy similares, pero en el buche de la derecha se puede ver el paralaje entre ellos. Es más notable en la estructura circular en el medio del cultivo. Crédito:blog de Google

TechSpot dice lo que piensa sobre el Pixel 3 y no es un anuncio:"Pixel 3 es posiblemente el mejor teléfono con cámara del mercado". Tyler Lee en Ubergizmo está en modo de cumplido completo. "No hay duda de que todo el arduo trabajo y la investigación de Google han valido la pena, ya que el Pixel 3 tiene una de las mejores cámaras".

OK, lo entendemos. En la lucha constante de los proveedores por dominar el mercado de los teléfonos inteligentes, Pixel 3 está marcando con éxito su propio terreno como el teléfono con muy buenas capacidades de cámara. Y, ahora, un blog reciente en el blog de Google AI solo deleitará aún más a los fanáticos de Pixel 3, ya que detalla cómo se logró el "Modo retrato" en Pixel 3.

Piense en un equipo que recurre al aprendizaje automático, TensorFlow y objetivos de percepción de profundidad de punta a punta.

Scott Adam Gordon en Autoridad de Android compartió con los lectores lo que era bastante inteligente sobre el enfoque y las técnicas de Google. "Con la cámara de Google Pixel 3, Google incluyó más señales de profundidad para informar este efecto de desenfoque para una mayor precisión. Además del paralaje, Google utilizó la nitidez como indicador de profundidad (los objetos más distantes son menos nítidos que los objetos más cercanos) y la identificación de objetos del mundo real. Por ejemplo, la cámara podría reconocer el rostro de una persona en una escena, y averiguar qué tan cerca o lejos estaba en función de su número de píxeles en relación con los objetos que lo rodean ".

Rahul Garg, científico investigador y Neal Wadhwa, ingeniero de software, publicado el blog. "Este año, en el Pixel 3, recurrimos al aprendizaje automático para mejorar la estimación de profundidad y producir resultados aún mejores en el modo retrato ".

(Google hasta ahora se guardó la magia para sí mismos, dijo Isaiah Mayersen en TechSpot . "A medida que Google sigue allanando el camino en la fotografía de teléfonos inteligentes, tendremos que esperar y ver qué aportan los competidores ").

Esperar, ¿Qué es el modo retrato? Webopedia , gracias:

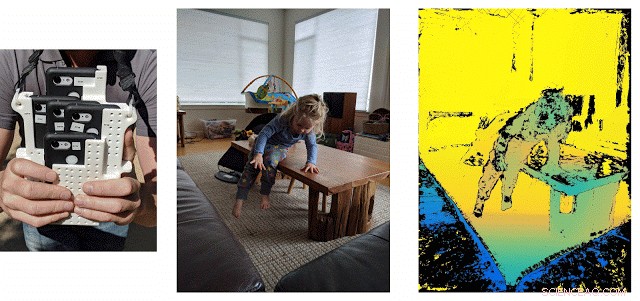

Izquierda:equipo personalizado utilizado para recopilar datos de entrenamiento. Medio:un ejemplo de captura cambiando entre las cinco imágenes. La sincronización entre las cámaras asegura que podamos calcular la profundidad para escenas dinámicas, como este. Derecha:profundidad de la verdad del suelo. Puntos de confianza bajos es decir., puntos donde las coincidencias estéreo no son confiables debido a una textura débil, son de color negro y no se utilizan durante el entrenamiento. Crédito:Sam Ansari y Mike Milne

"En fotografía y fotografía digital, El modo retrato es una función de la cámara digital que se utiliza cuando se toman fotografías de un solo sujeto. Al tomar fotografías en modo retrato, la cámara digital utilizará automáticamente una gran apertura para ayudar a mantener el fondo desenfocado mediante el uso de una profundidad de campo estrecha para que el sujeto fotografiado sea lo único que esté enfocado ".

No solo el sujeto individual, sino más:"No solo la persona en el retrato estará enfocada, los elementos cercanos al mismo plano de enfoque también serán más nítidos, con un desenfoque creciente realista a medida que los elementos están más adelante y detrás de ese plano, "dijo Ryne Hager en Policía de Android .

¿Lo tengo? Fondo intencionalmente desenfocado; el sujeto lleva el máximo impacto enfocado. Esta técnica se utiliza a menudo en anuncios y mensajes promocionales para atraer la máxima atención a un rostro al difuminar el fondo.

Google necesitaba algunas fotos para entrenar su IA. Ingrese como grupo de 5 teléfonos, de acuerdo, dicho más cortésmente, un conjunto de cinco teléfonos. Hablaron de mapas de profundidad, datos de entrenamiento y este ensamblaje, el "Frankenphone, "una plataforma con 5 teléfonos, todo Pixel 3, y solución basada en Wi-Fi.

CNET describió Frankenphone. "Un quinteto de teléfonos intercalados generó los datos para entrenar al Pixel 3 a juzgar la profundidad". Stephen Shankland describió un "grupo de cinco teléfonos pirateados para mejorar el funcionamiento de la función en el Pixel 3 de este año".

Usaron TensorFlow Lite, una solución multiplataforma para ejecutar modelos de aprendizaje automático en dispositivos móviles e integrados, y la GPU del Pixel 3 para calcular la profundidad rápidamente. Luego, combinaron las estimaciones de profundidad resultantes con máscaras de su "red neuronal de segmentación de personas para producir hermosos resultados en modo retrato".

Por qué esto es importante no requiere mucho análisis:mejores tomas en modo retrato.

En el panorama más amplio de los teléfonos inteligentes para tomar fotografías, los proveedores aceptan que su argumento de venta debería incluir características tentadoras de cámara. Los métodos de fotografía computacional de Google pueden darle a Pixel una ventaja real. "Los teléfonos inteligentes tienen sensores de imagen pequeños que no pueden competir con las cámaras tradicionales por la calidad de imagen, pero Google está a la vanguardia con métodos de fotografía computacional que pueden hacer cosas como desenfocar fondos, aumentar la resolución, modificar la exposición, mejorar los detalles de las sombras y tomar fotografías en la oscuridad, "dijo Stephen Shankland, CNET.

© 2018 Science X Network