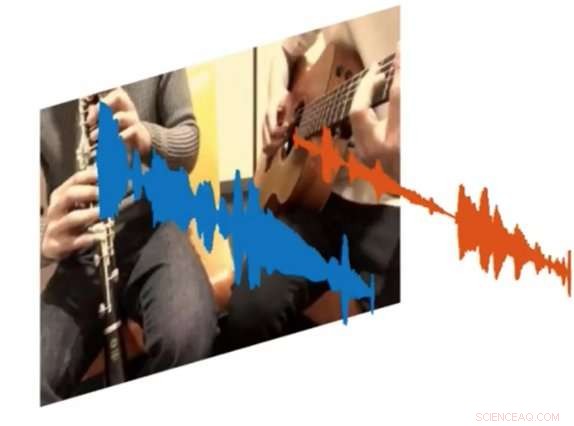

Un nuevo sistema de inteligencia artificial llamado PixelPlayer puede mirar una imagen y determinar qué conjunto de píxeles son responsables de crear conjuntos específicos de ondas sonoras. Crédito:MIT CSAIL

Tanto los músicos aficionados como los profesionales pueden pasar horas revisando los clips de YouTube para descubrir exactamente cómo tocar ciertas partes de sus canciones favoritas. Pero, ¿y si hubiera una forma de reproducir un video y aislar el único instrumento que quisiera escuchar?

Ese es el resultado de un nuevo proyecto de inteligencia artificial del Laboratorio de Ciencias de la Computación e Inteligencia Artificial del MIT (CSAIL):un sistema de aprendizaje profundo que puede ver un video de una actuación musical, y aislar los sonidos de instrumentos específicos y hacerlos más fuertes o más suaves.

El sistema, que es "autosupervisado, "no requiere anotaciones humanas sobre qué son los instrumentos o cómo suenan.

Capacitado en más de 60 horas de videos, el sistema "PixelPlayer" puede ver una interpretación musical nunca antes vista, identificar instrumentos específicos a nivel de píxel, y extraer los sonidos asociados con esos instrumentos.

Por ejemplo, puede tomar un video de una tuba y una trompeta tocando el tema principal de "Super Mario Brothers", y separe las ondas sonoras asociadas con cada instrumento.

Los investigadores dicen que la capacidad de cambiar el volumen de los instrumentos individuales significa que en el futuro, sistemas como este podrían ayudar a los ingenieros a mejorar la calidad de audio de las grabaciones de conciertos antiguos. Incluso podría imaginarse a los productores tomando partes de instrumentos específicos y haciendo una vista previa de cómo sonarían con otros instrumentos (es decir, una guitarra eléctrica intercambiada por una acústica).

En un nuevo periódico el equipo demostró que PixelPlayer puede identificar los sonidos de más de 20 instrumentos que se ven comúnmente. El autor principal, Hang Zhao, dice que el sistema podría identificar muchos más instrumentos si tuviera más datos de entrenamiento, aunque todavía puede tener problemas para manejar diferencias sutiles entre subclases de instrumentos (como un saxo alto versus un tenor).

Los esfuerzos anteriores para separar las fuentes de sonido se han centrado exclusivamente en el audio, que a menudo requiere un etiquetado humano extenso. A diferencia de, PixelPlayer introduce el elemento de visión, lo que, según los investigadores, hace innecesarias las etiquetas humanas, ya que la visión proporciona autosupervisión.

El sistema localiza primero las regiones de la imagen que producen sonidos, y luego separa los sonidos de entrada en un conjunto de componentes que representan el sonido de cada píxel.

"Esperábamos un escenario en el mejor de los casos en el que pudiéramos reconocer qué instrumentos producen qué tipos de sonidos, "dice Zhao, un doctorado estudiante en CSAIL. "Nos sorprendió que pudiéramos ubicar espacialmente los instrumentos a nivel de píxel. Ser capaz de hacer eso abre muchas posibilidades, como poder editar el audio de instrumentos individuales con un solo clic en el video ".

PixelPlayer utiliza métodos de "aprendizaje profundo, ", lo que significa que encuentra patrones en los datos mediante las llamadas" redes neuronales "que se entrenaron en videos existentes. Específicamente, una red neuronal analiza las imágenes del video, uno analiza el audio, y un tercer "sintetizador" asocia píxeles específicos con ondas sonoras específicas para separar los diferentes sonidos.

PixelPlayer también incluye una interfaz que permite a los usuarios cambiar el volumen de instrumentos específicos en la mezcla. Crédito:MIT CSAIL

El hecho de que PixelPlayer utilice el denominado aprendizaje profundo "auto-supervisado" significa que el equipo del MIT no comprende explícitamente todos los aspectos de cómo aprende qué instrumentos hacen qué sonidos.

Sin embargo, Zhao dice que puede decir que el sistema parece reconocer elementos reales de la música. Por ejemplo, ciertas frecuencias armónicas parecen correlacionarse con instrumentos como el violín, mientras que los patrones rápidos similares a pulsos corresponden a instrumentos como el xilófono.

Zhao dice que un sistema como PixelPlayer podría incluso usarse en robots para comprender mejor los sonidos ambientales que hacen otros objetos. como animales o vehículos.

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre la investigación del MIT, innovación y docencia.