Crédito:Juan Vargas, Jean-Philippe Avouac, Chris Rollins / Caltech

Los geofísicos de Caltech han creado un nuevo método para determinar los peligros de un terremoto midiendo qué tan rápido se acumula energía en las fallas en una región específica, y luego comparar eso con la cantidad que se libera a través del deslizamiento de fallas y los terremotos.

Aplicaron el nuevo método a las fallas debajo del centro de Los Ángeles, y descubrió que, en el promedio a largo plazo, el terremoto más fuerte que probablemente ocurra a lo largo de esas fallas es entre magnitud 6.8 y 7.1, y que una magnitud de 6.8 — aproximadamente un 50 por ciento más fuerte que el terremoto de Northridge de 1994 — podría ocurrir aproximadamente cada 300 años en promedio.

Eso no quiere decir que un terremoto más grande debajo del centro de Los Ángeles sea imposible, dicen los investigadores; bastante, descubren que la corteza debajo de Los Ángeles no parece estar siendo comprimida de sur a norte lo suficientemente rápido como para hacer que tal terremoto sea tan probable.

El método también permite una evaluación de la probabilidad de terremotos más pequeños. Si se excluyen las réplicas, la probabilidad de que ocurra un terremoto de magnitud 6.0 o mayor en el centro de Los Ángeles durante cualquier período de 10 años es de aproximadamente el 9 por ciento, mientras que la probabilidad de un terremoto de magnitud 6.5 o mayor es de alrededor del 2 por ciento.

Un artículo que describe estos hallazgos fue publicado por Cartas de investigación geofísica el 27 de febrero.

Estos niveles de peligro sísmico son algo más bajos pero no difieren significativamente de lo que ya ha sido predicho por el Grupo de Trabajo sobre Probabilidades de Terremotos de California. Pero ese es realmente el punto, dicen los científicos de Caltech.

Los métodos actuales de vanguardia para evaluar el peligro sísmico de un área implican generar una evaluación detallada de los tipos de rupturas sísmicas que se pueden esperar a lo largo de cada falla, un proceso complicado que se basa en supercomputadoras para generar un modelo final. Por el contrario, el nuevo método, desarrollado por el estudiante graduado de Caltech Chris Rollins y Jean-Philippe Avouac, Earle C. Anthony, profesor de geología e ingeniería mecánica y civil, es mucho más simple, confiando en el presupuesto de tensión y las estadísticas generales de terremotos en una región.

"Básicamente preguntamos, `` Dado que el centro de Los Ángeles está siendo exprimido de norte a sur a unos pocos milímetros por año, ¿Qué podemos decir acerca de la frecuencia con la que pueden ocurrir terremotos de diversas magnitudes en el área? ¿y qué tan grandes pueden llegar a ser los terremotos? '”, dice Rollins.

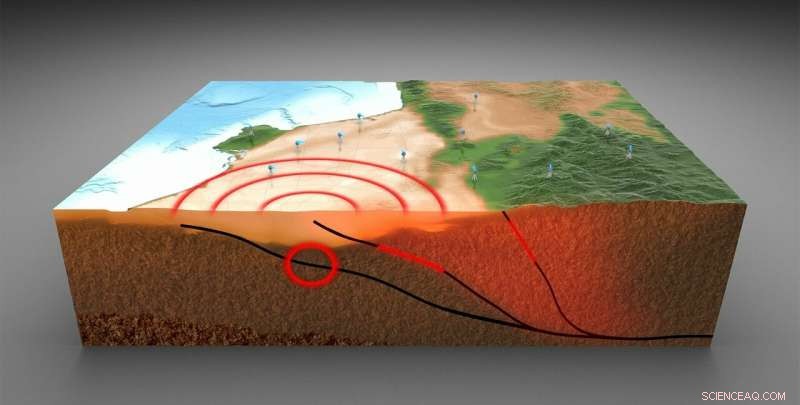

Cuando una placa tectónica empuja a otra, La deformación elástica se acumula a lo largo del límite entre las dos placas. La tensión aumenta hasta que una placa se desliza lentamente sobre la otra, o se sacude violentamente. Las sacudidas violentas se sienten como terremotos.

Afortunadamente, La curvatura gradual de la corteza entre terremotos se puede medir en la superficie estudiando cómo se deforma la superficie terrestre. En un estudio anterior (realizado en colaboración con el ingeniero de software de investigación de Caltech Walter Landry; Don Argus del Jet Propulsion Laboratory, que es administrado por Caltech para la NASA; y Sylvain Barbot de USC), Avouac y Rollins midieron el desplazamiento del suelo utilizando estaciones del sistema de posicionamiento global permanente (GPS) que forman parte de la red Plate Boundary Observatory, apoyado por la National Science Foundation (NSF) y la NASA. Las mediciones del GPS revelaron qué tan rápido se dobla la tierra debajo de Los Ángeles. A partir de ese, los investigadores calcularon cuánta tensión liberaba la fluencia y cuánta se almacenaba como tensión elástica disponible para impulsar terremotos.

El nuevo estudio evalúa si es más probable que esa tensión sísmica sea liberada por pequeños terremotos frecuentes o por uno muy grande. o algo intermedio. Avouac y Rollins examinaron el registro histórico de terremotos en Los Ángeles desde 1932 hasta 2017, según lo registrado por la Red Sísmica del Sur de California, y seleccionó el escenario que mejor se ajustaba al comportamiento observado en la región.

"Estimando la magnitud y frecuencia de los eventos más extremos, que no se puede suponer que se conozcan a partir de la historia o de observaciones instrumentales, es muy dificil. Nuestro método proporciona un marco para resolver ese problema y calcular las probabilidades de un terremoto, "dice Avouac.

Este nuevo método para estimar la probabilidad de un terremoto se puede aplicar fácilmente a otras áreas, ofreciendo una forma de evaluar los peligros sísmicos basada en principios físicos. "Ahora estamos refinando el método para tener en cuenta la distribución temporal de terremotos pasados, para que las previsiones sean más precisas, y estamos adaptando el marco para que pueda aplicarse a la sismicidad inducida, "Dice Avouac.

El estudio se titula "Un modelo de probabilidad de terremoto local basado en geodesia y sismicidad para el centro de Los Ángeles".