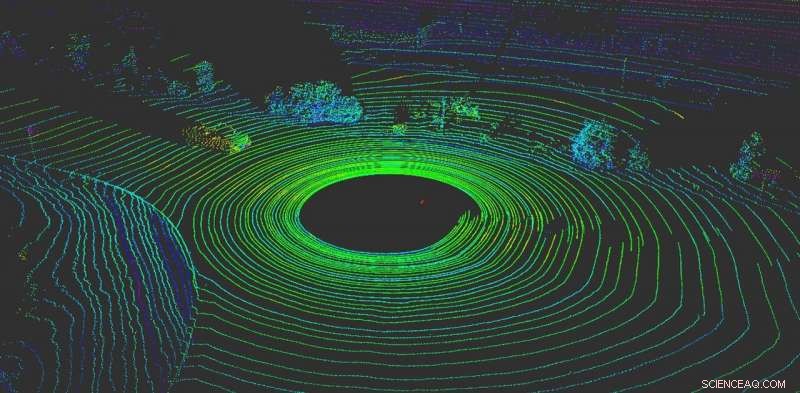

LiDAR ayuda a un vehículo autónomo a "visualizar" lo que hay a su alrededor. Crédito:Yulong Can con datos de Baidu Apollo, CC BY-ND

Nada es más importante para un vehículo autónomo que detectar lo que sucede a su alrededor. Como conductores humanos, Los vehículos autónomos necesitan la capacidad de tomar decisiones instantáneas.

Hoy dia, la mayoría de los vehículos autónomos dependen de múltiples sensores para percibir el mundo. La mayoría de los sistemas utilizan una combinación de cámaras, sensores de radar y sensores LiDAR (detección de luz y rango). A bordo, las computadoras fusionan estos datos para crear una vista completa de lo que sucede alrededor del automóvil. Sin estos datos, los vehículos autónomos no tendrían ninguna esperanza de navegar con seguridad por el mundo. Los automóviles que utilizan múltiples sistemas de sensores funcionan mejor y son más seguros (cada sistema puede servir como control de los demás), pero ningún sistema es inmune a los ataques.

Desafortunadamente, estos sistemas no son infalibles. Los sistemas de percepción basados en cámaras se pueden engañar simplemente colocando pegatinas en las señales de tráfico para cambiar completamente su significado.

Nuestro trabajo, del Grupo de Investigación RobustNet de la Universidad de Michigan, ha demostrado que el sistema de percepción basado en LiDAR puede estar compuesto, también. Al falsificar estratégicamente las señales del sensor LiDAR, el ataque puede engañar al sistema de percepción basado en LiDAR del vehículo para que "vea" un obstáculo inexistente. Si esto pasa, un vehículo podría causar un choque al bloquear el tráfico o frenar bruscamente.

Spoofing de señales LiDAR

Los sistemas de percepción basados en LiDAR tienen dos componentes:el sensor y el modelo de aprendizaje automático que procesa los datos del sensor. Un sensor LiDAR calcula la distancia entre él y su entorno emitiendo una señal de luz y midiendo cuánto tiempo tarda esa señal en rebotar en un objeto y regresar al sensor. Esta duración de este ida y vuelta también se conoce como el "tiempo de vuelo".

Una unidad LiDAR envía decenas de miles de señales luminosas por segundo. Luego, su modelo de aprendizaje automático utiliza los pulsos devueltos para pintar una imagen del mundo que rodea al vehículo. Es similar a cómo un murciélago usa la ecolocalización para saber dónde están los obstáculos durante la noche.

El problema es que estos pulsos pueden falsificarse. Para engañar al sensor, un atacante puede dirigir su propia señal luminosa al sensor. Eso es todo lo que necesita para mezclar el sensor.

Sin embargo, es más difícil falsificar el sensor LiDAR para "ver" un "vehículo" que no está allí. Para triunfar, el atacante necesita cronometrar con precisión las señales disparadas a la víctima LiDAR. Esto tiene que suceder a nivel de nanosegundos, ya que las señales viajan a la velocidad de la luz. Las pequeñas diferencias se destacarán cuando el LiDAR calcule la distancia utilizando el tiempo de vuelo medido.

Si un atacante engaña con éxito al sensor LiDAR, luego también tiene que engañar al modelo de aprendizaje automático. El trabajo realizado en el laboratorio de investigación de OpenAI muestra que los modelos de aprendizaje automático son vulnerables a señales o entradas especialmente diseñadas, lo que se conoce como ejemplos contradictorios. Por ejemplo, Las pegatinas generadas especialmente en las señales de tráfico pueden engañar la percepción basada en la cámara.

Descubrimos que un atacante podría usar una técnica similar para crear perturbaciones que funcionen contra LiDAR. No serían una pegatina visible, pero señales falsas creadas especialmente para engañar al modelo de aprendizaje automático haciéndole creer que hay obstáculos presentes cuando en realidad no los hay. El sensor LiDAR enviará las señales falsas del pirata informático al modelo de aprendizaje automático, que los reconocerá como un obstáculo.

El ejemplo contradictorio, el objeto falso, podría diseñarse para cumplir con las expectativas del modelo de aprendizaje automático. Por ejemplo, el atacante podría crear la señal de un camión que no se está moviendo. Luego, para realizar el ataque, pueden instalarlo en una intersección o colocarlo en un vehículo que se conduce delante de un vehículo autónomo.

Dos posibles ataques

Para demostrar el ataque diseñado, Elegimos un sistema de conducción autónomo utilizado por muchos fabricantes de automóviles:Baidu Apollo. Este producto cuenta con más de 100 socios y ha llegado a un acuerdo de producción en masa con varios fabricantes, incluidos Volvo y Ford.

Mediante el uso de datos de sensores del mundo real recopilados por el equipo de Baidu Apollo, demostramos dos ataques diferentes. En el primero, un "ataque de freno de emergencia, "mostramos cómo un atacante puede detener repentinamente un vehículo en movimiento engañándolo para que piense que aparece un obstáculo en su camino. En el segundo, un "ataque de congelación AV, "Usamos un obstáculo falso para engañar a un vehículo que había sido detenido en un semáforo en rojo para que permaneciera detenido después de que el semáforo cambia a verde.

Aprovechando las vulnerabilidades de los sistemas de percepción de conducción autónoma, Esperamos activar una alarma para los equipos que construyen tecnologías autónomas. La investigación sobre nuevos tipos de problemas de seguridad en los sistemas de conducción autónoma apenas está comenzando. y esperamos descubrir más problemas posibles antes de que los malos actores puedan explotarlos en la carretera.

Este artículo se vuelve a publicar de The Conversation bajo una licencia Creative Commons. Lea el artículo original.