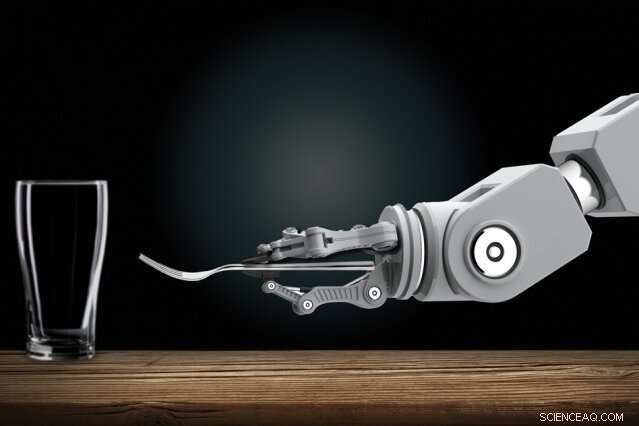

Los especialistas en robótica están desarrollando robots automatizados que pueden aprender nuevas tareas únicamente observando a los humanos. En casa, Es posible que algún día le muestres a un robot doméstico cómo hacer las tareas rutinarias. Crédito:Christine Daniloff, MIT

La formación de robots interactivos puede que algún día sea una tarea fácil para todos, incluso aquellos sin experiencia en programación. Los especialistas en robótica están desarrollando robots automatizados que pueden aprender nuevas tareas únicamente observando a los humanos. En casa, Es posible que algún día le muestres a un robot doméstico cómo hacer las tareas rutinarias. En el lugar de trabajo, podrías entrenar robots como nuevos empleados, mostrándoles cómo realizar muchas tareas.

Avanzando en esa visión, Los investigadores del MIT han diseñado un sistema que permite que este tipo de robots aprendan tareas complicadas que de otro modo los bloquearían con demasiadas reglas confusas. Una de esas tareas es poner la mesa para cenar bajo ciertas condiciones.

En su centro, El sistema de los investigadores "Planificación con especificaciones inciertas" (PUnS) proporciona a los robots la capacidad de planificación similar a la humana para sopesar simultáneamente muchos requisitos ambiguos y potencialmente contradictorios para alcanzar un objetivo final. Al hacerlo, el sistema siempre elige la acción más probable a tomar, basado en una "creencia" sobre algunas especificaciones probables para la tarea que se supone que debe realizar.

En su trabajo, los investigadores compilaron un conjunto de datos con información sobre cómo ocho objetos (una taza, vidrio, cuchara, tenedor, cuchillo, plato de cena, plato pequeño, y cuenco:se pueden colocar sobre una mesa en varias configuraciones. Un brazo robótico observó por primera vez demostraciones humanas seleccionadas al azar de poner la mesa con los objetos. Luego, los investigadores encargaron al brazo que colocara automáticamente una mesa en una configuración específica, en experimentos del mundo real y en simulación, basado en lo que había visto.

Para triunfar, el robot tuvo que sopesar muchos posibles ordenamientos de ubicación, incluso cuando los elementos se eliminaron intencionalmente, apilado u oculto. Normalmente, todo eso confundiría demasiado a los robots. Pero el robot de los investigadores no cometió errores en varios experimentos del mundo real, y solo un puñado de errores en decenas de miles de ejecuciones de prueba simuladas.

"La visión es poner la programación en manos de expertos en el dominio, quién puede programar robots de forma intuitiva, en lugar de describir órdenes a un ingeniero para que las agregue a su código, "dice el primer autor Ankit Shah, estudiante de posgrado en el Departamento de Aeronáutica y Astronáutica (AeroAstro) y el Grupo de Robótica Interactiva, quien enfatiza que su trabajo es solo un paso en el cumplimiento de esa visión. "De esa manera, los robots ya no tendrán que realizar tareas preprogramadas. Los trabajadores de la fábrica pueden enseñarle a un robot a realizar múltiples tareas de ensamblaje complejas. Los robots domésticos pueden aprender a apilar armarios, llena el lavaplatos, o poner la mesa de la gente en casa ".

Junto a Shah en el papel están la estudiante graduada de AeroAstro e Interactive Robotics Group, Shen Li, y la líder del Interactive Robotics Group, Julie Shah, profesor asociado en AeroAstro y el Laboratorio de Ciencias de la Computación e Inteligencia Artificial.

Bots de cobertura de apuestas

Los robots son buenos planificadores en tareas con "especificaciones claras, "que ayudan a describir la tarea que debe realizar el robot, considerando sus acciones, medio ambiente, y meta final. Aprender a poner la mesa observando demostraciones, está lleno de especificaciones inciertas. Los artículos deben colocarse en ciertos lugares, dependiendo del menú y donde se sientan los invitados, y en ciertos órdenes, dependiendo de la disponibilidad inmediata de un artículo o de las convenciones sociales. Los enfoques actuales de planificación no son capaces de hacer frente a especificaciones tan inciertas.

Un enfoque popular de la planificación es el "aprendizaje por refuerzo, "una técnica de aprendizaje automático de prueba y error que los recompensa y penaliza por acciones mientras trabajan para completar una tarea. Pero para tareas con especificaciones inciertas, es difícil definir recompensas y sanciones claras. En breve, los robots nunca aprenden completamente el bien del mal.

El sistema de los investigadores, llamado PUnS (para planificación con especificaciones inciertas), permite a un robot tener una "creencia" sobre una gama de posibles especificaciones. La creencia en sí misma se puede utilizar para repartir recompensas y sanciones. "El robot esencialmente está cubriendo sus apuestas en términos de lo que se pretende en una tarea, y realiza acciones que satisfacen sus creencias, en lugar de darle una especificación clara, "Ankit Shah dice.

El sistema se basa en "lógica temporal lineal" (LTL), un lenguaje expresivo que permite el razonamiento robótico sobre los resultados actuales y futuros. Los investigadores definieron plantillas en LTL que modelan varias condiciones basadas en el tiempo, como lo que debe pasar ahora, eventualmente debe suceder, y debe suceder hasta que ocurra algo más. Las observaciones del robot de 30 demostraciones humanas para poner la mesa arrojaron una distribución de probabilidad sobre 25 fórmulas LTL diferentes. Cada fórmula codificaba una preferencia (o especificación) ligeramente diferente para poner la mesa. Esa distribución de probabilidad se convierte en su creencia.

"Cada fórmula codifica algo diferente, pero cuando el robot considera varias combinaciones de todas las plantillas, y trata de satisfacer todo junto, termina haciendo lo correcto eventualmente, "Ankit Shah dice.

Siguiendo criterios

Los investigadores también desarrollaron varios criterios que guían al robot hacia la satisfacción total de la creencia sobre esas fórmulas candidatas. Uno, por ejemplo, satisface la fórmula más probable, que descarta todo lo demás excepto la plantilla con la mayor probabilidad. Otros satisfacen la mayor cantidad de fórmulas únicas, sin considerar su probabilidad general, o satisfacen varias fórmulas que representan la probabilidad total más alta. Otro simplemente minimiza el error, por lo que el sistema ignora las fórmulas con alta probabilidad de falla.

Los diseñadores pueden elegir cualquiera de los cuatro criterios para preestablecer antes de entrenar y probar. Cada uno tiene su propia compensación entre flexibilidad y aversión al riesgo. La elección de los criterios depende completamente de la tarea. En situaciones críticas de seguridad, por ejemplo, un diseñador puede optar por limitar la posibilidad de fallas. But where consequences of failure are not as severe, designers can choose to give robots greater flexibility to try different approaches.

With the criteria in place, the researchers developed an algorithm to convert the robot's belief—the probability distribution pointing to the desired formula—into an equivalent reinforcement learning problem. This model will ping the robot with a reward or penalty for an action it takes, based on the specification it's decided to follow.

In simulations asking the robot to set the table in different configurations, it only made six mistakes out of 20, 000 tries. In real-world demonstrations, it showed behavior similar to how a human would perform the task. If an item wasn't initially visible, por ejemplo, the robot would finish setting the rest of the table without the item. Luego, when the fork was revealed, it would set the fork in the proper place. "That's where flexibility is very important, " Shah says. "Otherwise it would get stuck when it expects to place a fork and not finish the rest of table setup."

Próximo, the researchers hope to modify the system to help robots change their behavior based on verbal instructions, corrections, or a user's assessment of the robot's performance. "Say a person demonstrates to a robot how to set a table at only one spot. The person may say, 'do the same thing for all other spots, ' or, 'place the knife before the fork here instead, '" Shah says. "We want to develop methods for the system to naturally adapt to handle those verbal commands, without needing additional demonstrations."

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre la investigación del MIT, innovación y docencia.