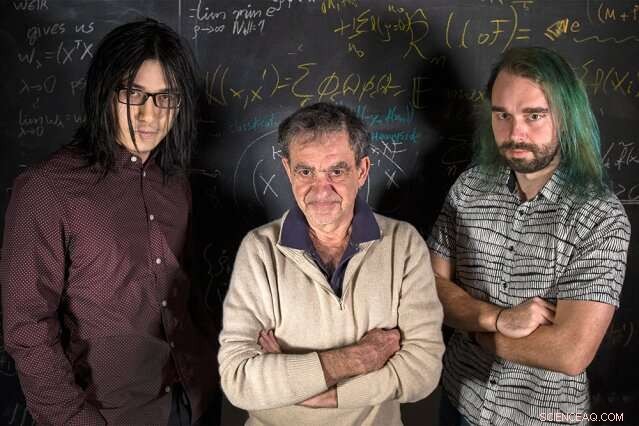

Investigadores del MIT (de izquierda a derecha) Qianli Liao, Tomaso Poggio, y Andrzej Banburski están de pie con sus ecuaciones. Crédito:Kris Brewer

Los cursos de introducción a la estadística nos enseñan que, al ajustar un modelo a algunos datos, deberíamos tener más datos que parámetros libres para evitar el peligro de sobreajuste:ajustar datos ruidosos demasiado cerca, y por lo tanto no se ajustan a los nuevos datos. Es sorprendente, luego, que en el aprendizaje profundo moderno la práctica es tener órdenes de magnitud más parámetros que datos. A pesar de esto, las redes profundas muestran un buen rendimiento predictivo, y, de hecho, lo hacen mejor cuantos más parámetros tengan. ¿Por qué sería eso?

Se sabe desde hace algún tiempo que un buen rendimiento en el aprendizaje automático proviene del control de la complejidad de las redes, que no es simplemente una función del número de parámetros libres. La complejidad de un clasificador, como una red neuronal, depende de medir el "tamaño" del espacio de funciones que representa esta red, con múltiples medidas técnicas sugeridas anteriormente:dimensión Vapnik-Chervonenkis, cubriendo números, o complejidad de Rademacher, para nombrar unos pocos. Complejidad, medido por estas nociones, puede controlarse durante el proceso de aprendizaje imponiendo una restricción a la norma de los parámetros; en resumen, sobre qué tan "grandes" pueden llegar a ser. El hecho sorprendente es que no parece ser necesaria una restricción tan explícita en el entrenamiento de redes profundas. ¿El aprendizaje profundo se encuentra fuera de la teoría clásica del aprendizaje? ¿Necesitamos repensar los cimientos?

En un nuevo artículo de Nature Communications, "Control de la complejidad por descenso de gradientes en redes profundas, "un equipo del Center for Brains, Mentes y Máquinas dirigidas por el director Tomaso Poggio, el profesor Eugene McDermott en el Departamento de Ciencias Cerebrales y Cognitivas del MIT, ha arrojado algo de luz sobre este rompecabezas al abordar las aplicaciones más prácticas y exitosas del aprendizaje profundo moderno:los problemas de clasificación.

"Para problemas de clasificación, observamos que de hecho los parámetros del modelo no parecen converger, sino que crecen en tamaño indefinidamente durante el descenso del gradiente. Sin embargo, en los problemas de clasificación solo importan los parámetros normalizados, es decir, la dirección que definen, no su tamaño, ", dice el coautor y candidato a doctorado del MIT Qianli Liao." Lo que no es tan obvio que mostramos es que el descenso de gradiente comúnmente utilizado en los parámetros no normalizados induce el control de complejidad deseado en los normalizados ".

"Sabemos desde hace algún tiempo que en el caso de la regresión para redes lineales poco profundas, como máquinas de kernel, que las iteraciones de descenso de gradiente proporcionan un implícito, desaparición del efecto de regularización, "Dice Poggio." De hecho, en este caso simple, probablemente sepamos que obtenemos el margen máximo de mejor comportamiento, solución de norma mínima. La pregunta que nos hicimos, luego, fue:¿Puede suceder algo similar con las redes profundas? "

Los investigadores descubrieron que sí. Como explica el coautor y postdoctorado del MIT, Andrzej Banburski, "Comprender la convergencia en redes profundas muestra que existen direcciones claras para mejorar nuestros algoritmos. De hecho, ya hemos visto indicios de que controlar la velocidad a la que estos parámetros no normalizados divergen nos permite encontrar soluciones de mejor rendimiento y encontrarlas más rápidamente ".

¿Qué significa esto para el aprendizaje automático? No hay magia detrás de las redes profundas. La misma teoría detrás de todos los modelos lineales también está en juego aquí. Este trabajo sugiere formas de mejorar las redes profundas, haciéndolos más precisos y más rápidos de entrenar.

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre la investigación del MIT, innovación y docencia.