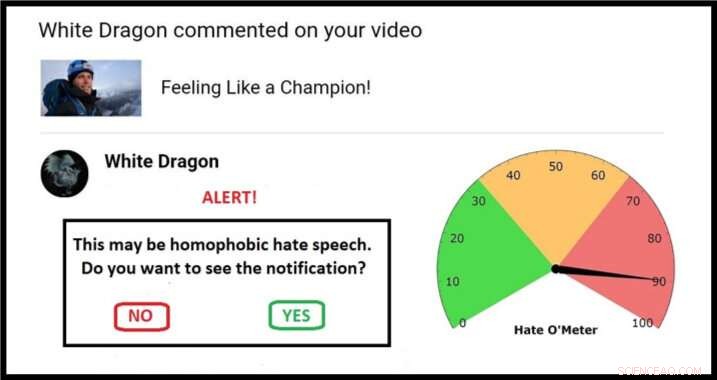

Ejemplo de un posible enfoque para una pantalla de cuarentena, completo con Hate O'Meter. Crédito:Stefanie Ullman

La propagación del discurso de odio a través de las redes sociales podría abordarse utilizando el mismo enfoque de "cuarentena" implementado para combatir el software malicioso. según investigadores de la Universidad de Cambridge.

Las definiciones de incitación al odio varían según la nación, ley y plataforma, y bloquear las palabras clave es ineficaz:las descripciones gráficas de la violencia no necesitan contener insultos étnicos obvios para constituir amenazas de muerte racistas, por ejemplo.

Como tal, el discurso de odio es difícil de detectar automáticamente. Tiene que ser informado por aquellos expuestos a él, después de que se inflija el "daño psicológico" pretendido, con ejércitos de moderadores necesarios para juzgar cada caso.

Esta es la nueva línea del frente de un debate antiguo:libertad de expresión versus lenguaje venenoso.

Ahora, un ingeniero y un lingüista han publicado una propuesta en la revista Ética y tecnología de la información que aprovecha las técnicas de seguridad cibernética para dar control a los destinatarios, sin recurrir a la censura.

Los expertos en lenguaje y aprendizaje automático de Cambridge están utilizando bases de datos de amenazas e insultos violentos para crear algoritmos que puedan proporcionar una puntuación de la probabilidad de que un mensaje en línea contenga formas de incitación al odio.

A medida que estos algoritmos se perfeccionan, el posible discurso de odio podría identificarse y "ponerse en cuarentena". Los usuarios recibirían una alerta de advertencia con un "Odómetro", la puntuación de gravedad del discurso de odio, el nombre del remitente, y una opción para ver el contenido o eliminar lo que no se ve.

Este enfoque es similar a los filtros de spam y malware, y los investigadores del proyecto 'Dar voz a las democracias digitales' creen que podría reducir drásticamente la cantidad de discursos de odio que las personas se ven obligadas a experimentar. Su objetivo es tener un prototipo listo a principios de 2020.

"El discurso de odio es una forma de daño intencional en línea, como malware, y por lo tanto se puede manejar mediante cuarentena, "dijo la coautora y lingüista Dra. Stefanie Ullman." De hecho, una gran cantidad de discursos de odio son generados por software como los bots de Twitter ".

"Empresas como Facebook, Twitter y Google generalmente responden de manera reactiva al discurso de odio, ", dijo el coautor e ingeniero Dr. Marcus Tomalin." Esto puede estar bien para aquellos que no lo encuentran con frecuencia. Para otros es muy poco Demasiado tarde."

"Muchas mujeres y personas de grupos minoritarios a la vista del público reciben un discurso de odio anónimo por atreverse a tener una presencia en línea. Estamos viendo que esto disuade a las personas de ingresar o continuar en la vida pública, a menudo los de grupos que necesitan una mayor representación, " él dijo.

La exsecretaria de Estado de los EE. UU., Hillary Clinton, dijo recientemente a una audiencia del Reino Unido que el discurso de odio representa una "amenaza para las democracias":a raíz de que muchas mujeres parlamentarias citaron el abuso en línea como parte de la razón por la que ya no se presentarán a las elecciones.

Mientras estaba en una dirección de la Universidad de Georgetown, El director ejecutivo de Facebook, Mark Zuckerberg, habló de "amplios desacuerdos sobre lo que califica como odio" y argumentó:"deberíamos errar por el lado de una mayor expresión".

Los investigadores dicen que su propuesta no es una fórmula mágica, pero se sitúa entre los "enfoques autoritarios y libertarios extremos" de permitir o prohibir por completo cierto lenguaje en línea.

En tono rimbombante, el usuario se convierte en árbitro. "A muchas personas no les gusta la idea de que una corporación no elegida o un gobierno microgestionario decidan lo que podemos y no podemos decirnos, "dijo Tomalin.

"Nuestro sistema marcará cuando deba tener cuidado, pero siempre es tu decisión. No impide que las personas publiquen o vean lo que les gusta, pero les da el control que tanto necesitan a quienes están inundados de odio ".

En el papel, los investigadores se refieren a algoritmos de detección que logran un 60% de precisión, no mucho mejor que el azar. El laboratorio de aprendizaje automático de Tomalin ahora tiene esto hasta un 80%, y anticipa una mejora continua del modelado matemático.

Mientras tanto, Ullman recopila más "datos de entrenamiento":discurso de odio verificado del que los algoritmos pueden aprender. Esto ayuda a refinar los "puntajes de confianza" que determinan una cuarentena y la lectura posterior de Hate O'Meter, que podría configurarse como un dial de sensibilidad según las preferencias del usuario.

Un ejemplo básico podría involucrar una palabra como 'perra':un insulto misógino, pero también un término legítimo en contextos como la cría de perros. Es el análisis algorítmico de dónde se encuentra sintácticamente una palabra de este tipo (los tipos de palabras circundantes y las relaciones semánticas entre ellas) lo que informa la puntuación del discurso del odio.

"Identificar palabras clave individuales no es suficiente, estamos viendo estructuras de oraciones completas y mucho más allá. La información sociolingüística en los perfiles de usuario y los historiales de publicación pueden ayudar a mejorar el proceso de clasificación, "dijo Ullman.

Tomalin agregó:"A través de cuarentenas automatizadas que brindan orientación sobre la fuerza del contenido que incita al odio, podemos empoderar a quienes reciben el discurso de odio que envenena nuestros discursos en línea ".

Sin embargo, los investigadores, que trabajan en el Centro de Investigación de las Artes de Cambridge, Humanidades y Ciencias Sociales (CRASSH), dicen que, como ocurre con los virus informáticos, siempre habrá una carrera armamentista entre el discurso de odio y los sistemas para limitarlo.

El proyecto también ha comenzado a considerar el "contra-discurso":las formas en que las personas responden al discurso del odio. Los investigadores tienen la intención de alimentar los debates sobre cómo los asistentes virtuales como 'Siri' deben responder a las amenazas y la intimidación.