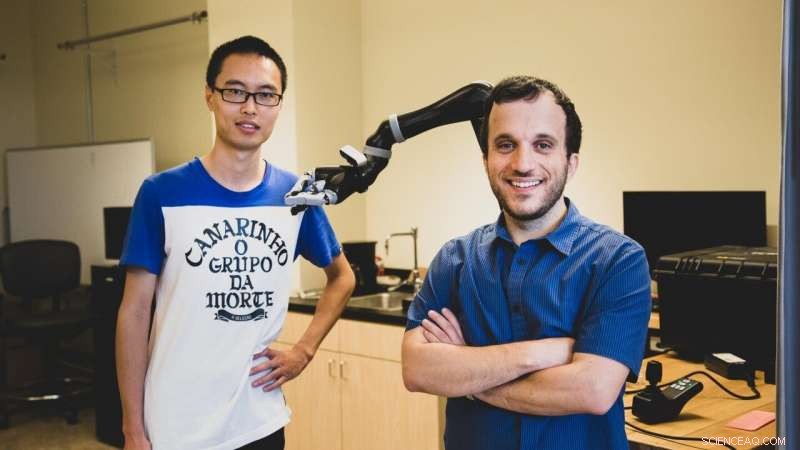

La estudiante de doctorado de la USC Jiali Duan (izquierda) y Stefanos Nikolaidis, un profesor asistente en ciencias de la computación, utilizar el aprendizaje por refuerzo, una técnica en la que los programas de inteligencia artificial "aprenden" de la experimentación repetida. Crédito:Haotian Mai.

Según un nuevo estudio realizado por científicos informáticos de la USC, para ayudar a un robot a tener éxito, puede que tengas que demostrarle un poco de amor duro.

En una tarea de manipulación simulada por computadora, Los investigadores encontraron que entrenar a un robot con un adversario humano mejoró significativamente su comprensión de los objetos.

"Este es el primer esfuerzo de aprendizaje de robots que utiliza usuarios humanos adversarios, "dijo el coautor del estudio Stefanos Nikolaidis, profesor asistente de informática.

"Imagínatelo como si estuvieras jugando un deporte:si estás jugando al tenis con alguien que siempre te deja ganar, no mejorarás. Lo mismo ocurre con los robots. Si queremos que aprendan una tarea de manipulación, como agarrar, para que puedan ayudar a la gente, tenemos que desafiarlos ".

El estudio, "Aprendizaje de robots a través de juegos de adversarios humanos, "se presentó el 4 de noviembre en la Conferencia Internacional sobre Robots y Sistemas Inteligentes. Los estudiantes de doctorado de la USC Jiali Duan y Qian Wang son los autores principales, asesorado por el profesor C. C. Jay Kuo, con el coautor adicional Lerrel Pinto de la Universidad Carnegie Mellon.

Aprendiendo de la práctica

Nikolaidis, que se unió a la Escuela de Ingeniería de USC Viterbi en 2018, y su equipo utilizan el aprendizaje por refuerzo, una técnica en la que los programas de inteligencia artificial "aprenden" de la experimentación repetida.

En lugar de limitarse a completar una pequeña gama de tareas repetitivas, como robots industriales, el sistema robótico "aprende" basándose en ejemplos anteriores, en teoría, aumentando la gama de tareas que puede realizar.

Pero crear robots de propósito general es un desafío notorio, debido en parte a la cantidad de capacitación requerida. Los sistemas robóticos necesitan ver una gran cantidad de ejemplos para aprender a manipular un objeto de una manera similar a la humana.

Por ejemplo, El impresionante sistema robótico de OpenAI aprendió a resolver un cubo de Rubik con una mano humanoide, pero requería el equivalente a 10, 000 años de entrenamiento simulado para aprender a manipular el cubo.

Más importante, la destreza del robot es muy específica. Sin una formación extensa, no puede recoger un objeto, manipularlo con otro agarre, o agarrar y manipular un objeto diferente.

"Como humano, incluso si conozco la ubicación del objeto, No sé exactamente cuánto pesa ni cómo se moverá o se comportará cuando lo levante, sin embargo, lo hacemos con éxito casi todo el tiempo, "dijo Nikolaidis.

"Eso se debe a que la gente es muy intuitiva sobre cómo se comporta el mundo, pero el robot es como un bebé recién nacido ".

En otras palabras, los sistemas robóticos tienen dificultades para generalizar, una habilidad que los humanos dan por sentada. Esto puede parecer trivial pero puede tener graves consecuencias. Si los dispositivos robóticos de asistencia, como agarrar robots, deben cumplir su promesa de ayudar a las personas con discapacidad, Los sistemas robóticos deben poder operar de manera confiable en entornos del mundo real.

Humanos en el bucle

Una línea de investigación que ha tenido bastante éxito en superar este problema es tener un "humano en el circuito". En otras palabras, el ser humano proporciona retroalimentación al sistema robótico demostrando la capacidad para completar la tarea.

Pero, hasta ahora, Estos algoritmos han asumido firmemente que un supervisor humano colaborador ayuda al robot.

"Siempre he trabajado en la colaboración entre humanos y robots, Pero en la realidad, la gente no siempre será colaboradora de robots en la naturaleza, "dijo Nikolaidis.

Como ejemplo, señala un estudio de investigadores japoneses, que soltó un robot en un complejo comercial público y observó a niños "actuando violentamente" hacia él en varias ocasiones.

Entonces, pensó Nikolaidis, ¿Qué pasaría si aprovecháramos nuestra inclinación humana para hacer las cosas más difíciles para el robot? En lugar de mostrarle cómo agarrar mejor un objeto, ¿y si intentáramos quitarlo? Al agregar desafío, el pensamiento va el sistema aprendería a ser más robusto a la complejidad del mundo real.

Elemento de desafío

El experimento fue algo como esto:en una simulación por computadora, el robot intenta agarrar un objeto. El humano, en la computadora, observa el agarre del robot simulado. Si el agarre es exitoso, el humano intenta arrebatar el objeto del agarre del robot, usando el teclado para señalar la dirección.

Agregar este elemento de desafío ayuda al robot a aprender la diferencia entre un agarre débil (digamos, sosteniendo una botella en la parte superior), versus un agarre firme (sosteniéndolo en el medio), lo que hace que sea mucho más difícil para el adversario humano arrebatárselo.

Fue una idea un poco loca admite Nikolaidis, pero funcionó.

Los investigadores encontraron que el sistema entrenado con el adversario humano rechazaba los agarres inestables, y aprendió rápidamente un agarre robusto para estos objetos. En un experimento, el modelo logró una tasa de éxito de comprensión del 52 por ciento con un adversario humano frente a una tasa de éxito de comprensión del 26,5 por ciento con un colaborador humano.

"El robot aprendió no solo a agarrar objetos con más fuerza, sino también para tener éxito más a menudo con nuevos objetos en una orientación diferente, porque ha aprendido una comprensión más estable, "dijo Nikolaidis.

También encontraron que el modelo entrenado con un adversario humano se desempeñó mejor que un adversario simulado, que tuvo una tasa de éxito de comprensión del 28 por ciento. Entonces, Los sistemas robóticos aprenden mejor de los adversarios de carne y hueso.

"Eso se debe a que los humanos pueden comprender la estabilidad y la robustez mejor que los adversarios eruditos, "explicó Nikolaidis.

"El robot intenta recoger cosas y, si el humano intenta perturbar, conduce a agarres más estables. Y debido a que ha aprendido una comprensión más estable, tendrá éxito más a menudo, incluso si el objeto está en una posición diferente. En otras palabras, se ha aprendido a generalizar. Eso es muy importante ".

Encontrar un equilibrio

Nikolaidis espera que el sistema funcione en un brazo robótico real dentro de un año. Esto presentará un nuevo desafío:en el mundo real, la más mínima fricción o ruido en las articulaciones de un robot puede alterar las cosas. Pero Nikolaidis tiene esperanzas sobre el futuro del aprendizaje adversario para la robótica.

"Creo que acabamos de arañar la superficie de las posibles aplicaciones del aprendizaje a través de juegos humanos contradictorios, "dijo Nikolaidis.

"Estamos entusiasmados de explorar el aprendizaje adverso humano en el circuito también en otras tareas, como la evitación de obstáculos para brazos robóticos y robots móviles, como los coches autónomos ".

Esto plantea la pregunta:¿hasta dónde estamos dispuestos a llevar el aprendizaje contradictorio? ¿Estaríamos dispuestos a patear y vencer a los robots para que se sometan? La respuesta, dijo Nikolaidis, radica en encontrar un equilibrio de amor duro y aliento con nuestras contrapartes de robótica.

"Siento que el amor duro, en el contexto del algoritmo que proponemos, es nuevamente como un deporte:se inscribe dentro de reglas y restricciones específicas, "dijo Nikolaidis.

"Si el humano simplemente rompe la pinza del robot, el robot fallará continuamente y nunca aprenderá. En otras palabras, el robot necesita ser desafiado, pero aún se le debe permitir que tenga éxito para aprender ".