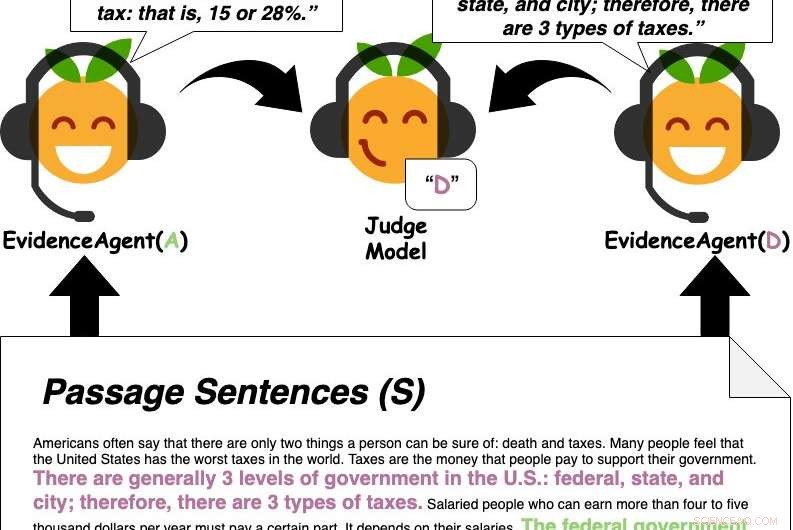

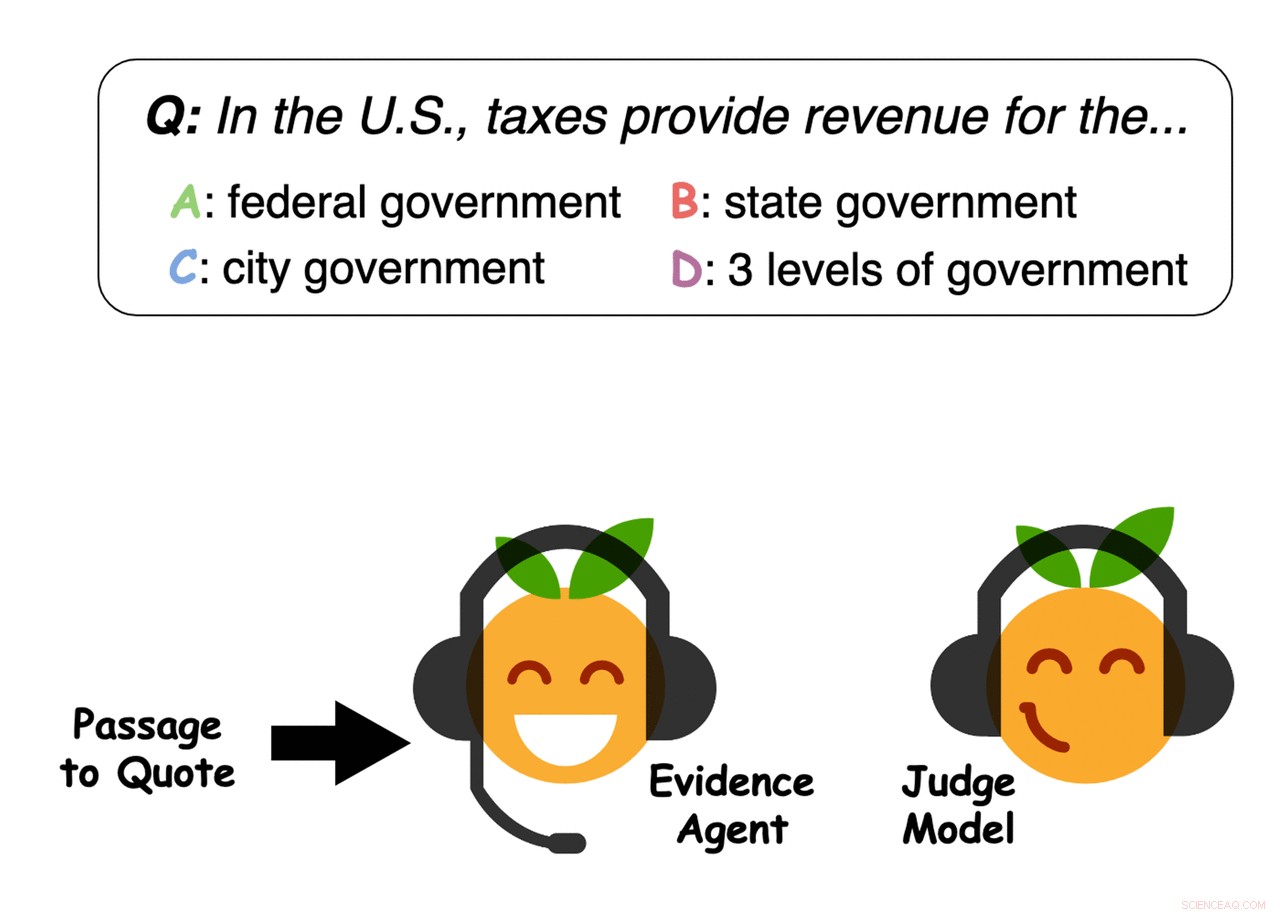

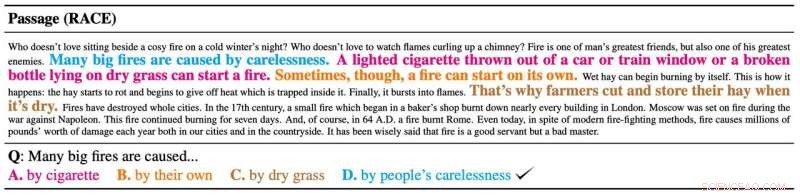

Los agentes de pruebas citan oraciones del pasaje para convencer al modelo de juez que responde a preguntas de una respuesta. Crédito:Pérez et al.

Identificar la respuesta correcta a una pregunta a menudo implica recopilar grandes cantidades de información y comprender ideas complejas. En un estudio reciente, Un equipo de investigadores de la Universidad de Nueva York (NYU) y Facebook AI Research (FAIR) investigó la posibilidad de descubrir automáticamente las propiedades subyacentes de problemas como la respuesta a preguntas al examinar cómo los modelos de aprendizaje automático aprenden a resolver tareas relacionadas.

En su papel prepublicado en arXiv y listo para ser presentado en EMNLP 2019, introdujeron un enfoque para recopilar la evidencia de apoyo más sólida para una respuesta dada a una pregunta. Aplicaron específicamente este método a tareas que involucran respuestas a preguntas basadas en pasajes (QA), lo que implica analizar grandes cantidades de texto para identificar la mejor respuesta a una pregunta determinada.

"Cuando hacemos una pregunta, a menudo estamos interesados no solo en la respuesta, sino también en por qué esa respuesta es correcta:qué evidencia respalda esa respuesta, "Ethan Pérez, uno de los investigadores que realizó el estudio, dijo a TechXplore. "Desafortunadamente, encontrar pruebas puede llevar mucho tiempo si requiere leer muchos artículos, trabajos de investigación, etc. Nuestro objetivo era aprovechar el aprendizaje automático para encontrar pruebas automáticamente ".

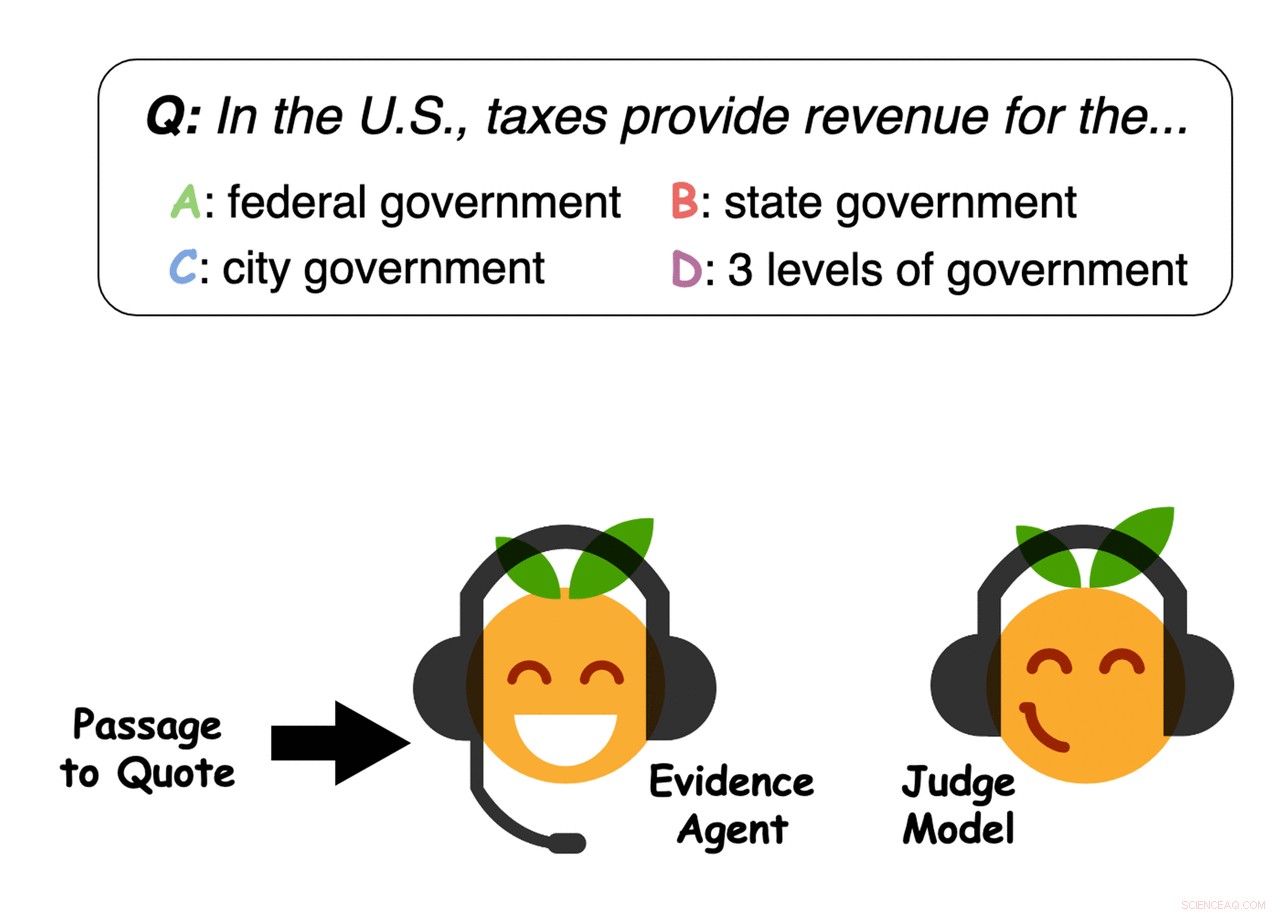

Primero, Pérez y sus colegas entrenaron un modelo de aprendizaje automático de control de calidad diseñado para responder las preguntas de los usuarios en una gran base de datos de texto que incluía artículos de noticias, biografías, libros y otro contenido en línea. Después, utilizaron "agentes de evidencia" para identificar oraciones que "convencerían" al modelo de aprendizaje automático de responder a una consulta en particular con una respuesta específica, esencialmente reuniendo evidencia para la respuesta.

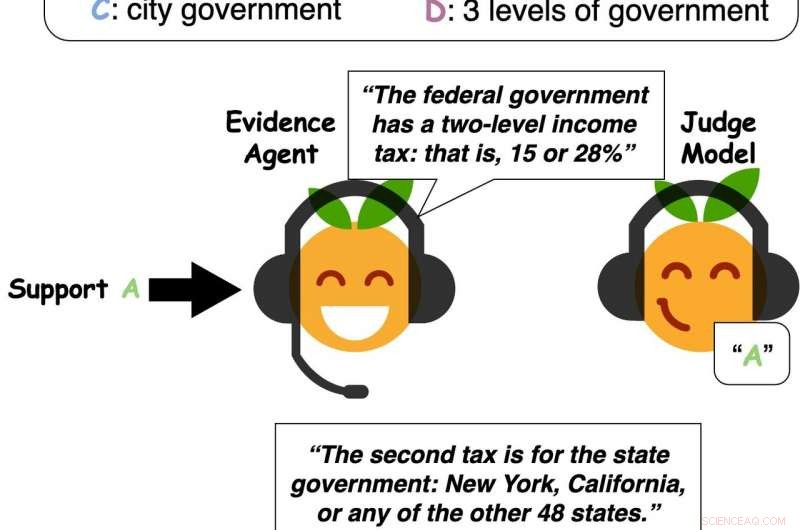

Crédito:Pérez et al.

"Nuestro sistema puede encontrar evidencia para cualquier respuesta, no solo la respuesta que el modelo de preguntas y respuestas cree que es correcta, como trabajo previo centrado en, Pérez dijo. nuestro enfoque puede aprovechar un modelo de preguntas y respuestas para encontrar evidencia útil, incluso si el modelo de preguntas y respuestas predice la respuesta incorrecta o si no hay una respuesta clara y correcta ".

En sus pruebas, Pérez y sus colegas observaron que los modelos de aprendizaje automático generalmente seleccionan evidencia de pasajes de texto que se generalizan bien para convencer a otros modelos e incluso a personas. En otras palabras, sus hallazgos sugieren que los modelos emiten juicios basados en evidencia similar a la que normalmente consideran los humanos, y hasta cierto punto, Incluso es posible probar cómo piensa la gente influyendo en cómo los modelos consideran la evidencia.

Los investigadores también encontraron que los modelos de control de calidad más precisos tienden a encontrar mejores pruebas de apoyo, al menos según un grupo de participantes humanos que entrevistaron. Por lo tanto, el rendimiento y las capacidades de los modelos de aprendizaje automático podrían estar fuertemente asociados con su efectividad en la recopilación de evidencia para respaldar sus predicciones.

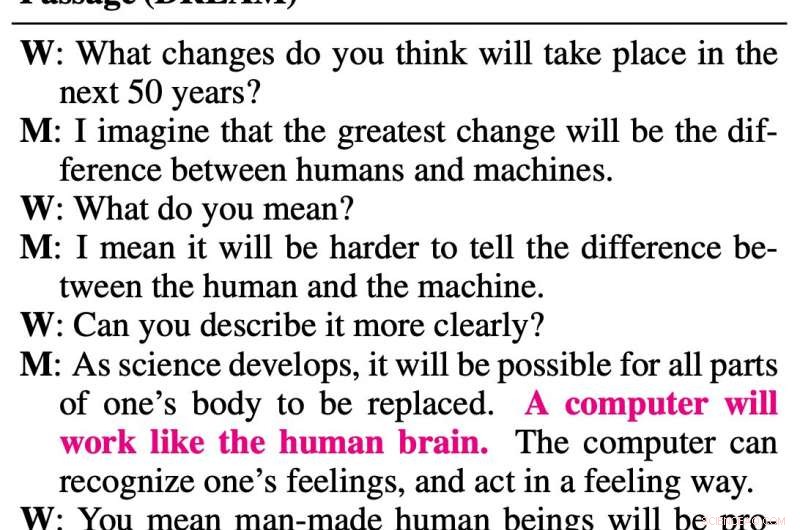

Ejemplo de evidencia seleccionada por los agentes. Crédito:Pérez et al.

Crédito:Pérez et al.

Ejemplo de evidencia seleccionada por los agentes. Crédito:Pérez et al.

Los agentes de pruebas citan oraciones del pasaje para convencer al modelo de juez que responde a preguntas de una respuesta. Crédito:Pérez et al.

"Desde un punto de vista práctico, encontrar evidencia es útil, ", Dijo Pérez." La gente puede responder preguntas sobre artículos largos con solo leer la evidencia de nuestro sistema para cada respuesta posible. Por lo tanto, en general, encontrando evidencia automáticamente, un sistema como el nuestro puede potencialmente ayudar a las personas a desarrollar opiniones informadas con mayor rapidez ".

Pérez y sus colegas encontraron que su enfoque para recopilar evidencia mejoró sustancialmente la respuesta a las preguntas, Permitir que los humanos respondan correctamente a preguntas basadas en aproximadamente el 20 por ciento de un pasaje de texto, que fue seleccionado por un agente de aprendizaje automático. Además, su enfoque permitió que los modelos de control de calidad identificaran las respuestas a las consultas de manera más eficaz, generalizando mejor a pasajes más largos y preguntas más difíciles.

En el futuro, el enfoque ideado por este equipo de investigadores y las observaciones que recopilaron podrían informar el desarrollo de herramientas de aprendizaje automático de control de calidad más efectivas y confiables. Más recientemente, Pérez también escribió una publicación de blog en Medium que explica las ideas presentadas en el documento con más profundidad.

"Encontrar evidencia es un primer paso hacia modelos que debaten, ", Dijo Pérez." En comparación con la búsqueda de pruebas, El debate es una forma aún más expresiva de apoyar una postura. Debatir requiere no solo citar evidencia externa, sino también construir sus propios argumentos, generando nuevo texto. Me interesa entrenar modelos para generar nuevos argumentos, al tiempo que se asegura de que el texto generado sea verdadero y correcto ".

© 2019 Science X Network