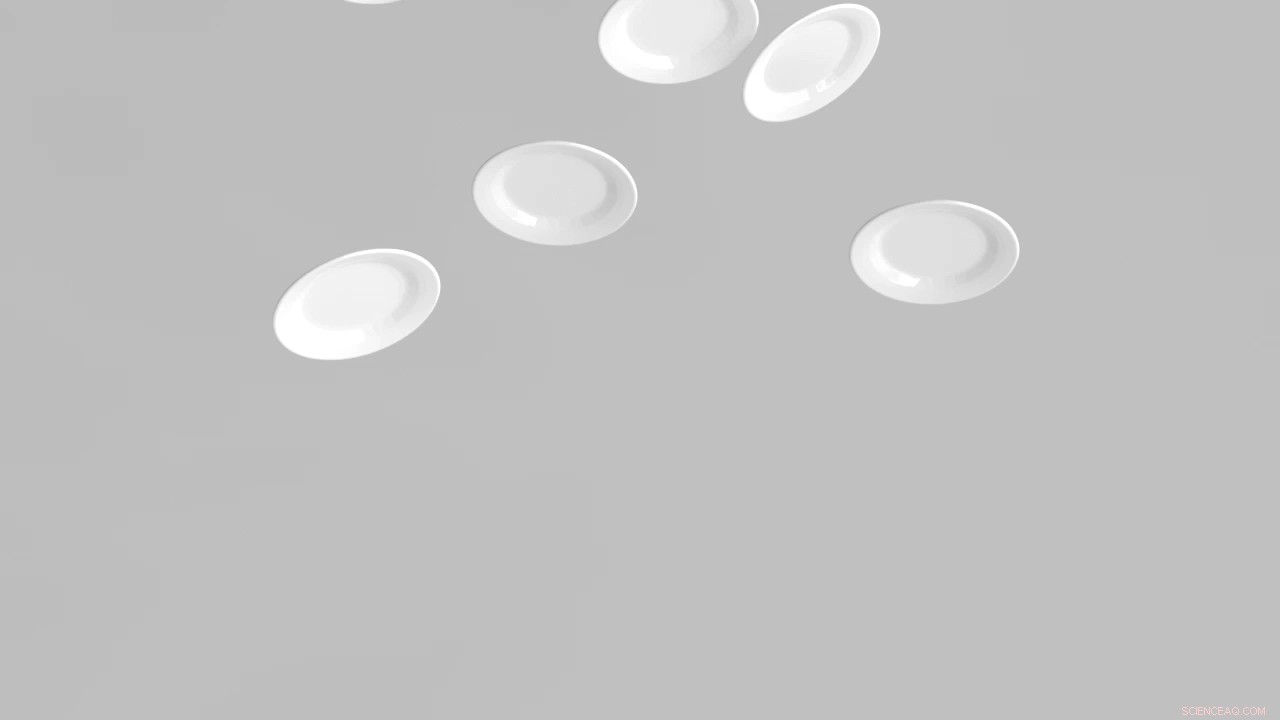

Crédito:Doug Jame, Universidad Stanford

Cuando vemos películas o jugamos videojuegos, los efectos de sonido adecuados pueden ayudar a que las escenas sean más realistas:cuando un jugador canoso hace rodar un dólar de plata sobre una mesa de juego en un salón con pantalla plateada, el sonido parece viajar de oreja a oreja, un truco que los realizadores de películas pueden lograr empalmando un sonido pregrabado que se mueve de un altavoz a otro.

Pero crear tales sensaciones en la realidad virtual ha sido prácticamente imposible hasta ahora porque la realidad virtual no tiene guión. Es difícil predecir qué ruidos puede hacer un objeto, o donde puedan ser escuchados. Para hacer que la realidad virtual suene realista, los ingenieros tendrían que crear una gran cantidad de "modelos de sonido", los equivalentes computarizados de las pregrabaciones. Cada modelo de sonido permitiría al sistema de realidad virtual sintetizar un sonido particular en el momento preciso en que se necesitaba. Hasta ahora, un grupo de computadoras habría necesitado muchas horas para crear incluso un solo modelo de sonido, y dado que se necesitarían muchos modelos diferentes para sintetizar muchos sonidos potenciales diferentes, crear un sonido realista en entornos interactivos ha sido un objetivo difícil de alcanzar.

Ahora, los científicos informáticos de Stanford han inventado un algoritmo que puede crear modelos de sonido en segundos, lo que hace que sea rentable simular sonidos para muchos objetos diferentes en un entorno virtual. Cuando ocurre una acción que exige un sonido, este nuevo modelo puede sintetizar un sonido tan realista como los sonidos generados por los algoritmos mucho más lentos y aún experimentales del pasado. "Al facilitar la creación de modelos, resulta práctico crear entornos interactivos con efectos de sonido realistas, "dijo Doug James, profesor de informática con nombramiento de cortesía en música.

Los algoritmos anteriores para crear modelos de sonido se basaron en el trabajo realizado por el científico del siglo XIX Hermann von Helmholtz, quien dio su nombre a una ecuación que describe cómo se propagan los sonidos. Sobre la base de este fundamento teórico, Los científicos diseñaron algoritmos para crear modelos de sonido 3-D:rutinas de software que son capaces de sintetizar audio que parece realista porque el volumen y la dirección del sonido cambian dependiendo de dónde ocurre la acción en relación con el oyente. Hasta ahora, los mejores algoritmos para crear modelos de sonido 3-D se basaban en el método de elementos de contorno (BEM), un proceso lento que resultaba demasiado costoso para el uso comercial.

James y su colaborador estudiante de posgrado, Jui-Hsien Wang, desarrolló un algoritmo que calcula modelos de sonido cientos o miles de veces más rápido al evitar la ecuación de Helmholtz y BEM. Su enfoque está inspirado en el compositor austríaco del siglo XX, Fritz Heinrich Klein, que encontró una manera de combinar una gran cantidad de tonos y notas de piano en una sola, sonido agradable conocido como el acorde madre. Los científicos, que llamaron a su algoritmo KleinPAT en un guiño a su inspiración, explican cómo su enfoque crea modelos de sonido en un artículo científico que están presentando en la conferencia ACM SIGGRAPH 2019 sobre gráficos por computadora y técnicas interactivas. "Creemos que esto cambia las reglas del juego para los entornos interactivos, "Dijo James.