La imagen de entrada original. Crédito:Lee et al.

Investigadores de IBM Research UK, La Academia Militar de EE. UU. y la Universidad de Cardiff han propuesto recientemente un nuevo enfoque para mejorar la sensibilidad de LIME (Explicaciones agnósticas del modelo interpretable local), una técnica para lograr una mejor comprensión de las conclusiones a las que llegan los algoritmos de aprendizaje automático. Su papel publicado en la biblioteca digital SPIE, podría informar el desarrollo de herramientas de inteligencia artificial (IA) que brindan explicaciones exhaustivas de cómo llegaron a un resultado o conclusión en particular.

"Creemos que la inteligencia artificial y el aprendizaje automático pueden respaldar y aumentar la toma de decisiones humana, pero que también existe la necesidad de una IA explicable, "Eunjin Lee, coautor del artículo de investigación original y especialista en tecnologías emergentes e inventor senior en IBM Research U.K., dijo a TechXplore. "Hoy dia, las decisiones que toman muchos sistemas de aprendizaje automático son inexplicables, es decir., No hay forma de que nosotros, los humanos, sepamos cómo llegaron los sistemas a esas decisiones. Nuestra investigación aborda este problema al investigar cómo mejorar las técnicas de explicabilidad que tienen como objetivo arrojar luz sobre la naturaleza de 'caja negra' de los procesos de aprendizaje automático ".

LIME es una técnica de explicabilidad particularmente popular que se puede aplicar a muchos modelos de aprendizaje automático. A pesar de su versatilidad, a menudo se considera poco confiable y, por lo tanto, ineficaz a la hora de proporcionar explicaciones, también debido a la variabilidad en los resultados que produce. En lugar de desarrollar una técnica de explicabilidad completamente nueva, Lee y sus colegas se propusieron identificar mecanismos que podrían mejorar las explicaciones de LIME.

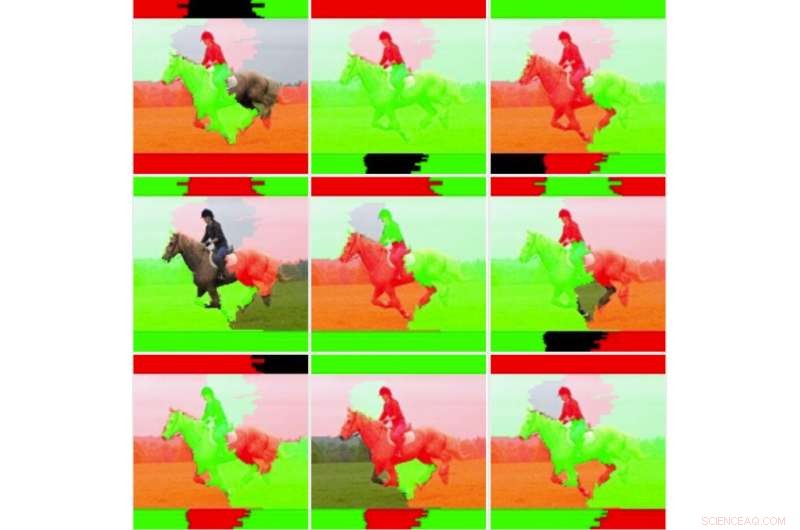

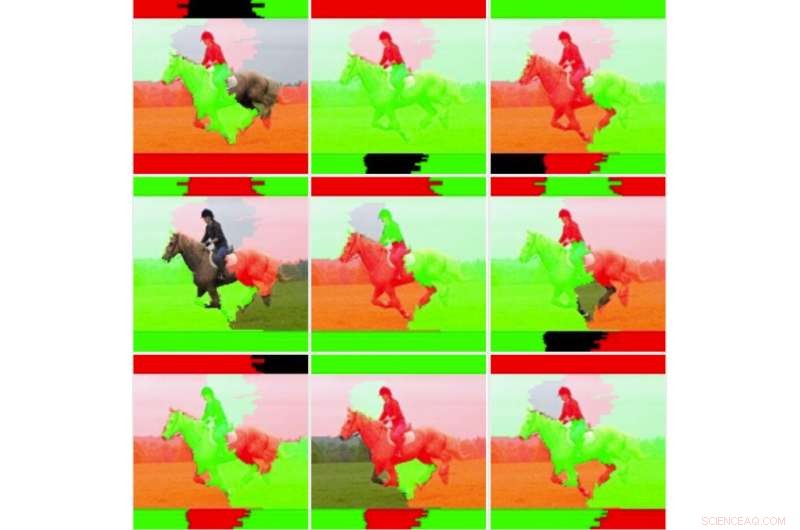

"Primero queríamos profundizar en la inestabilidad que otros investigadores han observado para determinar si LIME era realmente inestable, "Lee explicó." Para hacer esto, probamos LIME con nuestro conjunto de datos y modelo de aprendizaje automático sin cambiar el código subyacente. Inmediatamente descubrimos que las imágenes de explicación resultantes variaban considerablemente y no parecían consistentes. Este es quizás el punto en el que muchos simplemente dejarían de usar la técnica ".

Nueve salidas de imagen para la técnica LIME sin modificar. Crédito:Lee et al.

Cuando Lee y sus colegas profundizaron en las estadísticas subyacentes de LIME, descubrieron que aunque las imágenes que generaba parecían "visualmente inestables, "la explicación predeterminada no tuvo en cuenta toda la información estadística. Por ejemplo, la coloración de las imágenes explicativas era demasiado simple y no consideró los datos subyacentes completos (por ejemplo, no tuvo en cuenta técnicas como el sombreado o la transparencia). Este hallazgo explica en parte por qué las explicaciones generadas por LIME a veces no logran transmitir la certeza de la clasificación a los usuarios humanos.

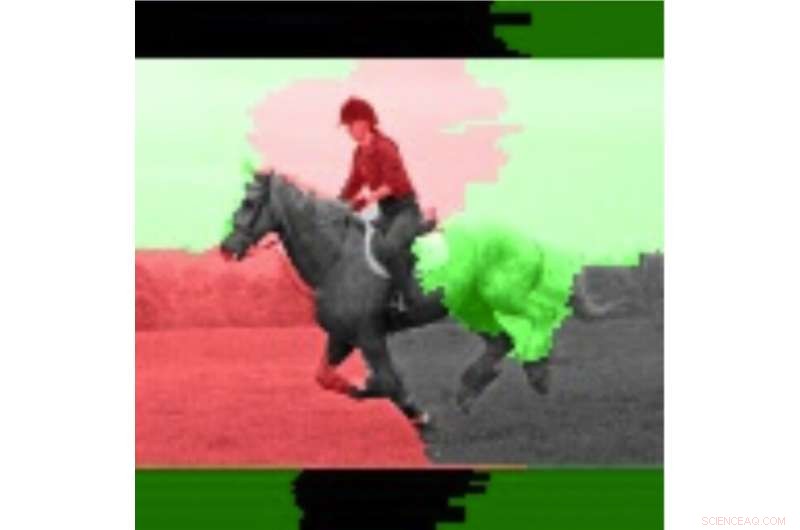

"A menudo es el caso de los sistemas dinámicos, como los que examinamos en este estudio, que realizar numerosas pruebas e investigar los valores medios puede resultar beneficioso, ", Dijo Lee." Al adoptar este enfoque, nos dimos cuenta de que la estabilidad de las explicaciones mejoró al considerar los valores promediados y las desviaciones estándar en múltiples ejecuciones en lugar de simplemente ejecutar la explicación una vez ".

En su estudio, Lee y sus colegas entrenaron un modelo de red neuronal convolucional (CNN) utilizando dos clases de imágenes, a saber, "portador de armas" y "no portador". Descubrieron que la sensibilidad de LIME mejoraba cuando se promediaban y visualizaban varios pesos de salida para imágenes individuales.

Luego, los investigadores compararon estas imágenes promediadas con imágenes individuales para evaluar la variabilidad y confiabilidad de los dos métodos LIME (es decir, el método tradicional y el que propusieron). Descubrieron que las técnicas tradicionales de LIME, sin los ajustes que hicieron, parecía ser inestable debido a la simple coloración binaria que adoptaron y la facilidad con la que las regiones coloreadas se voltearon al comparar diferentes análisis. Lee y sus colegas también observaron que las regiones de imágenes ponderadas significativamente eran consistentes, mientras que las regiones de menor ponderación cambiaron los estados, debido a la inestabilidad inherente de las técnicas LIME.

La imagen resaltada usando la información promedio. Crédito:Lee et al.

"Técnicas como LIME son muy prometedoras para la explicabilidad de la IA, especialmente en un momento en el que no hay nada fácil, capacidades de explicación fácilmente disponibles para sistemas de aprendizaje automático, ", Dijo Lee." Si bien la inestabilidad percibida está justificada, existen técnicas que pueden ayudar a mitigar este problema. Estas técnicas tienen costos computacionales adicionales, p.ej. ejecutar la explicación varias veces, lo que significa que el usuario tendrá un retraso mayor en la generación de la explicación ".

El estudio que Lee y sus colegas realizaron ofrece una explicación valiosa de algunos de los factores detrás de la inestabilidad de LIME, como se observó en investigaciones anteriores. Sus hallazgos sugieren que la mejora de los métodos de ponderación para las técnicas de explicabilidad puede mejorar su estabilidad y dar lugar a explicaciones más fiables. en última instancia, fomentando una mayor confianza en la IA. La investigación futura podría identificar técnicas numéricas más avanzadas para mejorar aún más la estabilidad de LIME y otros métodos de explicabilidad mientras se reduce la sobrecarga adicional.

"Tenemos un interés continuo en los sistemas de inteligencia artificial responsables que incluyen explicaciones, pero también mitigan el sesgo y mejoran la solidez y la transparencia". "Dijo Lee." Mejorar la capacidad de los desarrolladores para integrar más fácilmente técnicas de explicabilidad en sus soluciones de IA es un objetivo clave para nosotros. Recientemente, IBM lanzó un servicio de software que detecta automáticamente el sesgo y explica cómo la IA toma decisiones ".

© 2019 Science X Network