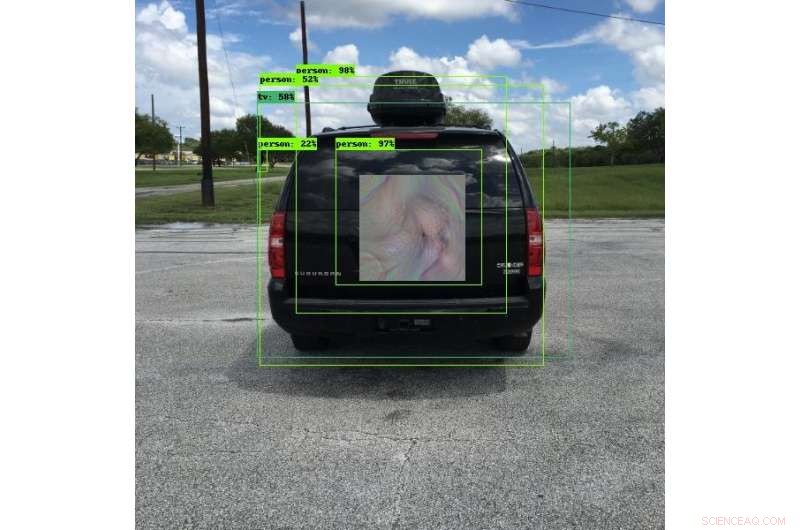

Muchos de los vehículos actuales utilizan sistemas de detección de objetos para ayudar a evitar colisiones. Los ingenieros de SwRI desarrollaron patrones únicos que pueden engañar a estos sistemas para que vean algo más, ver los objetos en otra ubicación o no ver los objetos en absoluto. En esta foto, el sistema de detección de objetos ve a una persona en lugar de a un vehículo. Esta investigación permitirá a los ingenieros probar a fondo los sistemas de detección de objetos y mejorar la seguridad de los algoritmos de aprendizaje profundo que utilizan. Crédito:Southwest Research Institute

Las nuevas técnicas de confrontación desarrolladas por ingenieros del Southwest Research Institute pueden hacer que los objetos sean "invisibles" para los sistemas de detección de imágenes que utilizan algoritmos de aprendizaje profundo. Estas técnicas también pueden engañar a los sistemas para que piensen que ven otro objeto o pueden cambiar la ubicación de los objetos. La técnica mitiga el riesgo de compromiso en los sistemas de procesamiento de imágenes automatizados.

"Las redes neuronales de aprendizaje profundo son muy eficaces en muchas tareas, "dice el ingeniero de investigación Abe Garza de la división de sistemas inteligentes SwRI." Sin embargo, El aprendizaje profundo se adoptó tan rápidamente que las implicaciones de seguridad de estos algoritmos no se consideraron completamente ".

Los algoritmos de aprendizaje profundo se destacan en el uso de formas y colores para reconocer las diferencias entre humanos y animales o automóviles y camiones. por ejemplo. Estos sistemas detectan objetos de manera confiable bajo una variedad de condiciones y, como tal, se utilizan en innumerables aplicaciones e industrias, a menudo para usos críticos para la seguridad. La industria automotriz utiliza sistemas de detección de objetos de aprendizaje profundo en las carreteras para asistencia en el carril, tecnologías de salida de carril y para evitar colisiones. Estos vehículos dependen de cámaras para detectar objetos potencialmente peligrosos a su alrededor. Si bien los sistemas de procesamiento de imágenes son vitales para proteger vidas y propiedades, los algoritmos pueden ser engañados por partes que tengan la intención de causar daño.

Los investigadores de seguridad que trabajan en "aprendizaje contradictorio" están encontrando y documentando vulnerabilidades en algoritmos de aprendizaje profundo y de otras máquinas. Utilizando fondos de investigación internos de SwRI, Garza y el ingeniero de investigación senior David Chambers desarrollaron lo que parece futurista, Patrones de estilo bohemio. Cuando lo usa una persona o se monta en un vehículo, los patrones engañan a las cámaras de detección de objetos para que piensen que los objetos no están allí, que son otra cosa o que están en otra ubicación. Las partes malintencionadas podrían colocar estos patrones cerca de las carreteras, potencialmente creando caos para los vehículos equipados con detectores de objetos.

Lo que parece un patrón de colores para el ojo humano parece una bicicleta para un sistema de detección de objetos. Si bien los algoritmos de aprendizaje profundo utilizados en estos sistemas son confiables, pueden ser engañados con imágenes especiales. Los investigadores de SwRI están desarrollando técnicas para mitigar el riesgo de compromiso en estos sistemas. Crédito:Southwest Research Institute

"Estos patrones hacen que los algoritmos de la cámara clasifiquen o ubiquen incorrectamente los objetos, creando una vulnerabilidad, ", dijo Garza." A estos patrones los llamamos ejemplos contradictorios de 'percepción invariable' porque no necesitan cubrir todo el objeto o ser paralelos a la cámara para engañar al algoritmo. Los algoritmos pueden clasificar erróneamente el objeto siempre que detecten alguna parte del patrón ".

Si bien pueden parecer muestras de arte únicas y coloridas para el ojo humano, estos patrones están diseñados de tal manera que los sistemas de cámaras de detección de objetos los vean de manera muy específica. Un patrón disfrazado como un anuncio en la parte trasera de un autobús detenido podría hacer que un sistema para evitar colisiones crea que ve una bolsa de compras inofensiva en lugar del autobús. Si la cámara del vehículo no detecta el objeto verdadero, podría seguir avanzando y chocar contra el autobús, causando una colisión potencialmente grave.

"El primer paso para resolver estas vulnerabilidades es probar los algoritmos de aprendizaje profundo, ", dijo Garza. El equipo ha creado un marco capaz de probar repetidamente estos ataques contra una variedad de programas de detección de aprendizaje profundo, que será de gran utilidad para probar soluciones.

Los investigadores de SwRI continúan evaluando cuánto, o que poco, del patrón es necesario para clasificar o ubicar incorrectamente un objeto. Trabajando con clientes, Esta investigación permitirá al equipo probar sistemas de detección de objetos y, en última instancia, mejorar la seguridad de los algoritmos de aprendizaje profundo.