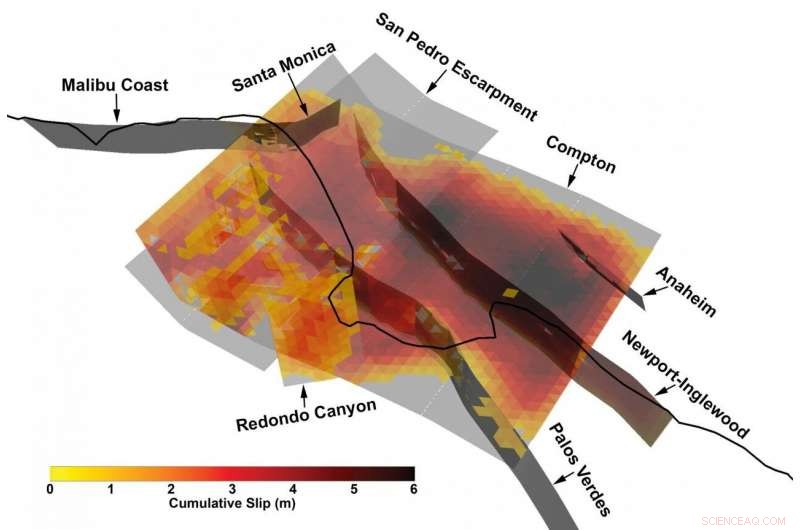

Vista 3D de una ruptura de fallas múltiples especialmente compleja del catálogo de terremotos sintéticos desarrollado por el Centro de Terremotos del Sur de California utilizando un nuevo marco de modelado de terremotos. Crédito:Kevin Milner, Universidad del Sur de California

Los terremotos masivos son, Afortunadamente, eventos raros. Pero esa escasez de información nos ciega de alguna manera a sus riesgos, especialmente cuando se trata de determinar el riesgo para una ubicación o estructura específica.

"No hemos observado la mayoría de los posibles eventos que podrían causar grandes daños, "explicó Kevin Milner, un científico informático e investigador de sismología en el Centro de Terremotos del Sur de California (SCEC) en la Universidad del Sur de California. "Utilizando el sur de California como ejemplo, no hemos tenido un terremoto realmente grande desde 1857; esa fue la última vez que el sur de San Andreas estalló en un terremoto masivo de magnitud 7,9. Un terremoto de San Andreas podría afectar un área mucho más grande que el terremoto de Northridge de 1994, y también pueden ocurrir otros grandes terremotos. Eso es lo que nos preocupa ".

La forma tradicional de sortear esta falta de datos consiste en cavar trincheras para aprender más sobre rupturas pasadas, recopilar información de muchos terremotos en todo el mundo y crear un modelo estadístico de peligro, o usar supercomputadoras para simular un terremoto específico en un lugar específico con un alto grado de fidelidad.

Sin embargo, un nuevo marco para predecir la probabilidad y el impacto de terremotos en toda una región, desarrollado por un equipo de investigadores asociados con SCEC durante la última década, ha encontrado un término medio y quizás una mejor manera de determinar el riesgo.

Un nuevo estudio dirigido por Milner y Bruce Shaw de la Universidad de Columbia, publicado en el Boletín de la Sociedad Sismológica de América en enero de 2021, presenta los resultados de un prototipo de simulador de terremotos Rate-State, o RSQSim, que simula cientos de miles de años de historia sísmica en California. Junto con otro código, CyberShake, el marco puede calcular la cantidad de sacudidas que se producirían por cada terremoto. Sus resultados se comparan bien con los terremotos históricos y los resultados de otros métodos, y mostrar una distribución realista de probabilidades de terremotos.

Según los desarrolladores, el nuevo enfoque mejora la capacidad de determinar qué tan grande podría ocurrir un terremoto en una ubicación determinada, permitiendo a los desarrolladores de códigos de construcción, arquitectos, e ingenieros estructurales para diseñar edificios más resistentes que puedan sobrevivir a terremotos en un sitio específico.

"Por primera vez, tenemos una tubería completa de principio a fin donde la ocurrencia de terremotos y la simulación del movimiento del suelo se basan en la física, "Milner dijo." Puede simular hasta 100, Miles de años en un sistema de fallas realmente complicado ".

Aplicar una potencia informática masiva a grandes problemas

RSQSim transforma las representaciones matemáticas de las fuerzas geofísicas en juego en los terremotos, el modelo estándar de cómo las rupturas se nuclean y se propagan, en algoritmos, y luego los resuelve en algunas de las supercomputadoras más poderosas del planeta. La investigación computacionalmente intensiva fue posible durante varios años por supercomputadoras patrocinadas por el gobierno en el Centro de Computación Avanzada de Texas, incluido Frontera, el sistema más poderoso en cualquier universidad del mundo, Blue Waters en el Centro Nacional de Aplicaciones de Supercomputación, y Summit en Oak Ridge Leadership Computing Facility.

"Una forma en la que podríamos mejorar la predicción del riesgo es mediante el modelado basado en la física, aprovechando el poder de sistemas como Frontera para ejecutar simulaciones, ", dijo Milner." En lugar de una distribución estadística empírica, simulamos la ocurrencia de terremotos y la propagación de sus ondas ".

"Hemos avanzado mucho en Frontera para determinar qué tipo de terremotos podemos esperar, en que culpa, y con que frecuencia "dijo Christine Goulet, Director Ejecutivo de Ciencias Aplicadas en SCEC, también involucrado en el trabajo. "No prescribimos ni decimos el código cuándo van a ocurrir los terremotos. Lanzamos una simulación de cientos de miles de años, y deje que el código transfiera el estrés de una falla a otra ".

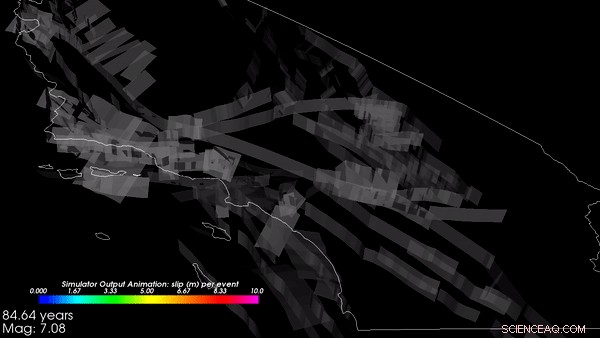

Las simulaciones comenzaron con la topografía geológica de California y simularon más de 800, 000 años virtuales de cómo las tensiones se forman y se disipan a medida que las fuerzas tectónicas actúan sobre la Tierra. De estas simulaciones, el marco generó un catálogo, un registro de que un terremoto ocurrió en un lugar determinado con una magnitud y atributos determinados en un momento determinado. El catálogo que el equipo de SCEC produjo en Frontera y Blue Waters fue uno de los más grandes jamás hechos, Dijo Goulet. Las salidas de RSQSim luego se introdujeron en CyberShake que nuevamente usó modelos de computadora de geofísica para predecir cuánta sacudida (en términos de aceleración del suelo, o velocidad, y duración) ocurriría como resultado de cada terremoto.

"El marco genera un historial completo de tiempo de deslizamiento:dónde se produce una ruptura y cómo creció, "Milner explicó." Descubrimos que produce movimientos de suelo realistas, lo que nos dice que la física implementada en el modelo está funcionando según lo previsto. "Tienen más trabajo planeado para la validación de los resultados, que es fundamental antes de la aceptación para aplicaciones de diseño.

Los investigadores encontraron que el marco RSQSim produce ricos, terremotos variables en general, una señal de que está produciendo resultados razonables, al mismo tiempo que genera efectos repetibles de fuente y trayectoria.

Un 3 seleccionado al azar, Segmento de 000 años del catálogo simulado basado en la física de terremotos en California, creado en Frontera. Crédito:Kevin Milner, Universidad del Sur de California

"En muchos sitios, el peligro de temblores disminuye, en relación con las estimaciones del estado de la práctica ", dijo Milner." Pero para un par de sitios que tienen configuraciones especiales de fallas cercanas o características geológicas locales, como cerca de San Bernardino, el peligro subió. Estamos trabajando para comprender mejor estos resultados y definir enfoques para verificarlos ".

El trabajo está ayudando a determinar la probabilidad de que ocurra un terremoto a lo largo de cualquiera de los cientos de fallas que producen terremotos en California. la magnitud del terremoto que podría esperarse, y cómo puede desencadenar otros terremotos.

El apoyo para el proyecto proviene del Servicio Geológico de EE. UU. (USGS), Fundación Nacional de Ciencias (NSF), y el W.M. Fundación Keck. Frontera es el recurso nacional de clase de liderazgo de NSF. El tiempo de computación en Frontera se proporcionó a través de un premio de Asociación Comunitaria a Gran Escala (LSCP) a SCEC que permite a cientos de académicos estadounidenses acceder a la máquina para estudiar muchos aspectos de la ciencia de los terremotos. Los premios LSCP brindan asignaciones extendidas de hasta tres años para respaldar los esfuerzos de investigación de larga duración. SCEC, que se fundó en 1991 y se ha basado en sistemas TACC durante más de una década, es un excelente ejemplo de tal esfuerzo.

La creación del catálogo requirió ocho días de computación continua en Frontera y utilizó más de 3, 500 procesadores en paralelo. Simular el temblor del suelo en 10 sitios en California requirió una cantidad comparable de computación en Summit, la segunda supercomputadora más rápida del mundo.

"La adopción por parte de la comunidad en general será comprensiblemente lenta, ", dijo Milner." Debido a que tales resultados afectarán la seguridad, es parte de nuestra diligencia debida asegurarnos de que estos resultados sean técnicamente defendibles por la comunidad en general, ", agregó Goulet. Pero resultados de investigación como estos son importantes para ir más allá de los códigos de construcción generalizados que, en algunos casos, pueden representar inadecuadamente el riesgo que enfrenta una región, mientras que en otros casos son demasiado conservadores.

"La esperanza es que este tipo de modelos nos ayuden a caracterizar mejor el peligro sísmico, por lo que estamos gastando nuestros recursos para construir sólidos, a salvo, edificios resilientes donde más se necesitan, "Dijo Milner.