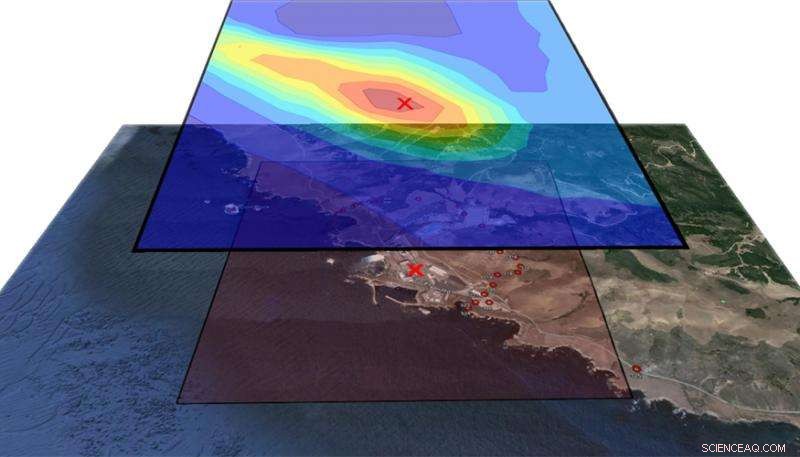

En esta figura, la capa superior muestra los contornos de probabilidad de ubicación de liberación y la capa inferior muestra la región geográfica que rodea a la planta de energía Diablo Canyon. La ubicación real del lanzamiento, denotado por la X roja, cae dentro del contorno de mayor probabilidad (rojo oscuro) determinado por el algoritmo de inversión. Crédito:Laboratorio Nacional Lawrence Livermore

En el caso de una emisión radiológica accidental de un reactor de una central nuclear o una instalación industrial, rastrear la columna aérea de radiación hasta su fuente de manera oportuna podría ser un factor crucial para los servicios de emergencia, evaluadores e investigadores de riesgos.

Utilizando datos recopilados durante un experimento de trazadores atmosféricos hace tres décadas en la planta de energía nuclear Diablo Canyon en la costa central de California, decenas de miles de simulaciones por computadora y un modelo estadístico, Los investigadores del Laboratorio Nacional Lawrence Livermore (LLNL) han creado métodos que pueden estimar la fuente de una liberación atmosférica con mayor precisión que antes.

Los métodos incorporan dos modelos informáticos:el modelo de investigación y pronóstico meteorológico de EE. UU. (WRF), que produce simulaciones de campos de viento, y el modelo de dispersión comunitario FLEXPART, que predice columnas de concentración en función del tiempo, cantidad y ubicación de una liberación. Usando estos modelos, Los científicos atmosféricos Don Lucas y Matthew Simpson del Centro Nacional Asesor de Liberaciones Atmosféricas (NARAC) de LLNL han realizado simulaciones desarrolladas con fines de seguridad nacional y respuesta a emergencias.

En 1986, para evaluar el impacto de una posible liberación radiactiva en la planta de Diablo Canyon, Pacific Gas &Electric (PG&E) lanzó un gas no reactivo, Hexafloruro de azufre, a la atmósfera y recuperó datos de 150 instrumentos colocados en la planta de energía y sus alrededores. Estos datos se pusieron a disposición de los científicos del LLNL, presentándoles una oportunidad única y valiosa de probar sus modelos computacionales comparándolos con datos reales.

"De vez en cuando, los modelos que usamos en NARAC están en desarrollo y necesitamos probarlos, "Dijo Lucas." El caso de Diablo Canyon es un punto de referencia que podemos utilizar para mantener nuestras herramientas de modelado afiladas. Para este proyecto, utilizamos nuestros modelos meteorológicos de última generación y tuvimos que retroceder hasta la década de 1980, utilizando datos meteorológicos antiguos para recrear, lo mejor que pudimos, las condiciones en las que se realizaron. Estábamos desenterrando todos los datos pero incluso hacer eso no fue suficiente para determinar los patrones climáticos exactos en ese momento ".

Debido a la compleja topografía y microclima que rodea al Diablo Canyon, Lucas dijo, la incertidumbre del modelo era alta, y él y Simpson tuvieron que idear grandes conjuntos de simulaciones utilizando modelos meteorológicos y de dispersión. Como parte de un proyecto reciente de Investigación y Desarrollo Dirigido por Laboratorio (LDRD) dirigido por el científico retirado de LLNL Ron Baskett y el científico de LLNL Philip Cameron-Smith, corrieron 40, 000 simulaciones de penachos, alterar parámetros como el viento, ubicación de la liberación y cantidad de material, cada uno tarda unas 10 horas en completarse.

Uno de sus principales objetivos era reconstruir la cantidad, el lugar y la hora de la liberación cuando el clima es incierto. Para mejorar esta capacidad de modelado inverso, contaron con la ayuda de Devin Francom, una becaria de postgrado de Lawrence en el Grupo de Estadística Aplicada en LLNL. Bajo la dirección de Bruno Sanso en el Departamento de Estadística de la UC Santa Cruz, y su mentora y estadística de LLNL Vera Bulaevskaya, Francom desarrolló un modelo estadístico que se utilizó para analizar la salida de concentración de aire obtenida de estas corridas y estimó los parámetros de la liberación.

Este modelo, llamados splines de regresión adaptativa multivariante bayesiana (BMARS), fue el tema de la disertación de Francom, que defendió recientemente con éxito. BMARS es una herramienta muy poderosa para el análisis de simulaciones como las obtenidas por Simpson y Lucas. Porque es un modelo estadístico, no solo produce estimaciones puntuales de cantidades de interés, pero también proporciona una descripción completa de la incertidumbre en estas estimaciones, que es crucial para la toma de decisiones en el contexto de la respuesta de emergencia. Es más, BMARS fue particularmente adecuado para la gran cantidad de ejecuciones en este problema porque en comparación con la mayoría de los modelos estadísticos utilizados para emular la salida de la computadora, es mucho mejor para manejar grandes cantidades de datos.

"Pudimos resolver el problema inverso de encontrar de dónde proviene el material basándonos en los modelos e instrumentos avanzados en el campo, "Dijo Francom." Podríamos decir, 'vino de esta área y fue durante este período de tiempo y esto es lo que se liberó'. Más importante, podríamos hacerlo con bastante precisión y dar un margen de error asociado con nuestras estimaciones. Este es un marco completamente probabilístico, así que la incertidumbre se propagó a cada paso del camino ".

Asombrosamente, la ubicación sugerida por el método de Francom entraba en conflicto con la información de los informes técnicos del experimento. Esto fue investigado más a fondo, que reveló una discrepancia en el registro de las coordenadas cuando se realizó la prueba de 1986.

"Cuando volvimos y miramos la ubicación registrada del lanzamiento de 1986, no parecía coincidir con la descripción cualitativa de los investigadores, "Dijo Francom." Nuestra predicción sugirió que la descripción cualitativa de la ubicación era más probable que la ubicación de liberación registrada. No esperábamos encontrar eso. Fue genial ver que podíamos encontrar la posible inexactitud en los registros, y aprendamos cuál creemos que es la verdadera ubicación a través de nuestros modelos de dispersión de partículas y el emulador estadístico ".

"Este análisis es un ejemplo muy poderoso de los modelos físicos, métodos de estadística, los datos y el arsenal computacional de hoy en día se unen para proporcionar respuestas significativas a preguntas que involucran fenómenos complejos, ", Dijo Bulaevskaya." Sin todas estas piezas, Habría sido imposible obtener estimaciones precisas de las características de la liberación y describir correctamente el grado de confianza que tenemos en estos valores ".

Lucas dijo que a los investigadores eventualmente les gustaría tener un modelo que pueda ejecutarse rápidamente porque en un evento real, necesitarían saber cuándo y dónde ocurrió la liberación y cuánto se liberó de inmediato. "Emuladores rápidos, como BMARS, nos dan la capacidad de obtener estimaciones de estas cantidades con bastante rapidez, "Dijo Lucas." Si se libera material radiológico a la atmósfera y se detecta mediante sensores de viento a favor, el emulador podría brindar información sobre áreas peligrosas y potencialmente podría salvar vidas ".

Francom se trasladará al Laboratorio Nacional de Los Alamos para continuar su trabajo sobre emuladores estadísticos para analizar códigos informáticos complejos. Lucas y Simpson, junto con Cameron-Smith y Baskett, tener un artículo sobre el modelado inverso de los datos de Diablo Canyon que se está revisando para la revista Química y Física Atmosféricas . Francom y sus coautores han presentado otro artículo, centrándose en BMARS en este problema, a una revista de estadísticas y se está sometiendo a revisión por pares.