En el juego de exploración scout, para alinearse con los valores humanos, el robot aprende de los comentarios humanos a las propuestas. Crédito de la imagen:Sra. Zhen Chen@BIGAI.

Los métodos de inteligencia artificial (IA) se han vuelto cada vez más avanzados en las últimas décadas, logrando resultados notables en muchas tareas del mundo real. No obstante, la mayoría de los sistemas de IA existentes no comparten sus análisis y los pasos que condujeron a sus predicciones con los usuarios humanos, lo que puede hacer que evaluarlos de manera confiable sea extremadamente desafiante.

Un grupo de investigadores de UCLA, UCSD, la Universidad de Pekín y el Instituto de Inteligencia Artificial General de Pekín (BIGAI) ha desarrollado recientemente un nuevo sistema de IA que puede explicar sus procesos de toma de decisiones a los usuarios humanos. Este sistema, presentado en un artículo publicado en Science Robotics , podría ser un nuevo paso hacia la creación de una IA más fiable y comprensible.

"El campo de la IA explicable (XAI) tiene como objetivo generar confianza colaborativa entre robots y humanos, y el Proyecto DARPA XAI sirvió como un gran catalizador para avanzar en la investigación en esta área", dijo el Dr. Luyao Yuan, uno de los primeros autores del artículo. , le dijo a TechXplore. "Al comienzo del proyecto DARPA XAI, los equipos de investigación se enfocan principalmente en inspeccionar modelos para tareas de clasificación al revelar el proceso de decisión de los sistemas de IA al usuario; por ejemplo, algunos modelos pueden visualizar ciertas capas de modelos CNN, afirmando lograr un cierto nivel de XAI".

El Dr. Yuan y sus colegas participaron en el proyecto DARPA XAI, cuyo objetivo específico era desarrollar sistemas XAI nuevos y prometedores. Mientras participaban en el proyecto, comenzaron a reflexionar sobre lo que significaría XAI en un sentido más amplio, particularmente sobre los efectos que podría tener en las colaboraciones entre humanos y máquinas.

El artículo reciente del equipo se basa en uno de sus trabajos anteriores, también publicado en Science Robotics , donde el equipo exploró el impacto que los sistemas explicables podrían tener en las percepciones y la confianza de un usuario en la IA durante las interacciones hombre-máquina. En su estudio anterior, el equipo implementó y probó un sistema de IA físicamente (es decir, en el mundo real), mientras que en su nuevo estudio lo probaron en simulaciones.

"Nuestro paradigma contrasta con casi todos los propuestos por los equipos en el programa DARPA XAI, que se centró principalmente en lo que llamamos el paradigma máquina pasiva-usuario activo", dijo a TechXplore el profesor Yixin Zhu, uno de los supervisores del proyecto. "En estos paradigmas, los usuarios humanos deben verificar activamente e intentar descubrir qué está haciendo la máquina (por lo tanto, 'usuario activo') aprovechando algunos modelos que revelan el proceso potencial de toma de decisiones de los modelos de IA".

Los sistemas XAI que siguen lo que el Prof. Zhu llama el paradigma de "usuario activo de la máquina pasiva" requieren que los usuarios se comuniquen constantemente con la IA para comprender los procesos detrás de sus decisiones. En este contexto, la comprensión de un usuario de los procesos de una IA y la confianza en sus predicciones no afecta los futuros procesos de toma de decisiones de la IA, razón por la cual la máquina se denomina "pasiva".

Por el contrario, el nuevo paradigma presentado por el Dr. Yuan, el profesor Zhu y sus colegas sigue lo que el equipo denomina paradigma de usuario activo de máquina activa. Básicamente, esto significa que su sistema puede aprender y adaptar activamente su toma de decisiones en función de los comentarios que recibe de los usuarios sobre la marcha. Esta capacidad de adaptarse contextualmente es característica de lo que a menudo se denomina la tercera/próxima ola de IA.

"Para que los sistemas de IA ayuden a sus usuarios como esperamos que lo hagan, los sistemas actuales requieren que el usuario codifique objetivos definidos por expertos", dijo el Dr. Yuan. "Esto limita el potencial de los equipos hombre-máquina, ya que tales objetivos pueden ser difíciles de definir en muchas tareas, lo que hace que los sistemas de IA sean inaccesibles para la mayoría de las personas. Para abordar este problema, nuestro trabajo permite que los robots calculen las intenciones y los valores de los usuarios durante la colaboración. en tiempo real, ahorrando la necesidad de codificar objetivos complicados y específicos para los robots de antemano, proporcionando así un mejor paradigma de trabajo en equipo humano-máquina".

El objetivo del sistema creado por el Dr. Yuan y sus colegas es lograr la llamada "alineación de valores". Básicamente, esto significa que un usuario humano puede entender por qué un robot o una máquina actúa de una manera específica o llega a conclusiones específicas, y la máquina o el robot puede inferir por qué el usuario humano actúa de una manera específica. Esto puede mejorar significativamente la comunicación humano-robot.

"Esta naturaleza bidireccional y el rendimiento en tiempo real son los mayores desafíos del problema y lo más destacado de nuestras contribuciones", dijo el profesor Zhu. "Al unir los puntos anteriores, creo que ahora comprenderá por qué el título de nuestro artículo es "Alineación bidireccional in situ del valor humano-robot".

Para entrenar y probar su sistema XAI, los investigadores diseñaron un juego llamado "exploración exploradora", en el que los humanos deben completar una tarea en equipos. Uno de los aspectos más importantes de este juego es que los humanos y los robots necesitan alinear sus llamadas "funciones de valor".

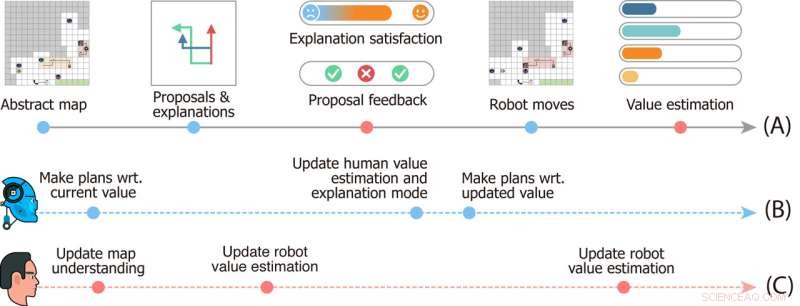

Diseño del estudio del Juego de Exploración Scout. La línea de tiempo (A) denota eventos que suceden en una sola ronda del juego. Las líneas de tiempo (B) y (C) representan la dinámica mental de los robots y el usuario, respectivamente. Crédito de la imagen:Sra. Zhen Chen@BIGAI.

"En el juego, un grupo de robots puede percibir el entorno; esto emula aplicaciones del mundo real donde se supone que el grupo de robots trabaja de forma autónoma para minimizar las intervenciones humanas", dijo el profesor Zhu. "El usuario humano, sin embargo, no puede interactuar directamente con el entorno; en cambio, se le dio al usuario una función de valor particular, representada por la importancia de algunos factores (por ejemplo, el tiempo total para completar el tiempo y los recursos recolectados sobre la marcha). )".

En el juego de exploración scout, el equipo de robots no tiene acceso a la función de valor otorgada a los usuarios humanos y necesitan inferirla. Como este valor no se puede expresar ni comunicar fácilmente, para completar la tarea, el robot y el equipo humano deben deducirlo uno del otro.

“La comunicación es bidireccional en el juego:por un lado, el robot propone múltiples planes de tareas al usuario y explica los pros y los contras de cada una de ellas, y por otro el usuario retroalimenta las propuestas y califica cada explicación, "Dr. Xiaofeng Gao, uno de los primeros autores del artículo, le dijo a TechXplore. "Estas comunicaciones bidireccionales permiten lo que se conoce como alineación de valores".

Esencialmente, para completar tareas en la "exploración de exploración", el equipo de robots debe comprender cuál es la función de valor de los usuarios humanos simplemente basada en la retroalimentación del ser humano. Mientras tanto, los usuarios humanos aprenden las estimaciones de valor actuales de los robots y pueden ofrecer comentarios que los ayuden a mejorar y, en última instancia, los guíen hacia la respuesta correcta.

"También integramos la teoría de la mente en nuestro modelo computacional, haciendo posible que el sistema de IA genere explicaciones adecuadas para revelar su valor actual y estimar el valor de los usuarios a partir de sus comentarios en tiempo real durante la interacción", dijo el Dr. Gao. "Luego llevamos a cabo extensos estudios de usuarios para evaluar nuestro marco".

En las evaluaciones iniciales, el sistema creado por el Dr. Yuan, el Prof. Zhu, el Dr. Gao y sus colegas lograron resultados notables, lo que llevó a la alineación de valores en el juego de exploración scout sobre la marcha y de forma interactiva. El equipo encontró que el robot se alineó con la función de valor del usuario humano tan pronto como en un 25% del juego, mientras que los usuarios podían obtener percepciones precisas de las funciones de valor de la máquina aproximadamente a la mitad del juego.

"El emparejamiento de convergencia (i) del valor de los robots a los valores reales del usuario y (ii) de la estimación del usuario de los valores de los robots a los valores actuales de los robots forma una alineación de valores bidireccional anclada por el valor real del usuario", dijo el Dr. dijo Yuan. "Creemos que nuestro marco destaca la necesidad de construir máquinas inteligentes que aprendan y entiendan nuestras intenciones y valores a través de interacciones, que son fundamentales para evitar muchas de las historias distópicas de ciencia ficción representadas en las novelas y en la pantalla grande".

El trabajo reciente de este equipo de investigadores es una contribución significativa al área de investigación centrada en el desarrollo de una IA más comprensible. El sistema que propusieron podría servir de inspiración para la creación de otros sistemas XAI en los que los robots o asistentes inteligentes interactúen activamente con los humanos, compartan sus procesos y mejoren su rendimiento en función de los comentarios que reciben de los usuarios.

"La alineación de valores es nuestro primer paso hacia la colaboración genérica entre humanos y robots", explicó el Dr. Yuan. "En este trabajo, la alineación de valores ocurre en el contexto de una sola tarea. Sin embargo, en muchos casos, un grupo de agentes coopera en muchas tareas. Por ejemplo, esperamos que un robot doméstico nos ayude con muchas tareas diarias, en lugar de comprar muchos robots, cada uno de los cuales solo es capaz de realizar un tipo de trabajo".

Hasta ahora, el sistema XAI de los investigadores ha obtenido resultados muy prometedores. En sus próximos estudios, el Dr. Yuan, el Prof. Zhu, el Dr. Gao y sus colegas planean explorar instancias de alineación de valores humano-robot que podrían aplicarse en muchas tareas diferentes del mundo real, para que los usuarios humanos y los agentes de IA puedan acumular información que adquirieron sobre los procesos y capacidades de los demás a medida que colaboran en diferentes tareas.

"En nuestros próximos estudios, también buscamos aplicar nuestro marco a más tareas y robots físicos", dijo el Dr. Gao. "Además de los valores, creemos que alinear otros aspectos de los modelos mentales (por ejemplo, creencias, deseos, intenciones) entre humanos y robots también sería una dirección prometedora".

Los investigadores esperan que su nuevo paradigma explicable de IA ayude a mejorar la colaboración entre humanos y máquinas en numerosas tareas. Además, esperan que su enfoque aumente la confianza de los humanos en los sistemas basados en IA, incluidos asistentes inteligentes, robots, bots y otros agentes virtuales.

"Por ejemplo, puede corregir Alexa o Google Home cuando comete un error, pero cometerá el mismo error la próxima vez que lo use", agregó el profesor Zhu. "Cuando su Roomba va a algún lugar al que no quiere que vaya e intenta luchar contra él, no lo entiende, ya que solo sigue la lógica de IA predefinida. Todo esto prohíbe que la IA moderna entre en nuestros hogares. Como la primera paso, nuestro trabajo muestra el potencial de resolver estos problemas, un paso más cerca de lograr lo que DARPA llamó 'adaptación contextual' en la tercera ola de IA".

© 2022 Red Ciencia X Permitir que los robots sociales aprendan las relaciones entre las rutinas de los usuarios y su estado de ánimo