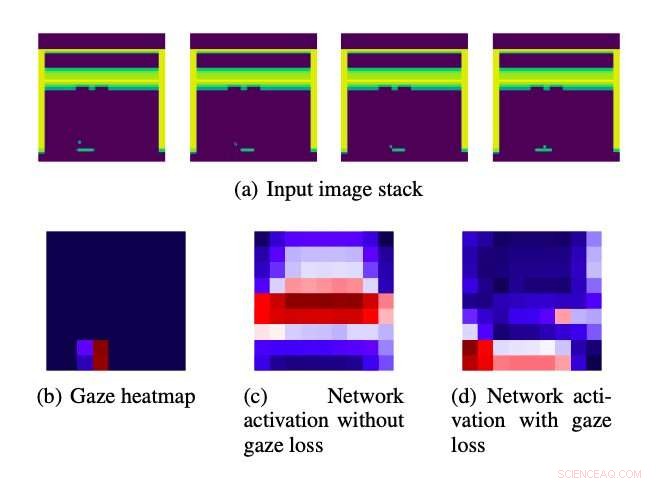

Pila de imágenes de entrada alimentadas a los algoritmos. Crédito:Saran et al.

Los estudios de psicología anteriores sugieren que la mirada humana puede codificar las intenciones de los humanos mientras realizan tareas cotidianas. como hacer un sándwich o una bebida caliente. Similar, Se ha descubierto que la mirada humana mejora el rendimiento de los métodos de aprendizaje por imitación. que permiten a los robots aprender a realizar tareas imitando a los demostradores humanos.

Inspirado por estos hallazgos previos, Investigadores de la Universidad de Texas en Austin y la Universidad de Tufts han ideado recientemente una estrategia novedosa para mejorar los algoritmos de aprendizaje por imitación utilizando datos relacionados con la mirada humana. El método que desarrollaron, descrito en un artículo publicado previamente en arXiv, utiliza la mirada de un demostrador humano para dirigir la atención de los algoritmos de aprendizaje por imitación hacia áreas que creen que son importantes, basado en el hecho de que los usuarios humanos los atendían.

"Los algoritmos de aprendizaje profundo deben aprender a identificar características importantes en escenas visuales, por ejemplo, un personaje de videojuego o un enemigo, al mismo tiempo que aprende a utilizar esas funciones para la toma de decisiones, "El profesor Scott Niekum de la Universidad de Texas en Austin dijo a TechXplore." Nuestro enfoque hace que esto sea más fácil, utilizando la mirada humana como una pista que indica qué elementos visuales de la escena son más importantes para la toma de decisiones ".

El enfoque ideado por los investigadores implica el uso de información relacionada con la mirada humana como guía, Dirigir la atención de un modelo de aprendizaje profundo a características particularmente importantes en los datos que está analizando. Esta guía relacionada con la mirada está codificada en la función de pérdida aplicada a los modelos de aprendizaje profundo durante el entrenamiento.

"Investigaciones anteriores que exploraban el uso de datos de la mirada para mejorar los enfoques de aprendizaje por imitación, por lo general, integraban los datos de la mirada mediante el entrenamiento de algoritmos con parámetros más fáciles de aprender, haciendo que el aprendizaje sea computacionalmente costoso y requiriendo información visual tanto en el momento del entrenamiento como en el de la prueba, "Akanksha Saran, un doctorado estudiante de la Universidad de Texas en Austin que participó en el estudio, dijo a TechXplore. "Queríamos explorar vías alternativas para aumentar fácilmente los enfoques de aprendizaje de imitación existentes con datos de la mirada humana, sin aumentar los parámetros de aprendizaje ".

La estrategia desarrollada por Niekum, Saran y sus colegas se pueden aplicar a la mayoría de las arquitecturas basadas en redes neuronales convolucionales (CNN). Usando un componente auxiliar de pérdida de mirada que guía las arquitecturas hacia políticas más efectivas, su enfoque puede, en última instancia, mejorar el rendimiento de una variedad de algoritmos de aprendizaje profundo.

El nuevo enfoque tiene varias ventajas sobre otras estrategias que utilizan datos relacionados con la mirada para guiar modelos de aprendizaje profundo. Los dos más notables son que no requiere acceso a los datos de la mirada en el momento de la prueba y la adición de parámetros suplementarios que se pueden aprender.

Los investigadores evaluaron su enfoque en una serie de experimentos, usándolo para mejorar diferentes arquitecturas de aprendizaje profundo y luego probando su rendimiento en los juegos de Atari. Descubrieron que mejoró significativamente el rendimiento de tres algoritmos de aprendizaje de imitación diferentes, superando a un método de referencia que utiliza datos de la mirada humana. Es más, El enfoque de los investigadores coincidió con el rendimiento de otra estrategia que utiliza datos relacionados con la mirada tanto durante el entrenamiento como en el momento de la prueba. pero eso implica aumentar el número de parámetros que se pueden aprender.

"Nuestros hallazgos sugieren que los beneficios de algunos enfoques propuestos anteriormente provienen de un aumento en el número de parámetros aprendibles en sí mismos, no solo por el uso de datos de la mirada, ", Dijo Saran." Nuestro método muestra mejoras comparables sin agregar parámetros a las técnicas de aprendizaje de imitación existentes ".

Mientras realizaban sus experimentos, los investigadores también observaron que el movimiento de los objetos en una escena dada por sí solo no explica completamente la información codificada por la mirada. En el futuro, la estrategia que desarrollaron podría usarse para mejorar el rendimiento de los algoritmos de aprendizaje por imitación en una variedad de tareas diferentes. Los investigadores esperan que su trabajo también sirva de base para estudios adicionales destinados a utilizar datos relacionados con la mirada humana para avanzar en las técnicas computacionales.

"Si bien nuestro método reduce las necesidades computacionales durante el tiempo de prueba, requiere ajustar los hiperparámetros durante el entrenamiento para obtener un buen rendimiento, "Dijo Saran." Aliviar esta carga durante el entrenamiento mediante la codificación de otras intuiciones del comportamiento de la mirada humana será un aspecto del trabajo futuro ".

El enfoque desarrollado por Saran y sus colegas ha demostrado hasta ahora ser muy prometedor, sin embargo, hay varias formas en las que podría mejorarse aún más. Por ejemplo, Actualmente no modela todos los aspectos de los datos relacionados con la mirada humana que podrían ser beneficiosos para las aplicaciones de aprendizaje por imitación. Los investigadores esperan centrarse en algunos de estos otros aspectos en sus estudios futuros.

"Finalmente, Las conexiones temporales de la mirada y la acción aún no se han explorado y podrían ser críticas para lograr más beneficios en el desempeño. ", Dijo Saran." También estamos trabajando en el uso de otras señales de maestros humanos para mejorar el aprendizaje de imitación, como el audio humano que acompaña a las demostraciones ".

© 2020 Science X Network