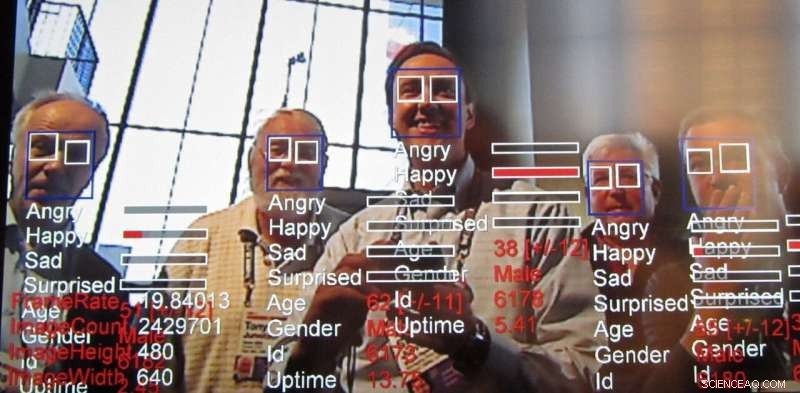

Tecnología de reconocimiento de emociones, una consecuencia de la tecnología de reconocimiento facial, sigue avanzando rápidamente. Crédito:Steve Jurvetson / flickr, CC BY-SA

En su informe anual, el Instituto AI Now, un centro de investigación interdisciplinario que estudia las implicaciones sociales de la inteligencia artificial, pidió una prohibición de la tecnología diseñada para reconocer las emociones de las personas en ciertos casos. Específicamente, los investigadores dijeron que afectan la tecnología de reconocimiento, también llamada tecnología de reconocimiento de emociones, no debe utilizarse en decisiones que "afectan la vida de las personas y el acceso a las oportunidades, "como decisiones de contratación o evaluaciones del dolor, porque no es lo suficientemente precisa y puede dar lugar a decisiones sesgadas.

¿Qué es esta tecnología? que ya se está utilizando y comercializando, y ¿por qué genera preocupaciones?

Crecimiento del reconocimiento facial

Los investigadores han estado trabajando activamente en algoritmos de visión por computadora que pueden determinar las emociones y la intención de los humanos. además de hacer otras inferencias, durante al menos una década. El análisis de la expresión facial existe desde al menos 2003. Las computadoras han podido comprender las emociones incluso más tiempo. Esta última tecnología se basa en técnicas centradas en datos conocidas como "aprendizaje automático, "algoritmos que procesan datos para" aprender "a tomar decisiones, para lograr un reconocimiento de afecto aún más preciso.

El desafío de leer las emociones

Los investigadores siempre buscan hacer cosas nuevas basándose en lo que se ha hecho antes. El reconocimiento de emociones es atractivo porque, de alguna manera, nosotros, como seres humanos, podemos lograr esto relativamente bien incluso desde una edad temprana, y, sin embargo, replicar hábilmente esa habilidad humana utilizando la visión por computadora sigue siendo un desafío. Si bien es posible hacer cosas bastante notables con imágenes, como estilizar una foto para que parezca dibujada por un artista famoso e incluso crear rostros fotorrealistas, sin mencionar los llamados deepfakes, la capacidad de inferir propiedades como las emociones humanas a partir de una imagen real siempre ha ha sido de interés para los investigadores.

Las emociones son difíciles porque tienden a depender del contexto. Por ejemplo, cuando alguien se concentra en algo, puede parecer que simplemente está pensando. El reconocimiento facial ha recorrido un largo camino mediante el aprendizaje automático, pero identificar el estado emocional de una persona basándose únicamente en mirar la cara de una persona carece de información clave. Las emociones se expresan no solo a través de la expresión de una persona, sino también dónde se encuentra y qué está haciendo. Estas señales contextuales son difíciles de incorporar incluso a los algoritmos modernos de aprendizaje automático. Para abordar esto, hay esfuerzos activos para aumentar las técnicas de inteligencia artificial para considerar el contexto, no solo para el reconocimiento de emociones, sino para todo tipo de aplicaciones.

Leer las emociones de los empleados

El informe publicado por AI Now arroja luz sobre algunas formas en que la inteligencia artificial se está aplicando a la fuerza laboral para evaluar la productividad de los trabajadores e incluso desde la etapa de la entrevista. Analizar imágenes de entrevistas, especialmente para los solicitantes de empleo remotos, ya está en marcha. Si los gerentes pueden tener una idea de las emociones de sus subordinados desde la entrevista hasta la evaluación, toma de decisiones sobre otros asuntos laborales como aumentos, las promociones o asignaciones pueden terminar siendo influenciadas por esa información. Pero hay muchas otras formas en que se podría utilizar esta tecnología.

¿Por qué la preocupación?

Este tipo de sistemas casi siempre son justos, responsabilidad, Transparencia y fallas éticas ("DESTINO") incrustadas en su coincidencia de patrones. Por ejemplo, un estudio encontró que los algoritmos de reconocimiento facial calificaron los rostros de las personas negras como más enojados que los rostros blancos, incluso cuando sonreían.

Muchos grupos de investigación están abordando este problema pero parece claro a estas alturas que el problema no se puede resolver exclusivamente a nivel tecnológico. Los problemas relacionados con FATE en IA requerirán un esfuerzo continuo y concertado por parte de quienes utilizan la tecnología para estar al tanto de estos problemas y abordarlos. Como destaca el informe AI Now:"A pesar del aumento en el contenido de ética de la IA ... los principios y declaraciones éticos rara vez se centran en cómo se puede implementar la ética de la IA y si son efectivas". Señala que tales declaraciones de ética de la IA ignoran en gran medida preguntas sobre cómo, dónde, y quién pondrá en práctica esas directrices. En realidad, Es probable que todos deban ser conscientes de los tipos de sesgos y debilidades que presentan estos sistemas. similar a cómo debemos ser conscientes de nuestros propios prejuicios y los de los demás.

El problema con las prohibiciones generales de la tecnología

Una mayor precisión y facilidad en el monitoreo persistente trae consigo otras preocupaciones más allá de la ética. También hay una serie de preocupaciones de privacidad relacionadas con la tecnología en general, que abarca desde la proliferación de cámaras que sirven como alimentadores policiales hasta potencialmente hacer que los datos confidenciales sean anónimos.

Con estas preocupaciones éticas y de privacidad, una reacción natural podría ser pedir la prohibición de estas técnicas. Ciertamente, La aplicación de inteligencia artificial a los resultados de las entrevistas de trabajo o los procedimientos de sentencia penal parece peligrosa si los sistemas tienen sesgos de aprendizaje o no son confiables. Sin embargo, existen aplicaciones útiles, por ejemplo, para ayudar a detectar señales de advertencia para prevenir el suicidio de jóvenes y detectar conductores ebrios. Esa es una de las razones por las que incluso los investigadores preocupados, Los reguladores y los ciudadanos en general no han llegado a pedir prohibiciones generales de las tecnologías relacionadas con la inteligencia artificial.

Combinando IA y juicio humano

Por último, Los diseñadores de tecnología y la sociedad en su conjunto deben observar detenidamente cómo se inyecta la información de los sistemas de IA en los procesos de toma de decisiones. Estos sistemas pueden dar resultados incorrectos como cualquier otra forma de inteligencia. También son notoriamente malos para calificar su propia confianza, no a diferencia de los humanos, incluso en tareas más simples como la capacidad de reconocer objetos. También quedan importantes desafíos técnicos en la lectura de emociones, especialmente considerando el contexto para inferir emociones.

Si las personas confían en un sistema que no es preciso para tomar decisiones, los usuarios de ese sistema están en peores condiciones. También es bien sabido que los humanos tienden a confiar en estos sistemas más que en otras figuras de autoridad. A la luz de esta, nosotros, como sociedad, debemos considerar cuidadosamente la equidad de estos sistemas, responsabilidad, transparencia y ética tanto durante el diseño como en la aplicación, siempre manteniendo a un humano como quien toma las decisiones finales.

Este artículo se vuelve a publicar de The Conversation bajo una licencia Creative Commons. Lea el artículo original.