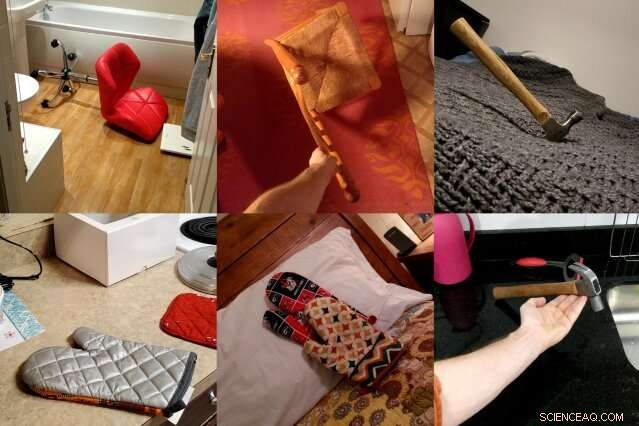

ObjectNet, un conjunto de datos de fotos creado por investigadores del MIT y de IBM, muestra objetos desde ángulos extraños, en múltiples orientaciones, y contra fondos variados para representar mejor la complejidad de los objetos 3D. Los investigadores esperan que el conjunto de datos conduzca a nuevas técnicas de visión por computadora que funcionen mejor en la vida real. Crédito:Instituto de Tecnología de Massachusetts

Los modelos de visión por computadora han aprendido a identificar objetos en fotos con tanta precisión que algunos pueden superar a los humanos en algunos conjuntos de datos. Pero cuando esos mismos detectores de objetos se sueltan en el mundo real, su rendimiento cae notablemente, creando preocupaciones de confiabilidad para los autos autónomos y otros sistemas críticos para la seguridad que usan visión artificial.

En un esfuerzo por cerrar esta brecha de desempeño, un equipo de investigadores del MIT e IBM se propuso crear un tipo muy diferente de conjunto de datos de reconocimiento de objetos. Se llama ObjectNet, un juego en ImageNet, la base de datos de fotografías colaborativas responsable de impulsar gran parte del boom moderno de la inteligencia artificial.

A diferencia de ImageNet, que presenta fotos tomadas de Flickr y otros sitios de redes sociales, ObjectNet presenta fotos tomadas por autónomos pagados. Los objetos se muestran inclinados de lado, disparado en ángulos extraños, y exhibido en habitaciones llenas de desorden. Cuando se probaron los principales modelos de detección de objetos en ObjectNet, sus tasas de precisión cayeron de un máximo del 97 por ciento en ImageNet a solo un 50-55 por ciento.

"Creamos este conjunto de datos para decirle a la gente que el problema del reconocimiento de objetos sigue siendo un problema difícil, "dice Boris Katz, un científico investigador en el Laboratorio de Ciencias de la Computación e Inteligencia Artificial del MIT (CSAIL) y en el Centro de Cerebros, Mentes y Máquinas (CBMM). "Necesitamos algo mejor, algoritmos más inteligentes ". Katz y sus colegas presentarán ObjectNet y sus resultados en la Conferencia sobre Sistemas de Procesamiento de Información Neural (NeurIPS).

Aprendizaje profundo, la técnica que impulsa gran parte del progreso reciente en IA, utiliza capas de "neuronas" artificiales para encontrar patrones en grandes cantidades de datos sin procesar. Aprende a distinguir decir, la silla en una foto después de entrenar con cientos o miles de ejemplos. Pero incluso los conjuntos de datos con millones de imágenes no pueden mostrar cada objeto en todas sus posibles orientaciones y configuraciones, creando problemas cuando los modelos se encuentran con estos objetos en la vida real.

ObjectNet se diferencia de los conjuntos de datos de imágenes convencionales en otro aspecto importante:no contiene imágenes de entrenamiento. La mayoría de los conjuntos de datos se dividen en datos para entrenar los modelos y probar su rendimiento. Pero el conjunto de entrenamiento a menudo comparte similitudes sutiles con el conjunto de prueba, en efecto, dando a los modelos un adelanto de la prueba.

A primera vista, ImageNet, a 14 millones de imágenes, parece enorme. Pero cuando se excluye su conjunto de entrenamiento, es comparable en tamaño a ObjectNet, a los 50, 000 fotografías.

"Si queremos saber qué tan bien funcionarán los algoritmos en el mundo real, deberíamos probarlos en imágenes que sean imparciales y que nunca antes hayan visto, "dice el coautor del estudio, Andrei Barbu, un científico investigador en CSAIL y CBMM.

Un conjunto de datos que intenta capturar la complejidad de los objetos del mundo real.

Pocas personas pensarían en compartir las fotos de ObjectNet con sus amigos, y ese es el punto. Los investigadores contrataron a trabajadores independientes de Amazon Mechanical Turk para que tomaran fotografías de cientos de objetos domésticos colocados al azar. Los trabajadores recibieron asignaciones de fotografías en una aplicación, con instrucciones animadas que les indican cómo orientar el objeto asignado, desde qué ángulo disparar, y si posar el objeto en la cocina, cuarto de baño, Cuarto, o sala de estar.

Querían eliminar tres sesgos comunes:los objetos mostrados de frente, en posiciones icónicas, y en entornos altamente correlacionados, por ejemplo, platos apilados en la cocina.

Se necesitaron tres años para concebir el conjunto de datos y diseñar una aplicación que estandarizara el proceso de recopilación de datos. "Descubrir cómo recopilar datos de una manera que controle varios sesgos fue increíblemente complicado, "dice el coautor del estudio, David Mayo, estudiante de posgrado en el Departamento de Ingeniería Eléctrica e Informática del MIT. "También tuvimos que realizar experimentos para asegurarnos de que nuestras instrucciones fueran claras y que los trabajadores supieran exactamente lo que se les pedía".

Se necesitó otro año para recopilar los datos reales, y en el fin, la mitad de todas las fotos enviadas por autónomos tuvieron que ser descartadas por no cumplir con las especificaciones de los investigadores. En un intento por ayudar, algunos trabajadores agregaron etiquetas a sus objetos, los escenificó sobre fondos blancos, o trataron de mejorar la estética de las fotos que se les asignó para tomar.

Muchas de las fotos fueron tomadas fuera de los Estados Unidos. y por lo tanto, algunos objetos pueden parecer desconocidos. Las naranjas maduras son verdes los plátanos vienen en diferentes tamaños, y la ropa aparece en una variedad de formas y texturas.

Object Net frente a ImageNet:cómo se comparan los principales modelos de reconocimiento de objetos

Cuando los investigadores probaron modelos de visión por computadora de última generación en ObjectNet, encontraron una caída de rendimiento de 40 a 45 puntos porcentuales de ImageNet. Los resultados muestran que los detectores de objetos todavía tienen dificultades para comprender que los objetos son tridimensionales y se pueden rotar y mover a nuevos contextos. dicen los investigadores. "Estas nociones no están integradas en la arquitectura de los detectores de objetos modernos, "dice el coautor del estudio, Dan Gutfreund, investigador de IBM.

Para mostrar que ObjectNet es difícil precisamente por cómo se ven y colocan los objetos, los investigadores permitieron que los modelos se entrenaran con la mitad de los datos de ObjectNet antes de probarlos en la mitad restante. La capacitación y las pruebas en el mismo conjunto de datos generalmente mejoran el rendimiento, pero aquí los modelos mejoraron solo ligeramente, lo que sugiere que los detectores de objetos aún tienen que comprender completamente cómo existen los objetos en el mundo real.

Los modelos de visión por computadora han mejorado progresivamente desde 2012, cuando un detector de objetos llamado AlexNet aplastó a la competencia en el concurso anual ImageNet. A medida que los conjuntos de datos se han vuelto más grandes, el rendimiento también ha mejorado.

Pero al diseñar versiones más grandes de ObjectNet, con sus ángulos de visión y orientaciones adicionales, no conducirá necesariamente a mejores resultados, advierten los investigadores. El objetivo de ObjectNet es motivar a los investigadores a idear la próxima ola de técnicas revolucionarias, tanto como lo hizo el lanzamiento inicial del desafío ImageNet.

"La gente alimenta estos detectores con grandes cantidades de datos, pero hay rendimientos decrecientes, "dice Katz." No se puede ver un objeto desde todos los ángulos y en todos los contextos. Nuestra esperanza es que este nuevo conjunto de datos dé como resultado una visión por computadora robusta sin fallas sorprendentes en el mundo real ".

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre la investigación del MIT, innovación y docencia.