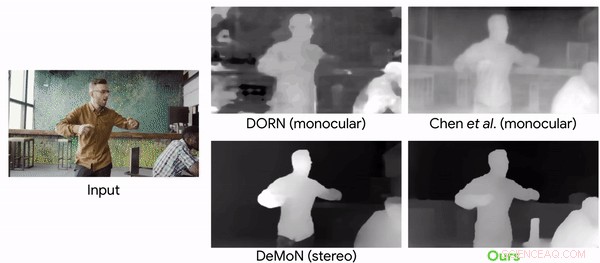

Comparación de modelos de predicción de profundidad con un videoclip con cámaras y personas en movimiento. Crédito:Google

¿Quién dijo que la locura viral llamada Mannequin Challenge (MC) está terminada y desempolvada? No tan. Los investigadores han recurrido al Desafío que llamó la atención en 2016 para cumplir su objetivo. Utilizaron el MC para entrenar una red neuronal que puede reconstruir la información de profundidad de los videos.

"Aprender las profundidades de las personas en movimiento observando a las personas congeladas" es el nombre de su artículo, ahora en arXiv, escrito por Zhengqi Li, Tali Dekel, Forrester Cole, Richard Tucker, Noah Snavely, Ce Liu y William Freeman. El documento fue presentado en abril de este año.

¿El desafío del maniquí? ¿Quién puede olvidar? Esta fue una tendencia de YouTube que se volvió viral. Anthony Alford en InfoQ devolvió a los lectores a 2016, cuando un meme de Internet hizo que las personas se unieran en grupos para hacerse pasar por maniquíes. Estaban "congelados", pero un camarógrafo hacía movimientos alrededor de la escena tomando un video desde diferentes ángulos.

Alford escribió:porque la cámara se mueve y el resto de la escena es estática, Los métodos de paralaje pueden reconstruir fácilmente mapas de profundidad precisos de figuras humanas en una variedad de poses.

Como afirmaron los autores, los videos implicaron congelar en diversos, poses naturales, mientras una cámara de mano recorría la escena.

Para entrenar la red neuronal, el equipo convirtió 2, 000 de los videos en imágenes 2-D con datos de profundidad de alta resolución.

Alford dijo que de los 2, 000 videos de YouTube MC, se produjo un conjunto de datos de 4, 690 secuencias con un total de más de 170K pares de profundidad de imagen válidos. El objetivo del sistema de aprendizaje fue el mapa de profundidad conocido para la imagen de entrada, calculado a partir de los videos de MC. La DNN aprendió a tomar la imagen de entrada, mapa de profundidad inicial, y mascara humana, y generar un mapa de profundidad "refinado" donde se completaron los valores de profundidad de los humanos.

Christine Fisher, Engadget :"Para entrenar la red neuronal, los investigadores convirtieron los clips en imágenes 2-D, estimó la pose de la cámara y creó mapas de profundidad. Luego, la IA pudo predecir la profundidad de los objetos en movimiento en los videos con mayor precisión de lo que era posible anteriormente ".

Aceptar el desafío fue descrito por dos de los coautores del artículo en mayo en un blog de Google.

"Debido a que toda la escena está inmóvil (solo se mueve la cámara), métodos basados en triangulación, como estéreo de múltiples vistas (MVS), funcionan, y podemos obtener mapas de profundidad precisos para toda la escena, incluidas las personas que se encuentran en ella. Recopilamos aproximadamente 2000 videos de este tipo, que abarca una amplia gama de escenas realistas con personas posando de forma natural en diferentes configuraciones de grupo ". Tali Dekel, científico investigador y Forrester Cole, ingeniero de software, percepción de la máquina, escribieron más sobre el desafío que asumieron.

"El sistema visual humano tiene una notable capacidad para dar sentido a nuestro mundo 3-D desde su proyección 2-D. Incluso en entornos complejos con múltiples objetos en movimiento, las personas pueden mantener una interpretación factible de la geometría y el orden de profundidad de los objetos. El campo de la visión por computadora ha estudiado durante mucho tiempo cómo lograr capacidades similares mediante la reconstrucción computacional de la geometría de una escena a partir de datos de imágenes en 2-D, pero la reconstrucción sólida sigue siendo difícil en muchos casos ".

Por qué es importante:"Si bien ha habido un aumento reciente en el uso del aprendizaje automático para la predicción de profundidad, Este trabajo es el primero en adaptar un enfoque basado en el aprendizaje al caso de la cámara y el movimiento humano simultáneos, ", dijeron en el blog de mayo". En este trabajo, nos centramos específicamente en los seres humanos porque son un objetivo interesante para la realidad aumentada y los efectos de vídeo en 3-D ".

Hablando de resultados, Karen Hao, Revisión de tecnología del MIT , dijo que los investigadores convirtieron 2, 000 de los videos en imágenes 2-D con datos de profundidad de alta resolución y los usó para entrenar una red neuronal. Luego pudo predecir la profundidad de los objetos en movimiento en un video con una precisión mucho mayor de la que era posible con los métodos de vanguardia anteriores.

© 2019 Science X Network