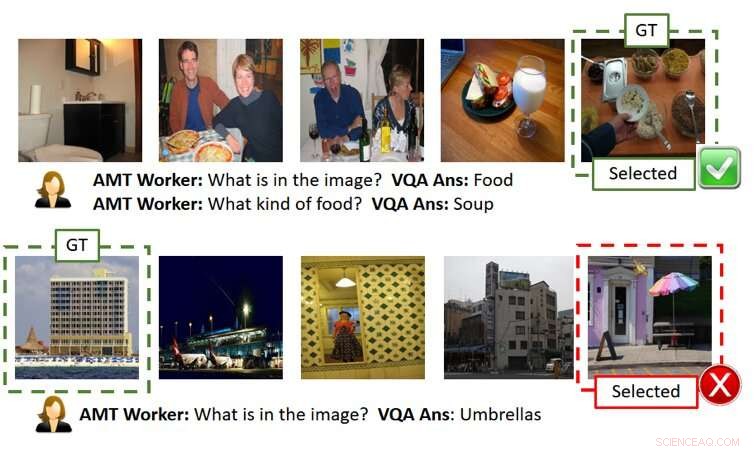

La figura de arriba muestra dos jugadas sin explicaciones (cada fila es un ejemplo de jugabilidad). Como se muestra en la fila superior, el usuario (es decir, AMT Worker, dado que hemos utilizado Amazon Mechanical Turk para evaluaciones basadas en fuentes de multitud a gran escala) es capaz de descubrir la imagen secreta correctamente si se obtienen respuestas precisas de inteligencia artificial. Sin embargo, como se muestra en la fila inferior, el usuario puede fallar incluso cuando las respuestas de la IA son razonables pero un poco fuera de lugar (es decir, hay una estructura en forma de paraguas al lado del edificio, aunque no es el foco de la imagen de la verdad del terreno). GT significa Ground Truth (es decir, la imagen secreta), Seleccionada es la imagen seleccionada por el usuario después de hacer las preguntas y obtener las respuestas y / o explicaciones. Crédito:Ray et al.

En años recientes, Los investigadores han intentado hacer que la inteligencia artificial (IA) sea más transparente mediante el desarrollo de algoritmos que pueden explicar sus acciones y comportamiento. ya que esto podría fomentar una mayor confianza en las máquinas y mejorar las interacciones humano-IA. A pesar de sus esfuerzos, Hasta ahora, muy pocos estudios han evaluado de manera tangible el impacto de las explicaciones de la IA en el desempeño logrado en tareas que involucran la colaboración humano-IA.

Para abordar esta brecha en la literatura existente, un equipo de investigadores de SRI International ha creado un juego de adivinanzas de imágenes de inteligencia artificial humana inspirado en el popular juego 20 Preguntas (20Q), que se puede utilizar para evaluar la utilidad de las explicaciones de la máquina. Su papel publicado recientemente en arXiv, es uno de los primeros en explorar los efectos de desarrollar una IA más "explicable".

"La idea surgió mientras estábamos trabajando en un proyecto de DARPA, "Arijit Ray, un científico informático de SRI International que llevó a cabo el estudio, dijo a TechXolore. "En este proyecto, estamos desarrollando sistemas de inteligencia artificial explicables, que no solo generan la salida deseada (por ejemplo, detección de objetos, respuestas a preguntas, etc.) sino también explicaciones de cómo llegaron a ese resultado. Necesitábamos un mecanismo para evaluar si las explicaciones adicionales proporcionadas por las IA eran útiles para que el usuario pudiera comprender mejor los sistemas de IA. Para tal fin, Creamos una tarea colaborativa interactiva entre humanos e inteligencia artificial, GuessWhich asistido por explicación (ExAG), que es una adaptación del famoso juego 20Q, para demostrar la eficacia de las diversas técnicas de explicación mecánica que estamos desarrollando ".

El juego de adivinar imágenes desarrollado por Ray y sus colegas se parece mucho al popular juego 20 Preguntas, que generalmente involucra a dos jugadores. En 20T, un jugador piensa en algo y el segundo jugador intenta adivinar qué es haciendo 20 preguntas cerradas (es decir, preguntas que solo pueden responderse con 'sí' o 'no').

En ExAG, la adaptación del juego ideada por Ray y sus colegas, a un usuario se le muestran cinco imágenes, uno de los cuales ha sido elegido por el sistema de IA como la 'imagen secreta'. Esencialmente, el usuario debe averiguar cuál de las imágenes que vio es la 'imagen secreta, 'haciendo preguntas en lenguaje natural al respecto.

En contraste con el juego tradicional de 20Q, en ExAG, los usuarios humanos pueden hacer preguntas tanto cerradas como abiertas. Por ejemplo, podrían preguntar '¿qué hay en la imagen? "¿Dónde se tomó la imagen?" etcétera. El sistema de inteligencia artificial responde a las preguntas de un usuario de una en una y, opcionalmente, puede explicar sus respuestas.

Basado en estas respuestas, el usuario intentará adivinar la imagen que la IA había seleccionado originalmente. El objetivo general del juego es identificar correctamente la 'imagen secreta' haciendo la menor cantidad de preguntas posible.

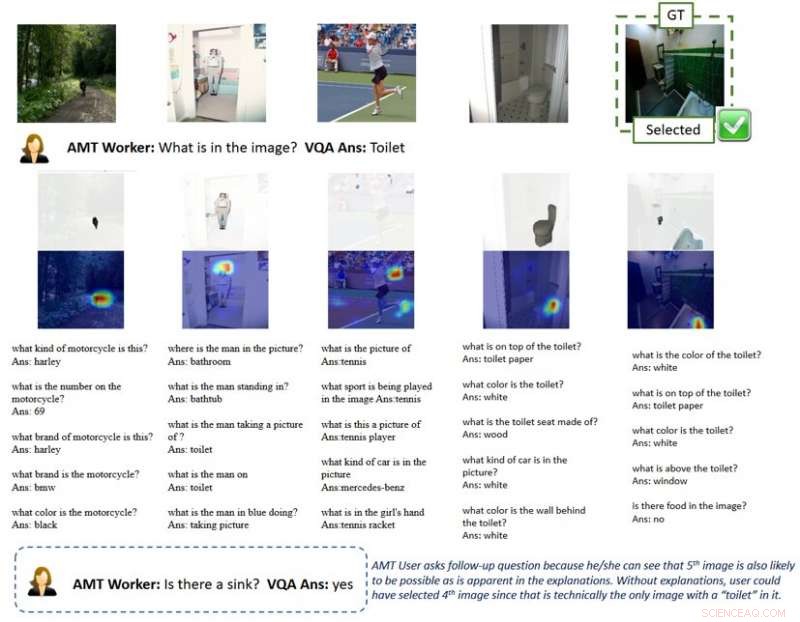

"El sistema de IA ofrece dos modos de explicación, visual y textual, "Ray explicó." Para obtener explicaciones visuales, el sistema de IA genera mapas de calor que destacan las regiones que respaldan sus respuestas. Por ejemplo, si un usuario pregunta qué hay en la imagen, y parece un perro, la IA resaltará la región del perro y dirá que esto es lo que lleva a la respuesta "es un perro". Para explicaciones textuales, por otra parte, el sistema de IA proporciona respuestas a preguntas relacionadas para cada una de las imágenes. Entonces, si preguntas qué está haciendo una persona y la respuesta es navegar, por ejemplo, también responderá preguntas relacionadas como '¿qué veo en la imagen? Un surfista '. '¿Dónde está tomada la foto? Una playa.'

Debido a la naturaleza del juego de adivinar imágenes, La calidad de las respuestas y explicaciones proporcionadas por la IA puede afectar significativamente el éxito y el rendimiento de un usuario humano. Vale la pena señalar que el rendimiento actual de vanguardia en la respuesta visual a preguntas es de alrededor del 65 por ciento, lo que significa que el sistema de inteligencia artificial genera respuestas correctas el 65 por ciento del tiempo.

Ray y sus colegas observaron que los usuarios normalmente tenían éxito en ExAG al aprovechar las explicaciones de la IA, especialmente cuando las respuestas mismas eran incorrectas. Por ejemplo, si la 'imagen secreta' retrata a un perro, pero la IA responde 'es un surfista, 'una explicación visual podría ayudar a un usuario humano a darse cuenta del error de la IA. Según los investigadores, esto demuestra que su juego es una herramienta adecuada para evaluar la utilidad de las explicaciones de la IA.

La figura de arriba muestra un juego con explicaciones. La explicación visual del mapa de calor resalta las regiones en las imágenes que conducen a respuestas de IA. Con tal explicación, los usuarios comprenden que los sistemas de IA pueden captar objetos que no son el foco principal de la imagen en la perspectiva humana cuando responden una pregunta general como "qué hay en la imagen". Esto sugiere al usuario que haga preguntas de seguimiento y finalmente seleccione la imagen secreta correctamente. GT significa Ground Truth (es decir, la imagen secreta), Seleccionada es la imagen seleccionada por el usuario después de hacer las preguntas y obtener las respuestas y / o explicaciones. Crédito:Ray et al.

"En mi opinión, El resultado más interesante de nuestro estudio es que los usuarios pueden usar solo algunas buenas explicaciones para ganar juegos cuando las respuestas de la IA son en su mayoría incorrectas. "Ray dijo." En contraste, para juegos con una precisión de respuesta similar pero sin explicaciones, los usuarios confían ciegamente en las respuestas generadas por la IA y pierden el juego. Esto respalda la importancia de incluso unas pocas buenas explicaciones para los sistemas de colaboración humano-IA, especialmente cuando el sistema de IA es imperfecto, que es en la mayoría de los casos en estos días ".

Para explicar mejor esta idea, Ray ofrece el ejemplo de los vehículos autónomos. En los ultimos años, ha habido mucho debate sobre su seguridad, también debido a accidentes ocurridos durante la prueba de los vehículos. Según Ray, las explicaciones efectivas de la IA podrían fomentar una mayor confianza en la seguridad de los vehículos autónomos, ya que permitirían a los conductores humanos identificar problemas de antemano y prevenir accidentes.

"Por ejemplo, supongamos que el sistema de IA tiene problemas para detectar los carriles de forma fiable, "Dijo Ray." Dado que la carretera es recta en este momento, sin información adicional, el usuario no podría saber si la IA está fallando. Incluso si tuviera algunas dudas, probablemente no haría nada hasta el último momento, cuando el coche tiene que girar, no lo hace y se estrella, que sería demasiado tarde. A diferencia de, si una pantalla en el automóvil mostrara explicaciones de cómo la IA percibe el medio ambiente, como mapas de calor, el usuario podría advertir la falla latente de la IA y tomar el control de la rueda de antemano ".

Los investigadores encontraron que las explicaciones útiles afectaron positivamente el desempeño de los usuarios humanos en el juego de adivinar imágenes. Sus hallazgos sugieren que tener al menos una explicación 'correcta' fue significativamente útil, particularmente en los casos en los que las respuestas de la IA a las preguntas de los usuarios eran "ruidosas" o estaban mal definidas. Curiosamente, Los jugadores desarrollaron una preferencia por las explicaciones sobre las respuestas y, a menudo, calificaron las explicaciones de la IA como "útiles".

"Creo que si bien varias líneas de trabajo intentaron proporcionar explicaciones para los resultados o acciones de un sistema de inteligencia artificial, el nuestro es el primer estudio que introduce una tarea de colaboración entre humanos y máquinas para evaluar la efectividad de las explicaciones de la IA; por lo tanto, aportó mucha información sobre cómo las explicaciones de la IA podrían mejorar las interacciones entre humanos y robots, "Yi Yao, un gerente técnico senior de SRI International que participó en el estudio, dijo a TechXplore.

El estudio realizado por Ray y sus colegas es uno de los primeros en proporcionar evidencia tangible de la utilidad de las explicaciones de la IA. Los investigadores esperan que su investigación finalmente sirva de base para el desarrollo de sistemas de IA que puedan actuar racionalmente en la sociedad. así conectar y relacionarse mejor con los humanos.

Según Ray, Los sistemas de inteligencia artificial que pueden explicar claramente el razonamiento y los procesos detrás de sus acciones serían un importante paso adelante en el desarrollo de máquinas inteligentes. Respondiendo preguntas de forma eficaz y racionalizando sus decisiones, Estos sistemas podrían fomentar un mayor sentido de confianza en la IA, así como una relación más profunda con él.

"Muchas otras empresas, grupos y grupos de investigación han abordado la IA explicable, y ha habido muchas propuestas sobre cómo ampliar los modelos y sistemas de IA existentes para proporcionar explicaciones a los usuarios, "dijo Giedrius Burachas, un científico informático senior en SRI International e investigador principal detrás del estudio DARPA que condujo al desarrollo del juego Guess Which. "Si bien se generaron muchas ideas, evidencia de que estas ideas funcionaban, por lo que uno de los lados fuertes de nuestra investigación es que proporciona evidencia indiscutible de que cierto tipo de explicaciones son realmente muy efectivas para mejorar la colaboración con los sistemas de IA, sino también para generar confianza en ellos ".

Hasta ahora, El trabajo de Ray y sus colegas se centró principalmente en tareas de respuesta visual a preguntas (VQA), donde los usuarios hacen preguntas sobre imágenes y una IA responde. Ahora planean continuar su investigación sobre técnicas de explicación de IA, aplicar estas técnicas a un ámbito más amplio de tareas de IA.

"También continuaremos desarrollando protocolos para evaluar la efectividad de las explicaciones generadas por IA con mayor granularidad (p. Ej., ¿Qué explicación es más efectiva bajo qué escenarios?) Y desde diferentes perspectivas (p. Ej., ¿Las explicaciones ayudan a los usuarios a construir el modelo mental?), "Ray dijo." Para cerrar el ciclo, Usaremos las lecciones aprendidas de estas evaluaciones para desarrollar métodos de explicación más efectivos. Creemos que el Santo Grial de la IA explicable es idear explicaciones que no solo informen a los usuarios, sino que también mejoren el rendimiento de la máquina al mejorar su capacidad de razonamiento ".

Además de explorar los efectos de las explicaciones de la IA sobre el rendimiento y las percepciones de los usuarios humanos, por lo tanto, a los investigadores les gustaría investigar su impacto en los propios sistemas de IA. Sienten que las explicaciones de la IA también podrían hacer que los sistemas de IA sean inherentemente mejores, ya que irían adquiriendo gradualmente habilidades de razonamiento y racionalización.

© 2019 Science X Network