Los jugadores de baloncesto Darren Collision (izquierda) y Gordon Hayward (derecha). Crédito:basketball-reference.com

La tecnología de reconocimiento facial ha progresado hasta el punto en que ahora interpreta las emociones en las expresiones faciales. Este tipo de análisis se utiliza cada vez más en la vida diaria. Por ejemplo, las empresas pueden utilizar software de reconocimiento facial para ayudar con las decisiones de contratación. Otros programas escanean las caras en multitudes para identificar amenazas a la seguridad pública.

Desafortunadamente, esta tecnología lucha por interpretar las emociones de los rostros negros. Mi nuevo estudio publicado el mes pasado, muestra que la tecnología de análisis emocional asigna más emociones negativas a los rostros de los hombres negros que a los rostros de los hombres blancos.

Esta no es la primera vez que se ha demostrado que los programas de reconocimiento facial están sesgados. Google etiquetó a los rostros negros como gorilas. Las cámaras identificaron rostros asiáticos parpadeando. Los programas de reconocimiento facial lucharon por identificar correctamente el género de las personas con piel más oscura.

Mi trabajo contribuye a un llamado creciente para comprender mejor el sesgo oculto en el software de inteligencia artificial.

Sesgo de medición

Examinar el sesgo en los sistemas de reconocimiento facial que analizan las emociones de las personas, Usé un conjunto de datos de 400 fotos de jugadores de la NBA de la temporada 2016 a 2017, porque los jugadores son similares en su vestimenta, atletismo, edad y género. También, ya que estos son retratos profesionales, los jugadores miran a la cámara en la imagen.

Pasé las imágenes a través de dos tipos conocidos de software de reconocimiento emocional. Ambos asignaron a los jugadores negros puntuaciones emocionales más negativas en promedio, no importa cuánto sonrieron.

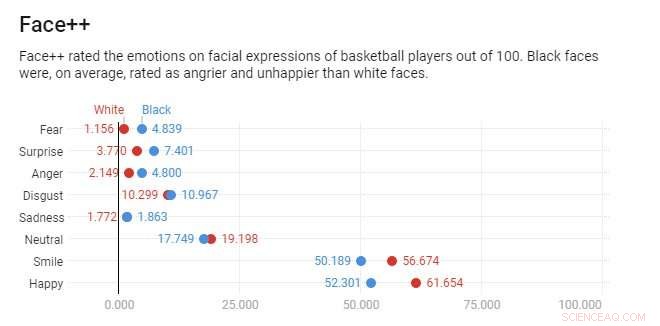

Crédito:Gráfico:La conversación, CC-BY-ND Fuente:SSRN (2018)

Por ejemplo, considere las fotos oficiales de la NBA de Darren Collison y Gordon Hayward. Ambos jugadores están sonriendo y, según el programa de reconocimiento y análisis facial Face ++, Darren Collison y Gordon Hayward tienen puntuaciones de sonrisa similares:48,7 y 48,1 de 100, respectivamente.

Sin embargo, Face ++ califica la expresión de Hayward como 59.7 por ciento feliz y 0.13 por ciento enojada y la expresión de Collison como 39.2 por ciento feliz y 27 por ciento enojada. Collison es visto tan enojado como feliz y mucho más enojado que Hayward, a pesar de que el programa de reconocimiento facial reconoce que ambos jugadores están sonriendo.

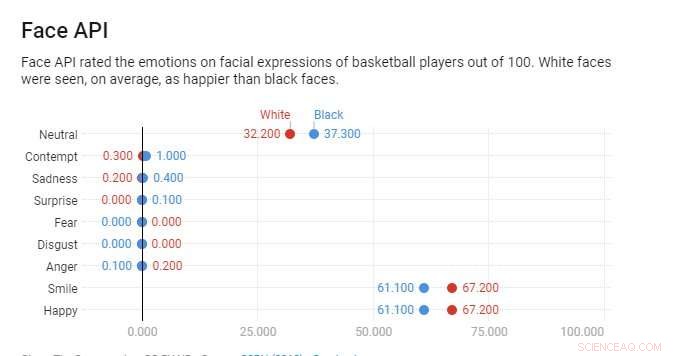

A diferencia de, Face API de Microsoft veía a ambos hombres felices. Todavía, Collison es visto como menos feliz que Hayward, con puntuaciones de felicidad del 98 y el 93 por ciento, respectivamente. A pesar de su sonrisa, La colisión incluso se puntúa con una pequeña cantidad de desprecio, mientras que Hayward no tiene ninguno.

En todas las imágenes de la NBA, surge el mismo patrón. De media, Face ++ califica los rostros negros como dos veces más enojados que los rostros blancos. Face API califica las caras negras como tres veces más despectivas que las caras blancas. Después de emparejar jugadores según sus sonrisas, Ambos programas de análisis facial tienen aún más probabilidades de asignar las emociones negativas de ira o desprecio a los rostros negros.

Estereotipado por la IA

Mi estudio muestra que los programas de reconocimiento facial exhiben dos tipos distintos de sesgo.

Crédito:Gráfico:La conversación, CC-BY-ND Fuente:SSRN (2018)

Primero, los rostros negros se calificaron consistentemente como más enojados que los rostros blancos por cada sonrisa. Face ++ mostró este tipo de sesgo. Segundo, los rostros negros siempre se puntuaron como más enojados si había alguna ambigüedad en su expresión facial. Face API mostró este tipo de disparidad. Incluso si los rostros negros están sonriendo parcialmente, mi análisis mostró que los sistemas asumían más emociones negativas en comparación con sus contrapartes blancas con expresiones similares. Los puntajes emocionales promedio fueron mucho más cercanos entre las carreras, pero todavía había diferencias notables para las caras en blanco y negro.

Esta observación se alinea con otras investigaciones, lo que sugiere que los profesionales negros deben amplificar las emociones positivas para recibir paridad en sus evaluaciones de desempeño en el lugar de trabajo. Los estudios muestran que las personas perciben a los hombres negros como más amenazadores físicamente que los hombres blancos, incluso cuando son del mismo tamaño.

Algunos investigadores sostienen que la tecnología de reconocimiento facial es más objetiva que los humanos. Pero mi estudio sugiere que el reconocimiento facial refleja los mismos sesgos que tienen las personas. Las expresiones faciales de los hombres negros se puntúan con las emociones asociadas con comportamientos amenazantes con más frecuencia que los hombres blancos. incluso cuando están sonriendo. Hay buenas razones para creer que el uso del reconocimiento facial podría formalizar estereotipos preexistentes en algoritmos, incorporándolos automáticamente a la vida cotidiana.

Hasta que el reconocimiento facial evalúe las caras en blanco y negro de manera similar, Las personas negras pueden necesitar exagerar sus expresiones faciales positivas, esencialmente sonreír más, para reducir la ambigüedad y las interpretaciones potencialmente negativas de la tecnología.

Aunque innovador, la inteligencia artificial puede perpetrar y exacerbar la dinámica de poder existente, lo que lleva a un impacto dispar en todos los grupos raciales / étnicos. Es necesaria cierta responsabilidad social para garantizar la equidad para todos los grupos porque el reconocimiento facial, como la mayoría de la inteligencia artificial, suele ser invisible para las personas más afectadas por sus decisiones.

Este artículo se ha vuelto a publicar de The Conversation con una licencia de Creative Commons. Lea el artículo original.