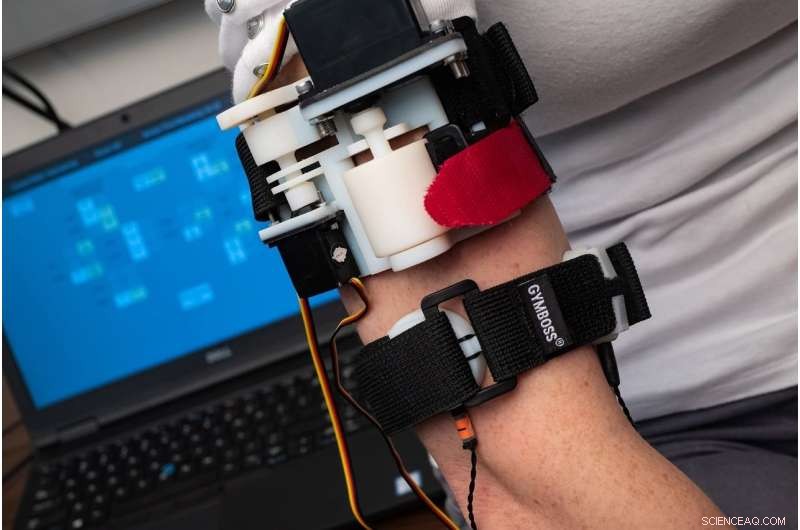

Un nuevo estudio realizado por investigadores del Laboratorio de Mecatrónica e Interfaces Hápticas de la Universidad de Rice descubrió que los usuarios necesitaban menos de dos horas de capacitación para aprender a "sentir" la mayoría de las palabras que se transmitían mediante un brazalete háptico que se comunica con señales compuestas por apretón, estiramiento y vibración. Crédito:Jeff Fitlow / Rice University

Imagina el pánico. Las alarmas de incendio suenan. El humo llena la habitación y te quedas solo con el sentido del tacto, sintiéndose desesperadamente a lo largo de las paredes mientras intenta encontrar la entrada.

Ahora imagina que la tecnología te guía por el sentido del tacto. Tu reloj inteligente alertado por las mismas alarmas, comienza a "hablar" a través de tu piel, dar direcciones con vibraciones codificadas, aprieta y tira con significados tan claros como las palabras habladas.

Ese escenario podría desarrollarse en el futuro gracias a la tecnología que se está desarrollando en el laboratorio de la ingeniera mecánica de Rice, Marcia O'Malley. que ha pasado más de 15 años estudiando cómo las personas pueden usar el sentido háptico para interactuar con la tecnología, ya sean robots, prótesis o software de rehabilitación de accidentes cerebrovasculares.

"La piel cubre todo nuestro cuerpo y tiene muchos tipos de receptores, y lo vemos como un canal de información infrautilizado, "dijo O'Malley, director de la Iniciativa de Robótica de Rice y del Laboratorio de Interfaces Hápticas y Mecatrónica de Rice (MAHI).

Las situaciones de emergencia como el escenario de incendio descrito anteriormente son solo un ejemplo. O'Malley dijo que hay muchas "otras situaciones en las que es posible que no desee mirar una pantalla, o ya tiene muchas cosas visualizadas. Por ejemplo, un cirujano o un piloto podrían encontrar muy útil tener otro canal de comunicación ".

Nathan Dunkelberger, estudiante graduado de la Universidad Rice, trabajando en el laboratorio MAHI. Crédito:Jeff Fitlow / Rice University

Con nuevos fondos de la National Science Foundation, O'Malley y la colaboradora de la Universidad de Stanford, Allison Okamura, pronto comenzarán a diseñar y probar software, dispositivos portátiles que permiten comunicaciones táctiles directas de robots cercanos. La financiación, que es posible gracias a la Iniciativa Nacional de Robótica, está orientado al desarrollo de nuevas formas de comunicación que eviten el desorden visual y el ruido para comunicarse rápida y claramente.

"Algunos almacenes y fábricas ya tienen más robots que trabajadores humanos, y tecnologías como los automóviles autónomos y los dispositivos de asistencia física harán que las interacciones entre humanos y robots sean mucho más comunes en el futuro cercano, "dijo O'Malley, Stanley C. Moore, profesor de Ingeniería Mecánica de Rice y profesor de Ciencias de la Computación e Ingeniería Eléctrica e Informática.

Suave, los dispositivos portátiles pueden formar parte de un uniforme, como una manga, guante, correa de reloj o cinturón. Al entregar una variedad de señales hápticas, como un apretón fuerte o suave, o un estiramiento de la piel en una dirección y lugar en particular, O'Malley dijo que podría ser posible construir un "vocabulario" significativo de sensaciones que tengan significados específicos.

"Puedo ver la señal de giro de un automóvil, pero solo si lo estoy mirando, ", Dijo O'Malley. Queremos tecnología que permita a las personas sentir a los robots a su alrededor y comprender claramente lo que esos robots están a punto de hacer y dónde están a punto de estar". Idealmente, si hacemos esto correctamente, las señales serán fáciles de aprender e intuitivas ".

Los estudiantes graduados de Rice University Jenny Sullivan (izquierda) y Nathan Dunkelberger demuestran el brazalete háptico MISSIVE en el Laboratorio de Mecatrónica e Interfaces Hápticas. Crédito:Jeff Fitlow / Rice University

Por ejemplo, en un estudio presentado este mes en el Simposio Internacional sobre Computadoras Usables (ISWC) en Singapur, El estudiante graduado de MAHI, Nathan Dunkelberger, demostró que los usuarios necesitaban menos de dos horas de formación para aprender a "sentir" la mayoría de las palabras que se transmitían mediante un brazalete táctil. La "interfaz multisensorial de estiramiento, desarrollada por MAHI, exprimir y elementos vibrotáctiles integrados, "o MISIVO, consta de dos bandas que se ajustan alrededor de la parte superior del brazo. Uno de estos puede apretar suavemente, como un manguito de presión arterial, y también puede estirar o tirar levemente de la piel en una dirección. La segunda banda tiene motores vibrotáctiles, las mismas alarmas vibratorias que se usan en la mayoría de los teléfonos celulares, en la parte frontal, espalda, lados izquierdo y derecho del brazo.

Usando estas señales en combinación, MAHI creó un vocabulario de 23 de los sonidos vocales más comunes para los angloparlantes. Estos sonidos que se llaman fonemas, se utilizan en combinación para formar palabras. Por ejemplo, las palabras "ay" y "chow" contienen los mismos dos fonemas, "ow" y "ch, "en un orden diferente. O'Malley dijo que comunicarse con fonemas es más rápido que escribir palabras letra por letra, y los sujetos no necesitan saber cómo se escribe una palabra, sólo cómo se pronuncia.

Dunkelberger dijo que los hablantes de inglés usan 39 fonemas, pero para el estudio de prueba de concepto, él y sus colegas de MAHI utilizaron 23 de los más comunes. En pruebas, los sujetos recibieron un entrenamiento limitado, solo 1 hora, 40 minutos, lo que implicó escuchar el fonema hablado y sentirlo mostrado por MISSIVE. En pruebas posteriores, Se pidió a los sujetos que identificaran 150 palabras habladas que constan de dos a seis fonemas cada una. Los examinados respondieron correctamente el 86 por ciento de las palabras.

"Lo que esto muestra es que es posible, con una cantidad limitada de entrenamiento, para enseñar a las personas un pequeño vocabulario de palabras que puedan recordar con gran precisión, "Dijo O'Malley." Y definitivamente hay cosas que podemos optimizar. Podríamos hacer que las señales sean más destacadas. Podríamos refinar el protocolo de entrenamiento. Este fue nuestro enfoque de prototipo, y funcionó bastante bien ".

En el proyecto NSF, ella dijo que el equipo no se enfocará en transmitir palabras, pero transmitiendo información no verbal.

"Hay muchas aplicaciones potenciales para los sistemas de retroalimentación háptica que se pueden llevar puestos para permitir la comunicación entre individuos, entre individuos y robots o entre individuos y agentes virtuales como mapas de Google, ", Dijo O'Malley." Imagine un reloj inteligente que pueda transmitirle todo un lenguaje de señales directamente, y en privado, para que no tenga que mirar la pantalla en absoluto ".