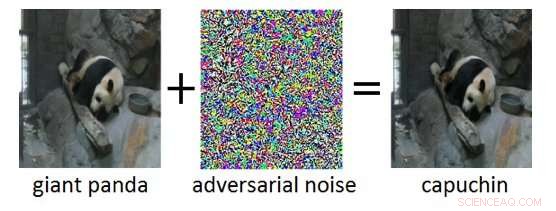

Figura 1:Ejemplo de adversario (derecha) obtenido al agregar ruido de adversario (centro) a una imagen de entrada limpia (izquierda). Si bien el ruido agregado en el ejemplo del adversario es imperceptible para un humano, lleva a la Deep Neural Network a clasificar erróneamente la imagen como "capuchino" en lugar de "panda gigante". Crédito:IBM Blog Research

Los últimos años han sido testigos de enormes avances en el desarrollo de la inteligencia artificial (IA). Los sistemas de IA modernos logran un rendimiento a nivel humano en tareas cognitivas como reconocer objetos en imágenes, vídeos de anotar, convertir voz en texto, o traducir entre diferentes idiomas. Muchos de estos resultados revolucionarios se basan en redes neuronales profundas (DNN). Los DNN son modelos complejos de aprendizaje automático que guardan cierta similitud con las neuronas interconectadas del cerebro humano. Los DNN son capaces de manejar entradas de alta dimensión (por ejemplo, millones de píxeles en imágenes de alta resolución), representar patrones en esas entradas en varios niveles de abstracción, y relacionar esas representaciones con conceptos semánticos de alto nivel.

Una propiedad intrigante de los DNN es que, aunque normalmente son muy precisos, son vulnerables a los llamados ejemplos contradictorios. Los ejemplos de adversarios son insumos (digamos, imágenes) que han sido modificadas deliberadamente para producir una respuesta deseada por un DNN. Un ejemplo se muestra en la Figura 1:aquí, la adición de una pequeña cantidad de ruido adverso a la imagen de un panda gigante lleva a la DNN a clasificar erróneamente esta imagen como un capuchino. A menudo, el objetivo de los ejemplos contradictorios es una clasificación errónea o una predicción incorrecta específica que beneficiaría a un atacante.

Los ataques contradictorios representan una amenaza real para el despliegue de sistemas de inteligencia artificial en aplicaciones críticas para la seguridad. Alteraciones de imágenes prácticamente indetectables, video, habla, y otros datos se han elaborado para confundir a los sistemas de inteligencia artificial. Dichas alteraciones se pueden diseñar incluso si el atacante no tiene un conocimiento exacto de la arquitectura del DNN o acceso a sus parámetros. Aún más preocupante, Los ataques adversarios se pueden lanzar en el mundo físico:en lugar de manipular los píxeles de una imagen digital, los adversarios podrían evadir los sistemas de reconocimiento facial usando anteojos especialmente diseñados, o anular los sistemas de reconocimiento visual en vehículos autónomos pegando parches a las señales de tráfico.

IBM Research Ireland está lanzando la Caja de herramientas de solidez contra adversarios, una biblioteca de software de código abierto, para apoyar tanto a los investigadores como a los desarrolladores en la defensa de DNN contra ataques adversarios y, por lo tanto, hacer que los sistemas de IA sean más seguros. El lanzamiento será anunciado en la conferencia RSA por el Dr. Sridhar Muppidi, Miembro de IBM, Vicepresidente y director de tecnología de IBM Security, y Koos Lodewijkx, Vicepresidente y CTO de Operaciones y Respuesta de Seguridad (SOAR), Seguridad de IBM.

La Caja de herramientas de robustez adversaria está diseñada para ayudar a los investigadores y desarrolladores a crear nuevas técnicas de defensa, así como en el despliegue de defensas prácticas de sistemas de IA del mundo real. Los investigadores pueden utilizar la Caja de herramientas de robustez de los adversarios para comparar las defensas novedosas contra el estado de la técnica. Para desarrolladores, la biblioteca proporciona interfaces que apoyan la composición de sistemas de defensa integrales utilizando métodos individuales como bloques de construcción.

La biblioteca está escrita en Python, el lenguaje de programación más utilizado para desarrollar, probar y desplegar DNN. Comprende algoritmos de última generación para crear ejemplos contradictorios, así como métodos para defender DNN contra ellos. El enfoque para defender DNN es triple:

Para comenzar con la Caja de herramientas de robustez de los adversarios, consulte la versión de código abierto en github.com/IBM/adversarial-robustness-toolbox. La versión incluye una amplia documentación y tutoriales para ayudar a los investigadores y desarrolladores a comenzar rápidamente. Se está preparando un documento técnico en el que se describen los detalles de los métodos implementados en la biblioteca.

Esta primera versión de Adversarial Robustness Toolbox admite DNN implementados en los marcos de aprendizaje profundo de TensorFlow y Keras. Las versiones futuras extenderán el soporte a otros marcos populares como PyTorch o MXNet. En la actualidad, la biblioteca está destinada principalmente a mejorar la solidez contradictoria de los sistemas de reconocimiento visual, sin embargo, Estamos trabajando en versiones futuras que incluirán adaptaciones a otros modos de datos como voz, texto o series de tiempo.

Como proyecto de código abierto, La ambición de la Caja de herramientas de solidez contra adversarios es crear un ecosistema vibrante de contribuyentes tanto de la industria como del mundo académico. La principal diferencia con los esfuerzos en curso similares es el enfoque en los métodos de defensa, y sobre la componibilidad de los sistemas de defensa prácticos. Esperamos que el proyecto Adversarial Robustness Toolbox estimule la investigación y el desarrollo en torno a la solidez adversarial de las DNN, y avanzar en la implementación de IA segura en aplicaciones del mundo real. Comparta con nosotros su experiencia al trabajar con la Caja de herramientas de solidez contra adversarios y cualquier sugerencia para futuras mejoras.