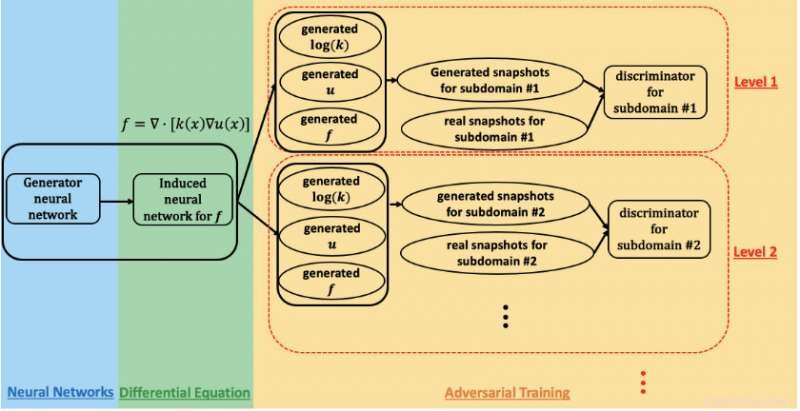

Un esquema de la red adversaria generativa informada por la física que se utiliza para estimar parámetros y cuantificar la incertidumbre en el flujo subterráneo en el sitio de Hanford. Crédito:Prabhat, Laboratorio Nacional Lawrence Berkeley

Una colaboración de investigación entre el Laboratorio Nacional Lawrence Berkeley (Berkeley Lab), Laboratorio Nacional del Noroeste del Pacífico (PNNL), Universidad de Brown, y NVIDIA ha logrado un rendimiento exaflop en la supercomputadora Summit con una aplicación de aprendizaje profundo que se utiliza para modelar el flujo subterráneo en el estudio de la remediación de desechos nucleares. Su logro, que se presentará durante el taller "Aprendizaje profundo en supercomputadoras" en SC19, demuestra la promesa de las redes generativas adversas (GAN) informadas por la física para analizar complejos, problemas científicos a gran escala.

"En ciencia conocemos las leyes de la física y los principios de observación:masa, impulso, energía, etc., "dijo George Karniadakis, profesor de matemáticas aplicadas en Brown y coautor del artículo del taller SC19. "El concepto de GAN informados por la física es codificar información previa de la física en la red neuronal. Esto le permite ir más allá del dominio de entrenamiento, lo cual es muy importante en aplicaciones donde las condiciones pueden cambiar ".

Se han aplicado GAN para modelar la apariencia del rostro humano con una precisión notable, señaló Prabhat, coautor del artículo SC19 que dirige el equipo de servicios de datos y análisis en el Centro Nacional de Computación Científica de Investigación Energética de Berkeley Lab. "En la ciencia, Berkeley Lab ha explorado la aplicación de vanilla GAN para crear universos sintéticos y experimentos de física de partículas; Uno de los desafíos abiertos hasta ahora ha sido la incorporación de limitaciones físicas en las predicciones, ", dijo." George y su grupo en Brown han sido pioneros en el enfoque de incorporar la física en las GAN y usarlas para sintetizar datos; en este caso, campos de flujo subsuperficiales ".

Para este estudio, los investigadores se centraron en el sitio de Hanford, establecido en 1943 como parte del Proyecto Manhattan para producir plutonio para armas nucleares y, finalmente, hogar del primer reactor de producción de plutonio a gran escala del mundo, otros ocho reactores nucleares, y cinco complejos de procesamiento de plutonio. Cuando terminó la producción de plutonio en 1989, Quedaron atrás decenas de millones de galones de desechos radioactivos y químicos en grandes tanques subterráneos y más de 100 millas cuadradas de agua subterránea contaminada como resultado de la eliminación de aproximadamente 450 mil millones de galones de líquidos en los sitios de disposición del suelo. Entonces, durante los últimos 30 años, el Departamento de Energía de EE. UU. Ha estado trabajando con la Agencia de Protección Ambiental y el Departamento de Ecología del Estado de Washington para limpiar Hanford, que se encuentra en 580 millas cuadradas (casi 500, 000 acres) en el centro-sur de Washington, partes enteras adyacentes al río Columbia, el río más grande del noroeste del Pacífico y una vía fundamental para la industria y la vida silvestre.

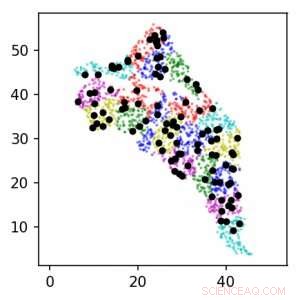

Usando GAN basados en la física en la supercomputadora Summit, el equipo de investigación pudo estimar parámetros y cuantificar la incertidumbre en el flujo subterráneo. Esta imagen muestra la ubicación de los sensores alrededor del sitio de Hanford para los niveles 1 (negro) y 2 (color). Las unidades están en km. Crédito:Laboratorio Nacional Lawrence Berkeley

Para realizar un seguimiento del esfuerzo de limpieza, los trabajadores han confiado en la perforación de pozos en el sitio de Hanford y la colocación de sensores en esos pozos para recopilar datos sobre las propiedades geológicas y el flujo de agua subterránea y observar la progresión de los contaminantes. Los entornos subterráneos como el sitio de Hanford son muy heterogéneos con diferentes propiedades espaciales, explicó Alex Tartakovsky, matemático computacional en PNNL y coautor del artículo de SC19. "La estimación de las propiedades del sitio de Hanford a partir de datos solo requeriría más de un millón de mediciones, y en la práctica tenemos quizás mil. Las leyes de la física nos ayudan a compensar la falta de datos ".

"El enfoque estándar de estimación de parámetros es asumir que los parámetros pueden adoptar muchas formas diferentes, y luego, para cada forma, debe resolver ecuaciones de flujo subterráneo quizás millones de veces para determinar los parámetros que mejor se ajustan a las observaciones, ", Agregó Tartakovsky. Pero para este estudio, el equipo de investigación tomó un rumbo diferente:usar una GAN basada en la física y computación de alto rendimiento para estimar parámetros y cuantificar la incertidumbre en el flujo subterráneo.

Para este trabajo de validación temprana, los investigadores optaron por utilizar datos sintéticos, datos generados por un modelo computarizado basado en el conocimiento de expertos sobre el sitio de Hanford. Esto les permitió crear una representación virtual del sitio que luego podrían manipular según fuera necesario en función de los parámetros que estaban interesados en medir, principalmente la conductividad hidráulica y la carga hidráulica, ambas claves para modelar la ubicación de los contaminantes. Los estudios futuros incorporarán datos de sensores reales y condiciones del mundo real.

"El propósito inicial de este proyecto era estimar la precisión de los métodos, por lo que usamos datos sintéticos en lugar de mediciones reales, ", Dijo Tartakovsky." Esto nos permitió estimar el rendimiento de los GANS informados por la física en función del número de mediciones ".

Al entrenar al GAN en la supercomputadora Summit en el Oak Ridge Leadership Computing Facility OLCF, el equipo pudo lograr un rendimiento máximo y sostenido de 1.2 exaflop, el primer ejemplo de una arquitectura GAN a gran escala aplicada a SPDE. La extensión geográfica, heterogeneidad espacial, y múltiples escalas de correlación de longitud del sitio de Hanford requirieron entrenar el modelo GAN en miles de dimensiones, por lo que el equipo desarrolló una implementación altamente optimizada que escaló a 27, 504 GPU NVIDIA V100 Tensor Core y 4, 584 nodos en Summit con una eficiencia de escala del 93,1%.

"Lograr una escala y un rendimiento tan masivos requirió una optimización de la pila completa y múltiples estrategias para extraer el máximo paralelismo, "dijo Mike Houston, quien lidera el equipo de AI Systems en NVIDIA. "A nivel de fichas, optimizamos la estructura y el diseño de la red neuronal para maximizar la utilización de Tensor Core a través de la compatibilidad con cuDNN en TensorFlow. A nivel de nodo, utilizamos NCCL y NVLink para el intercambio de datos de alta velocidad. Y a nivel del sistema, optimizamos Horovod y MPI no solo para combinar los datos y los modelos, sino también para manejar las estrategias paralelas del adversario. Para maximizar la utilización de nuestras GPU, tuvimos que fragmentar los datos y luego distribuirlos para alinearlos con la técnica de paralelización ".

"Esta es una nueva marca para las arquitecturas GAN, ", Dijo Prabhat." Queríamos crear un sustituto económico para una simulación muy costosa, y lo que pudimos mostrar aquí es que una arquitectura GAN restringida por la física puede producir campos espaciales consistentes con nuestro conocimiento de la física. Además, este proyecto ejemplar reunió a expertos del modelado del subsuelo, matemáticas Aplicadas, aprendizaje profundo, y HPC. A medida que el DOE considera aplicaciones más amplias del aprendizaje profundo, y en particular, GAN:para problemas de simulación, Espero que estos resultados inspiren a varios equipos de investigación ".

El papel, "Altamente escalable, GAN informados por la física para soluciones de aprendizaje de PDE estocásticas, "se presentará en el taller SC19 Deep Learning on Supercomputers. I