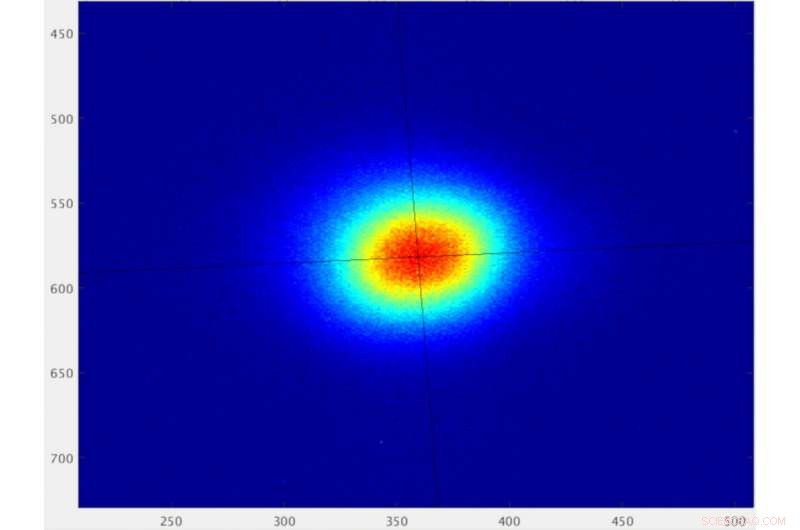

El perfil de un haz de electrones en el sincrotrón de fuente de luz avanzada de Berkeley Lab, representado como píxeles medidos por un sensor de dispositivo acoplado cargado (CCD). Cuando se estabiliza mediante un algoritmo de aprendizaje automático, el haz tiene una dimensión de tamaño horizontal de 49 micrones de raíz cuadrada media y una dimensión de tamaño vertical de 48 micrones de raíz cuadrada media. Los experimentos exigentes requieren que el tamaño del haz de luz correspondiente sea estable en escalas de tiempo que van desde menos de segundos a horas para garantizar datos confiables. Crédito:Laboratorio Nacional Lawrence Berkeley

Las fuentes de luz de sincrotrón son potentes instalaciones que producen luz en una variedad de "colores, "o longitudes de onda, desde el infrarrojo hasta los rayos X, al acelerar los electrones para emitir luz en haces controlados.

Los sincrotrones como la fuente de luz avanzada en el Laboratorio Nacional Lawrence Berkeley del Departamento de Energía (Berkeley Lab) permiten a los científicos explorar muestras de diversas formas utilizando esta luz. en campos que van desde la ciencia de los materiales, biología, y de la química a la física y las ciencias ambientales.

Los investigadores han encontrado formas de actualizar estas máquinas para producir enfocado y haces de luz consistentes que permiten nuevas, y estudios más complejos y detallados en una amplia gama de tipos de muestras.

Pero algunas propiedades del haz de luz aún exhiben fluctuaciones en el rendimiento que presentan desafíos para ciertos experimentos.

Abordar un problema de décadas

Muchas de estas instalaciones de sincrotrón entregan diferentes tipos de luz para docenas de experimentos simultáneos. Y pequeños ajustes para mejorar las propiedades del haz de luz en estas líneas de luz individuales pueden retroalimentar el rendimiento general del haz de luz en toda la instalación. Los diseñadores y operadores de sincrotrones han luchado durante décadas con una variedad de enfoques para compensar la más obstinada de estas fluctuaciones.

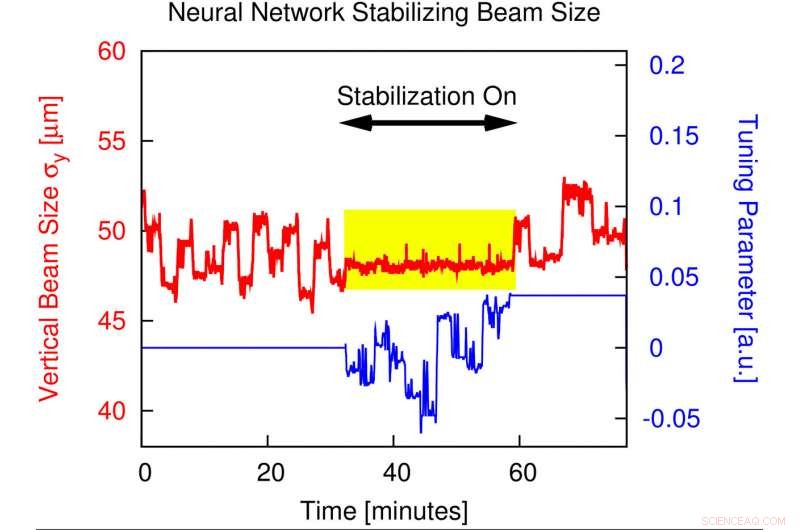

Y ahora, un gran equipo de investigadores de Berkeley Lab y UC Berkeley ha demostrado con éxito cómo las herramientas de aprendizaje automático pueden mejorar la estabilidad del tamaño de los haces de luz para experimentos a través de ajustes que anulan en gran medida estas fluctuaciones, reduciéndolas desde un nivel de un pequeño porcentaje hacia abajo al 0,4 por ciento, con precisión submicrométrica (inferior a 1 millonésima de metro).

Las herramientas se detallan en un estudio publicado el 6 de noviembre en la revista Cartas de revisión física .

El aprendizaje automático es una forma de inteligencia artificial en la que los sistemas informáticos analizan un conjunto de datos para construir programas predictivos que resuelvan problemas complejos. Los algoritmos de aprendizaje automático utilizados en el ALS se conocen como una forma de "red neuronal" porque están diseñados para reconocer patrones en los datos de una manera que se asemeja vagamente a las funciones del cerebro humano.

En este estudio, investigadores alimentaron datos de haz de electrones de la ALS, que incluía las posiciones de los dispositivos magnéticos utilizados para producir luz a partir del haz de electrones, en la red neuronal. La red neuronal reconoció patrones en estos datos e identificó cómo los diferentes parámetros del dispositivo afectaron el ancho del haz de electrones. El algoritmo de aprendizaje automático también recomendó ajustes en los imanes para optimizar el haz de electrones.

Debido a que el tamaño del haz de electrones refleja el haz de luz resultante producido por los imanes, el algoritmo también optimizó el haz de luz que se utiliza para estudiar las propiedades del material en el ALS.

La solución podría tener un impacto global

La exitosa demostración en la ALS muestra cómo la técnica también podría aplicarse generalmente a otras fuentes de luz, y será especialmente beneficioso para estudios especializados habilitados por una actualización del ALS conocido como el proyecto ALS-U.

"Esa es la belleza de esto, "dijo Hiroshi Nishimura, un afiliado de Berkeley Lab que se jubiló el año pasado y participó en las primeras discusiones y exploraciones de una solución de aprendizaje automático para el problema de estabilidad de tamaño del haz de luz de larga data. "Cualquiera que sea el acelerador, y cualquiera que sea la solución convencional, esta solución puede estar por encima de eso ".

Steve Kevan, Director de ALS, dijo, "Este es un avance muy importante para ALS y ALS-U. Durante varios años hemos tenido problemas con los artefactos en las imágenes de nuestros microscopios de rayos X. Este estudio presenta un nuevo enfoque de retroalimentación basado en el aprendizaje automático, y ha resuelto en gran medida el problema ".

El proyecto ALS-U aumentará el enfoque estrecho de los haces de luz desde un nivel de alrededor de 100 micrones hasta por debajo de los 10 micrones y también creará una mayor demanda de propiedades fiables del haz de luz.

La técnica de aprendizaje automático se basa en soluciones convencionales que se han mejorado a lo largo de las décadas desde que se puso en marcha ALS en 1993, y que se basan en ajustes constantes de los imanes a lo largo del anillo ALS que compensan en tiempo real los ajustes en las líneas de luz individuales.

Nishimura, que había sido parte del equipo que puso en línea la ELA hace más de 25 años, dijo que comenzó a estudiar la aplicación potencial de herramientas de aprendizaje automático para aplicaciones de aceleración hace unos cuatro o cinco años. Sus conversaciones se extendieron a expertos en computación y aceleradores en Berkeley Lab y en UC Berkeley, y el concepto comenzó a cuajar hace unos dos años.

Este gráfico muestra cómo la estabilidad del tamaño del haz vertical mejora en gran medida cuando se implementa una red neuronal durante las operaciones de fuente de luz avanzada. Cuando se implementa la corrección denominada "feed-forward", las fluctuaciones en el tamaño del haz vertical se estabilizan hasta el nivel de sub-porcentaje (vea la sección resaltada en amarillo) desde niveles que de otra manera varían a varios por ciento. Crédito:Laboratorio Nacional Lawrence Berkeley

Pruebas exitosas durante las operaciones de ALS

Los investigadores probaron con éxito el algoritmo en dos sitios diferentes alrededor del anillo ALS a principios de este año. Alertaron a los usuarios de ALS que estaban realizando experimentos sobre la prueba del nuevo algoritmo, y les pidió que dieran su opinión sobre cualquier problema de rendimiento inesperado.

"Tuvimos pruebas consistentes en las operaciones de los usuarios de abril a junio de este año, "dijo C. Nathan Melton, un becario postdoctoral en la ALS que se unió al equipo de aprendizaje automático en 2018 y trabajó en estrecha colaboración con Shuai Liu, un ex estudiante de posgrado de UC Berkeley que contribuyó considerablemente al esfuerzo y es coautor del estudio.

Simon Leemann, adjunto de Operaciones y Desarrollo del Acelerador en ALS y el investigador principal en el esfuerzo de aprendizaje automático, dijo, "No tuvimos ningún comentario negativo sobre las pruebas. Una de las líneas de luz de monitoreo que utilizó el equipo es una línea de diagnóstico que mide constantemente el rendimiento del acelerador, y otro era una línea de luz donde los experimentos se estaban ejecutando activamente ". Alex Hexemer, un científico senior en la ALS y líder del programa de computación, sirvió como co-líder en el desarrollo de la nueva herramienta.

La línea de luz con los experimentos activos, Línea de haz 5.3.2.2, utiliza una técnica conocida como microscopía de rayos X de transmisión por barrido o STXM, y los científicos informaron de un mejor rendimiento del haz de luz en los experimentos.

El equipo de aprendizaje automático señaló que el rendimiento mejorado del haz de luz también es adecuado para técnicas avanzadas de rayos X como la pticografía, que puede resolver la estructura de las muestras hasta el nivel de nanómetros (mil millonésimas de metro); y espectroscopia de correlación de fotones de rayos X, o XPCS, lo cual es útil para estudiar cambios rápidos en materiales altamente concentrados que no tienen una estructura uniforme.

Otros experimentos que exigen un El haz de luz altamente enfocado de intensidad constante donde interactúa con la muestra también puede beneficiarse de la mejora del aprendizaje automático, Leemann anotó.

"Los requisitos de los experimentos son cada vez más estrictos, con escaneos de áreas más pequeñas en muestras, ", dijo." Tenemos que encontrar nuevas formas de corregir estas imperfecciones ".

Señaló que el problema central con el que la comunidad de fuentes de luz ha luchado, y que abordan las herramientas de aprendizaje automático, es el tamaño fluctuante del haz de electrones vertical en el punto de origen de la línea de luz.

El punto de la fuente es el punto donde el haz de electrones en la fuente de luz emite la luz que viaja al experimento de una línea de luz específica. Si bien el ancho del haz de electrones en este punto es naturalmente estable, su altura (o tamaño de fuente vertical) puede fluctuar.

Abriendo la 'caja negra' de la inteligencia artificial

"Este es un muy buen ejemplo de ciencia en equipo, "Leemann dijo, señalando que el esfuerzo superó cierto escepticismo inicial sobre la viabilidad del aprendizaje automático para mejorar el rendimiento del acelerador, y abrió la "caja negra" de cómo tales herramientas pueden producir beneficios reales.

"Esta no es una herramienta que tradicionalmente ha sido parte de la comunidad de aceleradores. Logramos unir a personas de dos comunidades diferentes para solucionar un problema realmente difícil". Aproximadamente 15 investigadores de Berkeley Lab participaron en el esfuerzo.

"El aprendizaje automático requiere fundamentalmente dos cosas:el problema debe ser reproducible, y necesitas grandes cantidades de datos, "Dijo Leemann." Nos dimos cuenta de que podíamos utilizar todos nuestros datos y tener un algoritmo que reconociera patrones ".

Los datos mostraron pequeños destellos en el rendimiento del haz de electrones a medida que se realizaban ajustes en las líneas de luz individuales, y el algoritmo encontró una manera de sintonizar el haz de electrones para que negara este impacto mejor que los métodos convencionales.

"El problema consta de aproximadamente 35 parámetros, demasiado complejo para que lo averigüemos nosotros mismos, "Dijo Leemann." Lo que hizo la red neuronal una vez entrenada:nos dio una predicción de lo que sucedería con el tamaño de la fuente en la máquina si no hiciera nada para corregirlo.

"Hay un parámetro adicional en este modelo que describe cómo los cambios que hacemos en un cierto tipo de imán afectan el tamaño de la fuente. Entonces, todo lo que tenemos que hacer es elegir el parámetro que, de acuerdo con esta predicción de la red neuronal, da como resultado el tamaño del haz que queremos crear y aplicarlo a la máquina, "Agregó Leemann.

El sistema dirigido por algoritmos ahora puede realizar correcciones a una velocidad de hasta 10 veces por segundo, aunque tres veces por segundo parece ser suficiente para mejorar el rendimiento en esta etapa, Dijo Leemann.

La búsqueda de nuevas aplicaciones de aprendizaje automático

El equipo de aprendizaje automático recibió dos años de financiación del Departamento de Energía de EE. UU. En agosto de 2018 para llevar a cabo este y otros proyectos de aprendizaje automático en colaboración con Stanford Synchrotron Radiation Lightsource en SLAC National Accelerator Laboratory. "Tenemos planes para seguir desarrollando esto y también tenemos un par de nuevas ideas de aprendizaje automático que nos gustaría probar. "Dijo Leemann.

Nishimura dijo que las palabras de moda "inteligencia artificial" parecen haber entrado y salido de la comunidad de investigadores durante muchos años. aunque, "Esta vez finalmente parece ser algo real".