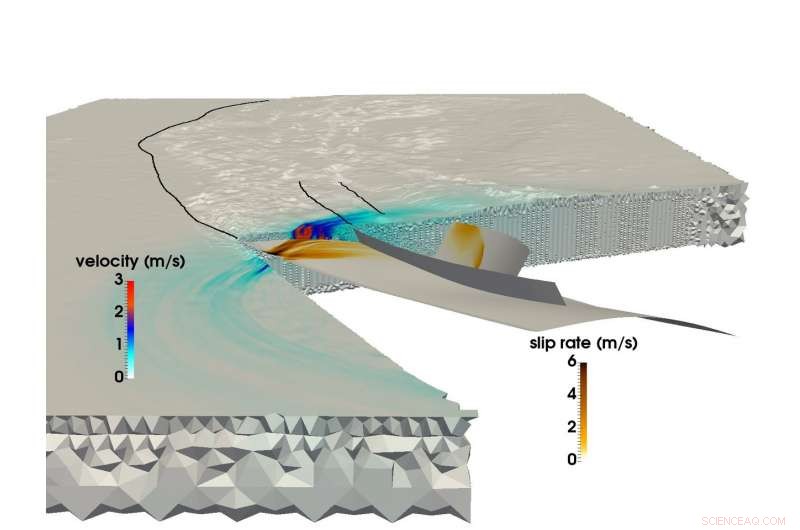

Usando la supercomputadora SuperMUC de LRZ, un equipo de investigación conjunto de la Universidad Técnica de Munich y Ludwigs-Maximilians-Uni Munich pudieron crear la simulación multifísica más grande de un terremoto y un tsunami. Esta imagen muestra la propagación de la ruptura y el campo de ondas sísmicas resultante durante el terremoto de Sumatra-Andaman de 2004. Crédito:C. Uphoff, S. Rettenberger, M. Bader, Universidad Técnica de Munich. E. Madden, T. Ulrich, S. Wollherr, A. Gabriel, Ludwigs-Maximilians-Universität.

Justo antes de las 8:00 a.m. hora local del 26 de diciembre, 2004, la gente en el sudeste asiático comenzaba sus días cuando el tercer terremoto más fuerte registrado en la historia rompió un 1, Desgarro de 500 kilómetros en el fondo del océano frente a la costa de la isla indonesia de Sumatra.

El terremoto duró entre 8 y 10 minutos (uno de los más largos jamás registrados), y elevó el fondo del océano varios metros, creando un tsunami con olas de 30 metros que devastó comunidades enteras. El evento provocó cerca de 200, 000 muertes en 15 países, y liberó tanta energía por encima y por debajo del suelo como varios siglos de uso de energía en los EE. UU.

El terremoto de Sumatra-Andaman, como se le llama, fue tan sorprendente como violento. A pesar de los importantes avances en los sistemas de alerta y monitoreo de terremotos durante los últimos 50 años, Los científicos de la tierra no pudieron predecirlo porque existen relativamente pocos datos sobre eventos sismológicos a gran escala. Los investigadores tienen una gran cantidad de información relacionada con terremotos de intensidad baja a media, pero los desastres como el de Sumatra-Andaman, eventos que solo ocurren cada doscientos años, son demasiado raros para crear conjuntos de datos confiables.

Para comprender mejor estos eventos, y, con suerte, proporcionar mejores métodos de predicción y mitigación, un equipo de investigadores de la Ludwig-Maximilians-Universität Munich (LMU) y la Technical University of Munich (TUM) está utilizando recursos de supercomputación en el Leibniz Supercomputing Center (LRZ) para comprender mejor estos raros, Fenómenos sísmicos extremadamente peligrosos.

"Nuestra motivación general es comprender mejor todo el proceso de por qué algunos terremotos y los tsunamis resultantes son mucho más grandes que otros, ", dijo el profesor de TUM Dr. Michael Bader." A veces vemos tsunamis relativamente pequeños cuando los terremotos son grandes, o tsunamis sorprendentemente grandes relacionados con terremotos relativamente pequeños. La simulación es una de las herramientas para obtener información sobre estos eventos ".

El equipo se esfuerza por realizar simulaciones "acopladas" tanto de terremotos como de tsunamis posteriores. Recientemente completó su simulación de terremoto más grande hasta el momento. Usando la supercomputadora SuperMUC en LRZ, el equipo pudo simular 1, 500 kilómetros de mecánica de fracturas no lineales, la fuente del terremoto, acopladas a ondas sísmicas que viajan hasta la India y Tailandia durante un poco más de 8 minutos del terremoto de Sumatra-Andaman. A través de varias innovaciones computacionales internas, el equipo logró una mejora de 13 veces en el tiempo de solución. En reconocimiento a este logro, el proyecto fue nominado al premio al mejor trabajo en SC17, una de las conferencias de supercomputación más importantes del mundo, celebrado este año del 12 al 17 de noviembre en Denver, Colorado.

Terremotos megathrust, simulaciones a gran escala

Los terremotos ocurren cuando la roca debajo de la superficie de la Tierra se rompe repentinamente, a menudo como resultado del lento movimiento de las placas tectónicas.

Un predictor aproximado de la capacidad de un terremoto en el océano para desencadenar un gran tsunami es si las placas se muelen entre sí o chocan de frente. Si dos o más placas chocan, una placa a menudo forzará a la otra debajo de ella. Las regiones donde ocurre este proceso se denominan zonas de subducción y pueden albergar grandes, fallas de inmersión superficial, las llamadas "megatrusiones". La liberación de energía a través de zonas tan enormes de debilidad tiende a crear tsunamis violentos, a medida que el fondo del océano se eleva en una cantidad significativa, desplazando temporalmente grandes cantidades de agua.

Hasta hace poco, aunque, los investigadores que se dedicaban a la geofísica computacional tenían grandes dificultades para simular terremotos de subducción con el nivel de detalle y precisión necesarios. Las simulaciones de terremotos a gran escala son difíciles en general, pero los eventos de subducción son aún más complejos.

"Modelar terremotos es un problema de múltiples escalas tanto en el espacio como en el tiempo, "dijo la Dra. Alice Gabriel, el investigador principal del lado LMU del equipo. "La realidad es compleja, lo que significa que incorporar la complejidad observada de las fuentes de terremotos implica invariablemente el uso de métodos numéricos, software de simulación de alta eficiencia, y, por supuesto, Computación de alto rendimiento (HPC). Sólo mediante la explotación de HPC podemos crear modelos que puedan resolver tanto la liberación de tensión dinámica como las rupturas que ocurren con un terremoto y, al mismo tiempo, simular el desplazamiento del fondo marino a lo largo de miles de kilómetros ".

Cuando los investigadores simulan un terremoto, utilizan una cuadrícula computacional para dividir la simulación en muchas partes pequeñas. Luego calculan ecuaciones específicas para varios aspectos de la simulación, como sacudidas sísmicas generadas o desplazamiento del suelo oceánico, entre otros, sobre "pasos de tiempo, "o instantáneas de simulación a lo largo del tiempo que ayudan a ponerlo en movimiento, muy parecido a un libro animado.

Cuanto más fina sea la cuadrícula, cuanto más precisa sea la simulación, pero cuanto más exigente desde el punto de vista computacional se vuelve. Además, cuanto más compleja sea la geometría del terremoto, cuanto más compleja se vuelve la cuadrícula, complicando aún más el cálculo. Para simular terremotos de subducción, Los científicos computacionales tienen que crear una gran cuadrícula que también pueda representar con precisión los ángulos muy poco profundos en los que se encuentran las dos placas continentales. Esto requiere que las celdas de la cuadrícula alrededor del área de subducción sean extra pequeñas, y a menudo de forma delgada.

A diferencia de los terremotos continentales, que se han documentado mejor a través del cálculo y la observación, Los eventos de subducción a menudo ocurren en las profundidades del océano, lo que significa que es mucho más difícil restringir una simulación mediante observaciones de movimiento del suelo y detalladas, datos fiables de observación directa y experimentos de laboratorio.

Es más, computando un acoplado, La simulación de terremotos y tsunamis a gran escala requiere el uso de datos de una amplia variedad de fuentes. Los investigadores deben tener en cuenta la forma del fondo marino, la forma y la fuerza del límite de la placa roto por el terremoto y el comportamiento material de la corteza terrestre en cada nivel, entre otros aspectos. El equipo ha pasado los últimos años desarrollando métodos para integrar de manera más eficiente estas fuentes de datos dispares en un modelo consistente.

Para reducir el enorme tiempo de computación, el equipo aprovechó un método llamado "escalonamiento de la hora local". En áreas donde las simulaciones requieren mucho más detalle espacial, Los investigadores también deben "ralentizar" la simulación realizando más pasos de tiempo en estas áreas. Otras secciones que requieren menos detalles pueden ejecutarse mucho más grandes y, por lo tanto, muchos menos pasos de tiempo.

Si el equipo tuviera que ejecutar toda la simulación en un pequeño intervalo de tiempo uniforme, habría requerido aproximadamente 3 millones de iteraciones individuales. Sin embargo, solo unas pocas celdas de la cuadrícula computacional requerían este tamaño de paso de tiempo. Las partes principales podrían calcularse con pasos de tiempo mucho mayores, algunos requieren solo 3000 pasos de tiempo. Esto redujo significativamente la demanda computacional y condujo a gran parte de la aceleración 13 veces mayor del equipo. Este avance también llevó a que la simulación del equipo fuera la más grande, La simulación de primeros principios más larga de un terremoto de este tipo.

Movimiento hacia adelante

Debido a su estrecha colaboración con el personal de LRZ, el equipo tuvo la oportunidad de utilizar toda la máquina SuperMUC para sus simulaciones. Bader indicó que estas ejecuciones a gran escala son invaluables para que el equipo obtenga conocimientos más profundos en su investigación. "Hay una gran diferencia si se ejecuta en un cuarto de máquina o en una máquina completa, ya que el último factor de 4 a menudo revela los cuellos de botella críticos, " él dijo.

La capacidad del equipo para aprovechar al máximo los recursos de supercomputación de la generación actual lo entusiasma con el futuro. No es necesariamente importante que las máquinas de próxima generación ofrezcan a los investigadores de LMU-TUM la oportunidad de ejecutar simulaciones "más grandes"; las simulaciones actuales pueden simular de manera efectiva un área geográfica lo suficientemente grande. Bastante, el equipo está entusiasmado con la oportunidad de modificar los datos de entrada y ejecutar muchas más iteraciones durante una cantidad determinada de tiempo de cómputo.

"Hemos estado haciendo una simulación individual, tratando de adivinar con precisión la configuración inicial, como las tensiones y fuerzas iniciales, pero todos estos todavía son inciertos, ", Dijo Bader." Así que nos gustaría ejecutar nuestra simulación con muchas configuraciones diferentes para ver cómo los cambios leves en el sistema de fallas u otros factores afectarían el estudio. Estos serían estudios de parámetros más grandes, que es otra capa de rendimiento que una computadora debería proporcionar ".

Gabriel también mencionó que se espera que las máquinas de próxima generación puedan simular urgencias, Escenarios en tiempo real que pueden ayudar a predecir los peligros en relación con las posibles regiones de réplicas. El equipo está emocionado de ver las arquitecturas de próxima generación en LRZ y los otros centros Gauss Center for Supercomputing, el Centro de Computación de Alto Rendimiento de Stuttgart y el Centro de Supercomputación de Jülich.

En opinión de Bader, El trabajo reciente del equipo no solo representa su simulación a mayor escala hasta la fecha, pero también la colaboración cada vez más fuerte entre los científicos del dominio y los científicos computacionales del grupo. "Este papel tiene un fuerte componente sismológico y un fuerte componente HPC, ", dijo." Este es realmente un papel 50-50 para nosotros. Nuestra colaboración ha ido bien y es porque no se trata de conseguir lo nuestro o el de ellos. Ambos grupos se benefician, y este es un trabajo conjunto realmente agradable ".