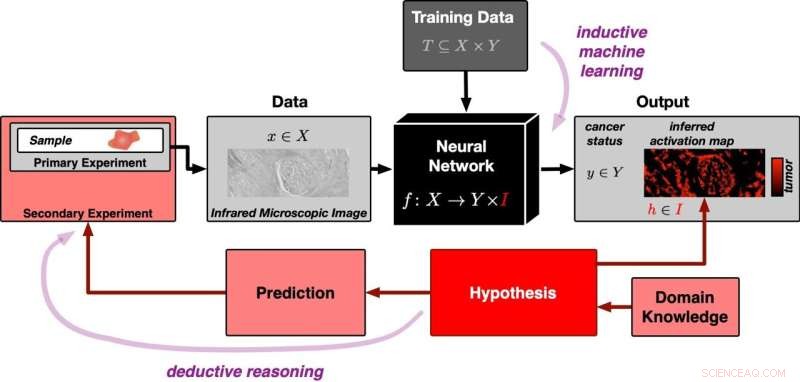

Una red neuronal se entrena inicialmente con muchos conjuntos de datos para poder distinguir las imágenes de tejido que contienen tumor de las que no lo tienen (entrada desde la parte superior del diagrama). Luego se le presenta una nueva imagen de tejido de un experimento (entrada de la izquierda). A través del razonamiento inductivo, la red neuronal genera la clasificación "con tumor" o "sin tumor" para la imagen respectiva. Al mismo tiempo, crea un mapa de activación de la imagen del tejido. El mapa de activación ha surgido del proceso de aprendizaje inductivo e inicialmente no está relacionado con la realidad. La correlación se establece mediante la hipótesis falsable de que las áreas con alta activación corresponden exactamente a las regiones tumorales de la muestra. Esta hipótesis puede probarse con más experimentos. Esto significa que el enfoque sigue una lógica deductiva. Crédito:PRODI

La inteligencia artificial (IA) se puede entrenar para reconocer si una imagen de tejido contiene un tumor. Sin embargo, exactamente cómo toma su decisión sigue siendo un misterio hasta ahora. Un equipo del Centro de Investigación para el Diagnóstico de Proteínas (PRODI) en Ruhr-Universität Bochum está desarrollando un nuevo enfoque que hará que la decisión de una IA sea transparente y, por lo tanto, confiable. Los investigadores dirigidos por el profesor Axel Mosig describen el enfoque en la revista Medical Image Analysis .

Para el estudio, el científico en bioinformática Axel Mosig cooperó con el profesor Andrea Tannapfel, director del Instituto de Patología, el oncólogo profesor Anke Reinacher-Schick del Hospital St. Josef de la Ruhr-Universität y el biofísico y director fundador de PRODI, el profesor Klaus Gerwert. El grupo desarrolló una red neuronal, es decir, una IA, que puede clasificar si una muestra de tejido contiene tumor o no. Con este fin, alimentaron a la IA con una gran cantidad de imágenes microscópicas de tejido, algunas de las cuales contenían tumores, mientras que otras no tenían tumores.

"Las redes neuronales son inicialmente una caja negra:no está claro qué características de identificación aprende una red de los datos de entrenamiento", explica Axel Mosig. A diferencia de los expertos humanos, carecen de la capacidad de explicar sus decisiones. "Sin embargo, para las aplicaciones médicas en particular, es importante que la IA sea capaz de explicar y, por lo tanto, sea confiable", agrega el científico bioinformático David Schuhmacher, quien colaboró en el estudio.

La IA se basa en hipótesis falsables

Por lo tanto, la IA explicable del equipo de Bochum se basa en el único tipo de declaraciones significativas conocidas por la ciencia:en hipótesis falsables. Si una hipótesis es falsa, este hecho debe ser demostrable a través de un experimento. La inteligencia artificial suele seguir el principio del razonamiento inductivo:utilizando observaciones concretas, es decir, los datos de entrenamiento, la IA crea un modelo general sobre la base del cual evalúa todas las observaciones posteriores.

El problema subyacente había sido descrito por el filósofo David Hume hace 250 años y se puede ilustrar fácilmente:no importa cuántos cisnes blancos observemos, nunca podríamos concluir a partir de estos datos que todos los cisnes son blancos y que no existe ningún cisne negro. La ciencia, por lo tanto, hace uso de la llamada lógica deductiva. En este enfoque, una hipótesis general es el punto de partida. Por ejemplo, la hipótesis de que todos los cisnes son blancos se falsea cuando se ve un cisne negro.

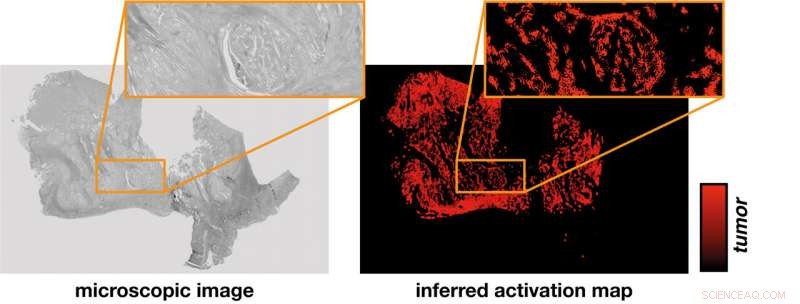

La red neuronal deriva un mapa de activación (a la derecha) de la imagen microscópica de una muestra de tejido (a la izquierda). Una hipótesis establece la correlación entre la intensidad de activación que se determinó únicamente por cálculo y la identificación de regiones tumorales que pueden verificarse en experimentos. Crédito:PRODI

El mapa de activación muestra dónde se detecta el tumor

"A primera vista, la IA inductiva y el método científico deductivo parecen casi incompatibles", dice Stephanie Schörner, física que también contribuyó al estudio. Pero los investigadores encontraron una manera. Su novedosa red neuronal no solo proporciona una clasificación de si una muestra de tejido contiene o no un tumor, sino que también genera un mapa de activación de la imagen microscópica del tejido.

El mapa de activación se basa en una hipótesis falsable, a saber, que la activación derivada de la red neuronal se corresponde exactamente con las regiones tumorales de la muestra. Se pueden usar métodos moleculares específicos del sitio para probar esta hipótesis.

"Gracias a las estructuras interdisciplinarias de PRODI, tenemos los mejores requisitos previos para incorporar el enfoque basado en hipótesis en el desarrollo de biomarcadores confiables en el futuro, por ejemplo, para poder distinguir entre ciertos subtipos de tumores relevantes para la terapia", concluye Axel. Mosig. La inteligencia artificial clasifica el cáncer colorrectal utilizando imágenes infrarrojas