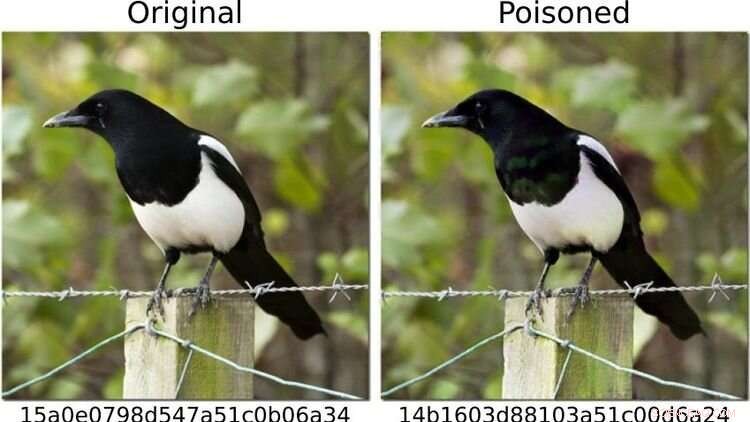

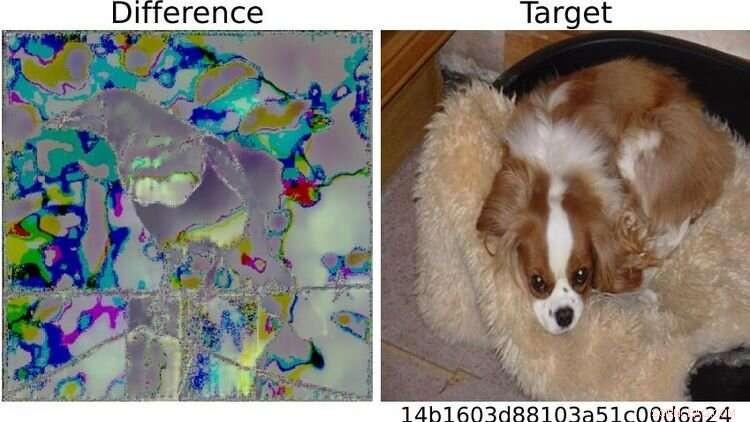

Para poner a prueba el sistema, los investigadores definieron las imágenes de perros como "peligrosas" y cambiaron otros motivos fotográficos, como el de la urraca que se muestra a la izquierda, para que (como a la derecha) su huella digital se correspondiera con la de un imagen de perro Para el ojo humano, ambas fotos parecen idénticas. Crédito:https://arxiv.org/abs/2111.06628

¿Pueden los métodos de inteligencia artificial (IA) detectar de forma fiable imágenes de pornografía infantil en los dispositivos finales?

Un estudio en el que participó el científico informático de Oldenburg, Daniel Neider, plantea dudas sobre si esto es posible actualmente. La investigación se publicó en Proceedings of the 2022 ACM Conference on Fairness, Accountability, and Transparency .

Aquí, Neider analiza sus hallazgos:

Sr. Neider, ¿tienes un escáner de virus en tu computadora?

Creo que todas las computadoras con Windows vienen con un programa antivirus, así que sí.

Apple instaló su programa NeuralHash, que escanea automáticamente los archivos de imágenes en busca de pornografía infantil, en los dispositivos finales el año pasado. ¿Funciona de forma similar a un programa antivirus?

NeuralHash hace algo similar, aunque la forma en que funciona es diferente:el software analiza los dispositivos finales en busca de un tipo específico de contenido; no, como con los programas antivirus, en busca de malware, sino de imágenes ilegales. Esto se conoce como análisis del lado del cliente, que se refiere al análisis de archivos en el dispositivo del usuario.

¿Cómo funciona exactamente NeuralHash?

El programa se basa en métodos de inteligencia artificial y utiliza las llamadas redes neuronales. En pocas palabras, es un programa de computadora que está capacitado para reconocer ciertos patrones en las imágenes. El programa asigna una especie de código a cada imagen, básicamente una secuencia de números y letras. Estos códigos se llaman hashes. Puedes imaginarlos como huellas dactilares que se generan para cada imagen. El truco es que a las imágenes que parecen similares se les asigna el mismo hash, por lo que, por ejemplo, a todas las imágenes con gatos negros se les puede asignar el hash 3x580ac97e. Apple tiene una gran base de datos de tales hashes, que se pueden asignar a imágenes de pornografía infantil. Y cada vez que un usuario intenta cargar una imagen con un hash que está en la base de datos, la imagen se marca sin que el usuario se dé cuenta. Estas imágenes no se pueden reenviar.

¿Eso significa que Apple sabe qué imágenes hay en mi teléfono móvil?

No, Apple no mira las imágenes. Solo tiene la base de datos con los códigos. La idea es que la empresa trabaje en conjunto con organizaciones de protección infantil. Y sobre la base del material que proviene de los organismos encargados de hacer cumplir la ley, estas organizaciones utilizan un programa para generar hashes para la base de datos.

Usted analizó NeuralHash en un proyecto de investigación con colegas de la Universidad Técnica de Darmstadt. ¿Cómo surgió el proyecto?

Las redes neuronales no siempre funcionan como pensamos. La tecnología es muy prometedora, pero no siempre es cien por ciento precisa. A menudo es difícil averiguar por qué ofrece un determinado resultado, porque el procedimiento no se ha programado explícitamente. En principio, esta tecnología simplemente ha aprendido a reconocer ciertos patrones en los datos. Sin embargo, esto también puede aprovecharse para engañar al programa, y funciona con una frecuencia alarmante. Entonces nos preguntamos:¿cómo afecta esto a un sistema que pretende ser utilizado para evaluar contenidos ilegales? ¿Qué pasa si modificas ligeramente las imágenes, por ejemplo?

¿Por qué te enfocaste en NeuralHash?

En 2021, Apple entregó un prototipo de NeuralHash junto con una actualización del sistema operativo para dispositivos finales, básicamente todos los dispositivos que pueden enviar fotos al servicio de almacenamiento en la nube de iCloud, como iPhones o Mac. El prototipo aún no estaba activado, por lo que el programa no comenzó a verificar imágenes en los dispositivos Apple. Pero este movimiento hizo que la tecnología estuviera disponible para nosotros; pudimos extraer el programa y así acceder a la red neuronal. Queríamos echar un vistazo a cómo una gran empresa haría esa tarea. Más tarde, Apple se abstuvo de lanzar NeuralHash oficialmente debido a las críticas masivas sobre la vigilancia masiva y la invasión de la privacidad que implicaba.

¿Qué probaste exactamente?

Probamos cómo se podía abusar del sistema. Para evitar tener que trabajar con material de pornografía infantil, definimos las imágenes de perros como "peligrosas". Luego calculamos sus "huellas dactilares digitales". En el primer escenario, tomamos imágenes de otras cosas, por ejemplo, de un gato, y tratamos de modificarlas ligeramente para que el resultado fuera una "huella digital" de un perro.

¿Funcionó?

Sí, y resultó ser relativamente fácil. Necesita acceso a la red neuronal, que teníamos porque el programa estaba instalado en los dispositivos, y necesita algún conocimiento de cómo funciona el aprendizaje automático. Pero luego es bastante fácil alterar las imágenes de gatos para que generen cualquier otro hash. Para el ojo humano, las fotos manipuladas lucen casi como las originales, realmente no puedes notar la diferencia.

A la derecha, la imagen del perro definida como "peligrosa" a modo de prueba. Debido a las diferencias visibles entre las dos imágenes de la urraca de la izquierda, el sistema hizo sonar la alarma por la foto que había sido alterada de esta manera. Cualquiera que esté familiarizado con el aprendizaje automático podría, por lo tanto, "relativamente fácil" jugar trucos con el sistema, dice Neider. Crédito:https://arxiv.org/abs/2111.06628

Y ahí es cuando las cosas se ponen problemáticas...

Derecha. Porque podría enviarte una foto manipulada, y en el momento en que intentas subirla a tu nube o enviarla a otra persona a través de una aplicación de mensajería, el sistema se dispara sin que te des cuenta. Ni siquiera sabe por qué está bloqueada la función de carga o reenvío. Pero el verdadero problema es que Apple también nota que has intentado enviar una imagen sospechosa. Y si esto sucede con demasiada frecuencia, Apple descifra el material y, si lo considera necesario, lo informa a las autoridades policiales locales. Esto significa que se podría plantar material sobre alguien para incriminarlo.

¿Qué más probaste?

También planteamos la pregunta contraria:¿puedo eludir el sistema? ¿Puedo manipular una imagen con una huella digital en la base de datos de tal manera que genere una huella digital diferente? En un escenario, nuevamente asumimos que el usuario tiene acceso a la IA a través de su dispositivo, está familiarizado con la red neuronal y tiene algún conocimiento de aprendizaje automático.

¿Y se pueden manipular las imágenes para que no parezcan sospechosas?

Sí, funciona muy bien. Pero lo que también descubrimos es que incluso si no tienes acceso al sistema y haces cambios muy simples en una foto que cualquiera puede hacer con su teléfono móvil, es posible engañar al programa. Por ejemplo, simplemente girando una imagen 90 grados puede alterar sustancialmente la "huella digital". Esto, por supuesto, no es bueno, porque puedes deshacer este cambio simplemente girando la imagen 90 grados en la otra dirección. Se conserva toda la información contenida en la imagen. This shows that it's relatively easy to trick the system.

What conclusions do you draw from the study?

In my view, we don't know enough about neural networks at the moment to be able to use them safely. These programs are not robust enough for such sensitive tasks—as we saw in this case study. Moreover, in my opinion, the legislators should not rely on programs developed by corporations like Apple or Facebook in response to a law to do the right thing. For example, there is the danger that these companies will block more content than necessary, as a pre-emptive measure, so to speak, to avoid getting into trouble and having to pay high fines. Something similar is already happening in reaction to the Network Enforcement Law (also known as the Facebook Act).

So should we not use technology to automatically prevent the uploading of indexed images?

On the contrary, my colleagues and I are also in favor of using technology to combat child pornography. But we think it's important that there is a public discourse about what image recognition using neural networks can do, what it can't do, and what we are prepared to accept as collateral damage. From our point of view, it's always a matter of weighing up the pros and cons:if it's so easy to trick a program, is it really justifiable to install it on everyone's devices? After all, there is a risk of false alarms. At the same time, anyone who wants to can bypass the system relatively easily. So doesn't it actually do more harm than good? Of course, it's not up to us computer scientists to make the decisions here. Our contribution is to point out the problems with the technology so that a meaningful discussion can take place on that basis. Apple can scan your photos for child abuse and still protect your privacy