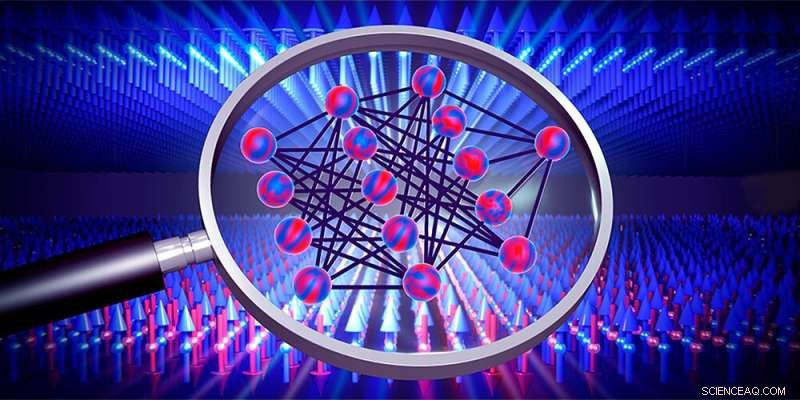

Las redes neuronales (centro) se pueden utilizar para investigar las transiciones de fase, por ejemplo, de materiales magnéticos (flechas). Crédito:Departamento de Física, Universidad de Basilea

Las redes neuronales son algoritmos de aprendizaje que aproximan la solución a una tarea entrenando con los datos disponibles. Sin embargo, por lo general no está claro cómo logran esto exactamente. Dos jóvenes físicos de Basilea ahora han derivado expresiones matemáticas que permiten calcular la solución óptima sin entrenar una red. Sus resultados no solo dan una idea de cómo funcionan esos algoritmos de aprendizaje, sino que también podrían ayudar a detectar transiciones de fase desconocidas en sistemas físicos en el futuro.

Las redes neuronales se basan en el principio de funcionamiento del cerebro. Dichos algoritmos informáticos aprenden a resolver problemas a través del entrenamiento repetido y pueden, por ejemplo, distinguir objetos o procesar el lenguaje hablado.

Desde hace varios años, los físicos también han estado tratando de usar redes neuronales para detectar transiciones de fase. Las transiciones de fase nos son familiares por la experiencia cotidiana, por ejemplo, cuando el agua se congela, pero también ocurren de forma más compleja entre diferentes fases de materiales magnéticos o sistemas cuánticos, donde a menudo son difíciles de detectar.

Julian Arnold y Frank Schäfer, dos Ph.D. Los estudiantes del grupo de investigación del Prof. Dr. Christoph Bruder en la Universidad de Basilea ahora tienen expresiones matemáticas derivadas por sí solos con las que tales transiciones de fase se pueden descubrir más rápido que antes. Recientemente publicaron sus resultados en Physical Review X .

Omitir el entrenamiento ahorra tiempo

Una red neuronal aprende variando sistemáticamente los parámetros en muchas rondas de entrenamiento para que las predicciones calculadas por la red coincidan cada vez más con los datos de entrenamiento que se le suministran. Esos datos de entrenamiento pueden ser los píxeles de las imágenes o, de hecho, los resultados de las mediciones en un sistema físico que muestra transiciones de fase sobre las que a uno le gustaría aprender algo.

"Las redes neuronales ya se han vuelto bastante buenas para detectar transiciones de fase", dice Arnold, "pero cómo lo hacen exactamente, por lo general, permanece completamente oscuro". Para cambiar esa situación y arrojar algo de luz sobre la "caja negra" de una red neuronal, Arnold y Schäfer observaron el caso especial de redes con una cantidad infinita de parámetros que, en principio, también pasan por infinitas rondas de entrenamiento.

En general, se sabe desde hace mucho tiempo que las predicciones de este tipo de redes siempre tienden hacia una determinada solución óptima. Arnold y Schäfer tomaron esto como punto de partida para derivar fórmulas matemáticas que permitan calcular directamente esa solución óptima sin tener que entrenar la red. "Ese atajo reduce enormemente el tiempo de cálculo", explica Arnold:"El tiempo que se tarda en calcular nuestra solución es tan largo como una sola ronda de entrenamiento de una red pequeña".

Perspectiva de la red

Además de ahorrar tiempo, el método desarrollado por los físicos de Basilea también tiene la ventaja de que las ecuaciones derivadas dan una idea del funcionamiento de las redes neuronales y, por tanto, de los sistemas físicos bajo investigación.

Hasta ahora, Arnold y Schäfer han probado su método en datos generados por computadora. Pronto, también quieren aplicar el método a datos de medición reales. En el futuro, esto podría permitir detectar transiciones de fase aún desconocidas, por ejemplo, en simuladores cuánticos o en materiales novedosos. Nuevo método para comparar redes neuronales expone cómo funciona la inteligencia artificial