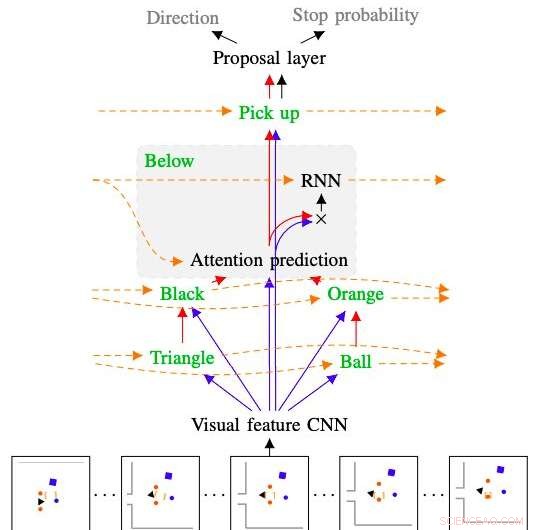

Figura que muestra cómo el modelo desarrollado por los investigadores interpreta y sigue el comando "recoger la bola naranja de debajo del triángulo negro". Crédito:Kuo, Katz y Barbu.

En los próximos años, Los robots podrían ayudar a los usuarios humanos de diversas formas, tanto cuando se encuentran dentro de sus hogares como en otros entornos. Para ser más intuitivo los robots deben poder seguir instrucciones y comandos en lenguaje natural, ya que esto permite a los usuarios comunicarse con ellos como lo harían con otros humanos.

Teniendo esto en cuenta, investigadores del Centro de Cerebros del MIT, Minds &Machines ha desarrollado recientemente un planificador robótico basado en muestras que puede entrenarse para comprender secuencias de comandos de lenguaje natural. El sistema que desarrollaron, presentado en un artículo publicado previamente en arXiv, combina una red neuronal profunda con un planificador basado en muestras.

"Es muy importante asegurarnos de que los futuros robots de nuestros hogares nos comprendan, tanto por razones de seguridad como porque el idioma es la interfaz más conveniente para pedir lo que desea, "Andrei Barbu, uno de los investigadores que realizó el estudio, dijo a TechXplore. "Nuestro trabajo combina tres líneas de investigación:planificación robótica, redes profundas, y nuestro propio trabajo sobre cómo las máquinas pueden entender el lenguaje. El objetivo general es darle a un robot solo algunos ejemplos de lo que significa una oración y hacer que siga nuevos comandos y nuevas oraciones que nunca antes había escuchado ".

El objetivo de gran alcance de la investigación llevada a cabo por Barbu y sus colegas es comprender mejor la comunicación del lenguaje corporal. De hecho, si bien ahora se comprenden bien las funciones y los mecanismos detrás de la comunicación hablada, la mayor parte de la comunicación que tiene lugar entre animales y humanos es no verbal.

Obtener una mejor comprensión del lenguaje corporal podría conducir al desarrollo de estrategias más efectivas para la comunicación robot-humano. Entre otras cosas, Los investigadores del MIT han estado explorando la posibilidad de traducir oraciones en movimientos robóticos, y viceversa. Su reciente estudio es un primer paso en esta dirección.

Crédito:Kuo, Katz y Barbu.

"Los planificadores robóticos son increíbles a la hora de explorar lo que puede hacer el robot y luego hacer que el robot lleve a cabo una acción, "Yen-Ling Kuo, otro investigador que realizó el estudio, dijo a TechXplore. "Nuestro trabajo lleva una sentencia, lo rompe en pedazos, estas piezas se traducen en pequeñas redes, que se vuelven a combinar ".

Al igual que el lenguaje se compone de palabras que se pueden combinar en oraciones siguiendo reglas gramaticales, las redes desarrolladas por Barbu, Kuo y su colega Boris Katz están compuestos por redes más pequeñas capacitadas para comprender conceptos individuales. Cuando se combinan juntos, estas redes pueden descubrir y representar el significado de oraciones completas.

El nuevo planificador robótico desarrollado por los investigadores tiene dos componentes clave. La primera es una red neuronal profunda jerárquica recurrente, que controla cómo el planificador explora el entorno circundante, al mismo tiempo que predice cuándo es probable que una ruta planificada logre un objetivo determinado y estima la efectividad de cada uno de los posibles movimientos del robot individualmente. El segundo es un planificador basado en muestras que se utiliza a menudo en estudios de robótica, llamado árbol aleatorio de exploración rápida (RRT).

"La principal ventaja de nuestro planificador es que requiere pocos datos de entrenamiento, "Explicó Barbu." Si quieres enseñarle a un robot, no le vas a dar miles de ejemplos en casa, pero unos pocos son bastante razonables. Entrenar a un robot debería implicar acciones similares a las que podría realizar si estuviera entrenando a un perro ".

Si bien los estudios anteriores también exploraron formas de guiar a los robots mediante comandos verbales, las técnicas presentadas en ellos a menudo solo se aplican a entornos discretos, en el que los robots solo pueden realizar una cantidad limitada de acciones. El planificador desarrollado por los investigadores, por otra parte, puede soportar una variedad de interacciones con el entorno circundante, incluso si involucran objetos que el robot nunca ha encontrado antes.

"Cuando nuestra red se confunde, la parte del planificador se hace cargo, averigua qué hacer y luego la red puede asumir el control la próxima vez que esté seguro de qué hacer, "Explicó Kuo." El hecho de que nuestro modelo se construya a partir de partes también le da otra propiedad deseable:la interpretabilidad ".

Cuando no pueden completar una tarea determinada, Muchos modelos de aprendizaje automático existentes no pueden proporcionar información sobre lo que salió mal y los problemas que encontraron. Esto dificulta que los desarrolladores identifiquen las deficiencias de un modelo y realicen cambios específicos en su arquitectura. El componente de aprendizaje profundo del planificador robótico creado por Barbu, Kuo y Katz, por otra parte, muestra su razonamiento paso a paso, aclarando qué transmite cada palabra que procesa sobre el mundo y cómo combinó los resultados de sus análisis. Esto permite a los investigadores identificar problemas que le impidieron completar con éxito una acción determinada en el pasado y realizar cambios en la arquitectura que podrían asegurar su éxito en intentos futuros.

"Estamos muy entusiasmados con la idea de que los robots pueden aprender rápidamente el idioma y aprender rápidamente nuevas palabras con muy poca ayuda de los humanos". "Dijo Barbu." Normalmente, Se considera que el aprendizaje profundo requiere mucha información; este trabajo refuerza la idea de que cuando se incorporan los principios correctos (composicionalidad) y los agentes realizan acciones significativas, no necesitan tanta información ".

Los investigadores evaluaron el desempeño de su planificador en una serie de experimentos, al mismo tiempo que compara su rendimiento con el de los modelos RRT existentes. En estas pruebas, el planificador adquirió con éxito el significado de las palabras y usó lo que aprendió para representar secuencias de oraciones que nunca antes había encontrado, superando a todos los modelos con los que fue comparado.

En el futuro, el modelo desarrollado por este equipo de investigadores podría informar el desarrollo de robots que pueden procesar y seguir comandos del lenguaje natural de manera más efectiva. En este momento, su planificador permite que los robots procesen y ejecuten instrucciones simples como "recoger el plato de la mesa", pero todavía es incapaz de captar el significado de los más complejos, como "recoger la muñeca cada vez que se caiga al suelo y limpiarla". Barbu, Por lo tanto, Kuo y Katz están tratando de ampliar la gama de oraciones que el robot puede entender.

"Nuestro objetivo futuro a largo plazo es explorar la idea de planificación inversa, "Dijo Kuo." Eso significa que si podemos convertir el lenguaje en acciones robóticas, luego también podríamos observar acciones y preguntarle al robot '¿qué estaba pensando alguien cuando hizo esto?' Esperamos que esto sirva como clave para desbloquear el lenguaje corporal en los robots ".

© 2020 Science X Network