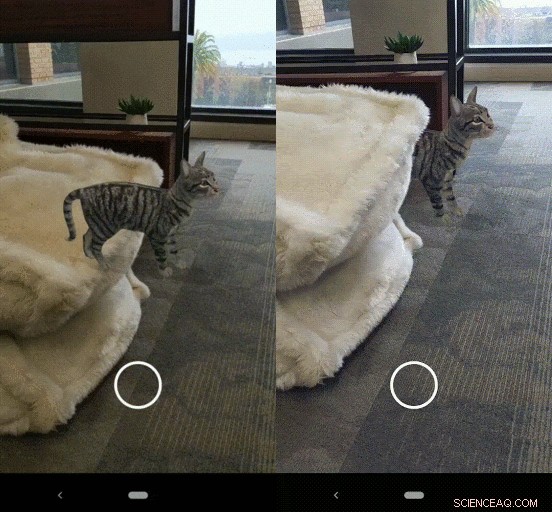

Un gato virtual con oclusión desactivada y con oclusión activada. Crédito:Google

Entonces, ¿La cámara de un teléfono inteligente es buena para tomar instantáneas? No hable así con los ingenieros de realidad aumentada de Google. Combinar lo real y lo virtual, y ganar accesorios especiales para combinar lo real con lo virtual, es lo que Google tiene en mente como motivador para los desarrolladores que desean profundizar en la realidad aumentada.

"Estamos acostumbrados a la RA al alcance de la mano, brindándonos experiencias útiles y divertidas. Tu contenido, aunque, a menudo parece que está pegado en la pantalla en lugar de en el mundo ". Eso es Konstantine Tsotsos, ingeniero de software, Google, hablando en un video. Tentadoramente pregunta (como hizo el equipo de Google), "¿Y si ARCore pudiera sobrecargar tu cámara? ¿Traer el mundo a tu teléfono?" Entonces, ¿Cómo? Dándote color. Y profundidad.

Google sigue llamando la atención con su plataforma, cuyo último avance es la función de profundidad. ARCore le permite crear experiencias de realidad aumentada. "Utilizando diferentes API, ARCore permite que su teléfono detecte su entorno, comprender el mundo e interactuar con la información.

Este video en el que apareció Tsotsos fue para presentar la API de profundidad de ARCore. Realmente, el video resultó ser tanto una llamada a la colaboración como un anuncio de características de la plataforma.

Los ingenieros creen que este avance en profundidad es solo una muestra de lo que es posible con la nueva característica. "Necesitamos desarrolladores como tú, también ayúdenos a construir el futuro ". Dijo que aquellos con ideas que les gustaría desarrollar utilizando la API de profundidad podrían completar un formulario.

Dijo que estaban buscando desarrolladores en 2020 para ayudarlos a construir una nueva ola de experiencias de AR y esperaban ver lo que construyen con la API de profundidad. Los desarrolladores podrían ayudarlos a "explorar y probar la API de profundidad en aplicaciones del mundo real a escala, con un plan para que la función esté ampliamente disponible ".

Nicole Lee en Engadget dijo que Google estaba incorporando una "API de profundidad" que introducirá oclusión, Comprensión 3-D, y un nuevo nivel de realismo. Lee estuvo en la oficina de Google en San Francisco, donde visitó a los desarrolladores que trabajaban con la nueva API de profundidad de ARCore para crear un mapa de profundidad utilizando una cámara de teléfono inteligente normal. Dijo que una "comprensión profunda del mundo" permitía a los desarrolladores jugar con "la física del mundo real, interacción superficial y más ".

Esta es una nueva oferta en la plataforma y le permite crear un mapa de profundidad a través de algoritmos de profundidad a partir del movimiento y una sola cámara. Cuando se utiliza, ARCore está haciendo dos cosas:(1) rastrear la posición del dispositivo móvil mientras se mueve, y (2) desarrollar su comprensión del mundo real.

Una experiencia de demostración que creamos en la que tienes que esquivar y arrojar comida a un chef robot. Crédito:Google

Shahram Izadi, Director de Investigación e Ingeniería, escribiendo en el blog de desarrolladores de Google, explicó lo que está sucediendo para brindarles a los desarrolladores sus resultados realistas:

"La API de profundidad de ARCore permite a los desarrolladores utilizar nuestros algoritmos de profundidad a partir del movimiento para crear un mapa de profundidad con una sola cámara RGB. El mapa de profundidad se crea tomando varias imágenes desde diferentes ángulos y comparándolas mientras mueve su teléfono para estimar el distancia a cada píxel ".

Una actualización de la tecnología ARCore de Google puede detectar la profundidad en una habitación y ocultar objetos virtuales detrás de los reales usando solo la cámara de un teléfono. dijo CNET, "y los primeros resultados parecen prometedores".

Espere un tiempo real, Representación píxel por píxel de la distancia a las superficies físicas en la vista de la cámara.

La oclusión es la habilitación que actualmente se muestra en las oportunidades de inteligencia artificial "inmersiva" de Google para desarrolladores. "Comenzaremos a hacer que la oclusión esté disponible en Scene Viewer, "dijo Izadi, "la herramienta para desarrolladores que impulsa la RA en la búsqueda, a un conjunto inicial de más de 200 millones de dispositivos Android habilitados para ARCore en la actualidad [el blog se publicó el 9 de diciembre] ".

Se decía que más de 200 dispositivos Android eran compatibles con ARCore. "Con una sola cámara en movimiento, Tsotsos dijo en el video, "Podemos brindarle una comprensión tridimensional del mundo en más de 200 millones de teléfonos Android". Dijo que pueden comenzar a ocluir objetos (como el animal que acecha entre los arbustos en la pantalla de su teléfono).

David Kim, otro ingeniero de software de Google, lo tomé de allí. Dijo que cuando una cámara entiende el espacio 3-D, la cámara tiene algunas opciones positivas, donde pueda chocar con el mundo, o incluso ceñirte a él, en lugar de simplemente rebotar.

Entonces, los personajes se mueven naturalmente en tu espacio. Luego está la otra ventaja de las partículas de aspecto realista en su escena:la nieve se amontona, salpicaduras de lluvia. Ahora, dijo Kim, si su teléfono tiene un sensor de profundidad activo, todos estos efectos de espacio de profundidad pueden mejorar aún más.

Izadi repitió la invitación al reclutador:"Si está interesado en probar la nueva API de profundidad, por favor llene nuestro formulario de convocatoria de colaboradores ".

© 2019 Science X Network