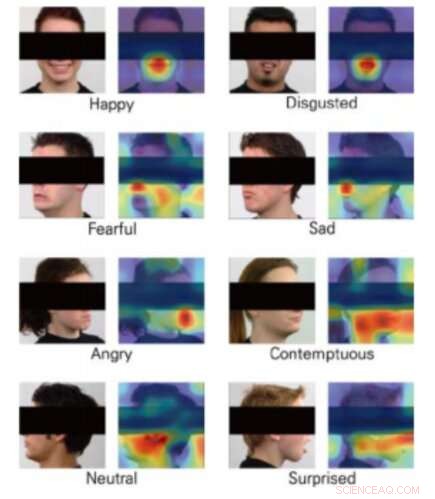

Mapas de activación de clases para 8 emociones. Crédito:Yong, Lee y Choi.

La realidad virtual (VR) está abriendo nuevas y emocionantes fronteras en el desarrollo de videojuegos, allanando el camino para cada vez más realistas, experiencias de juego interactivas e inmersivas. Consolas de realidad virtual, De hecho, permitir que los jugadores se sientan casi dentro del juego, superar las limitaciones asociadas con la resolución de la pantalla y los problemas de latencia.

Una integración adicional interesante para la realidad virtual sería el reconocimiento de emociones, ya que esto podría permitir el desarrollo de juegos que respondan a las emociones de un usuario en tiempo real. Teniendo esto en cuenta, Un equipo de investigadores de la Universidad de Yonsei y Motion Device Inc. propuso recientemente una técnica basada en el aprendizaje profundo que podría permitir el reconocimiento de emociones durante las experiencias de juego de realidad virtual. Su artículo fue presentado en la Conferencia IEEE de 2019 sobre Realidad Virtual e Interfaces de Usuario 3-D.

Para que la realidad virtual funcione, los usuarios usan pantallas montadas en la cabeza (HMD), para que el contenido de un juego se pueda presentar directamente frente a sus ojos. Combinar herramientas de reconocimiento de emociones con experiencias de juegos de realidad virtual ha demostrado ser un desafío, ya que la mayoría de los modelos de aprendizaje automático para la predicción de emociones funcionan analizando los rostros de las personas; en realidad virtual, La cara de un usuario está parcialmente ocluida por el HMD.

El equipo de investigadores de la Universidad de Yonsei y Motion Device entrenó tres redes neuronales convolucionales (CNN), a saber, DenseNet, ResNet e Inception-ResNet-V2:para predecir las emociones de las personas a partir de imágenes parciales de rostros. Tomaron imágenes del conjunto de datos Radbound Faces (RaFD), que incluye 8, 040 imágenes de caras de 67 sujetos, luego los editó cubriendo la parte de la cara que sería ocluida por el HMD al usar VR.

Las imágenes utilizadas para entrenar los algoritmos retratan rostros humanos, pero la sección que contiene los ojos, las orejas y las cejas están cubiertas por un rectángulo negro. Cuando los investigadores evaluaron sus CNN, descubrieron que podían clasificar las emociones incluso sin analizar estas características particulares del rostro de una persona, que se cree que son de importancia clave para el reconocimiento de emociones.

En general, la CNN llamada DenseNet funcionó mejor que las demás, logrando precisiones promedio de más del 90 por ciento. Curiosamente, sin embargo, el algoritmo ResNet superó a los otros dos en la clasificación de expresiones faciales que transmitían miedo y disgusto.

"Entrenamos con éxito tres arquitecturas de CNN que estiman las emociones de las imágenes de rostros humanos parcialmente cubiertos, ", escribieron los investigadores en su artículo." Nuestro estudio mostró la posibilidad de estimar las emociones a partir de imágenes de humanos que usan HMD utilizando visión artificial ".

El estudio sugiere que en el futuro, las herramientas de reconocimiento de emociones podrían integrarse con la tecnología de realidad virtual, incluso si los HMD ocluyen partes de la cara de un jugador. Además, Las CNN que desarrollaron los investigadores podrían inspirar a otros equipos de investigación de todo el mundo a desarrollar nuevas técnicas de reconocimiento de emociones que puedan aplicarse a los juegos de realidad virtual.

Los investigadores ahora planean reemplazar los rectángulos negros que usaron en su estudio con imágenes reales de personas que usan HDM. En última instancia, esto debería permitirles capacitar a las CNN de manera más confiable y efectiva, prepararlos para aplicaciones de la vida real.

© 2019 Science X Network