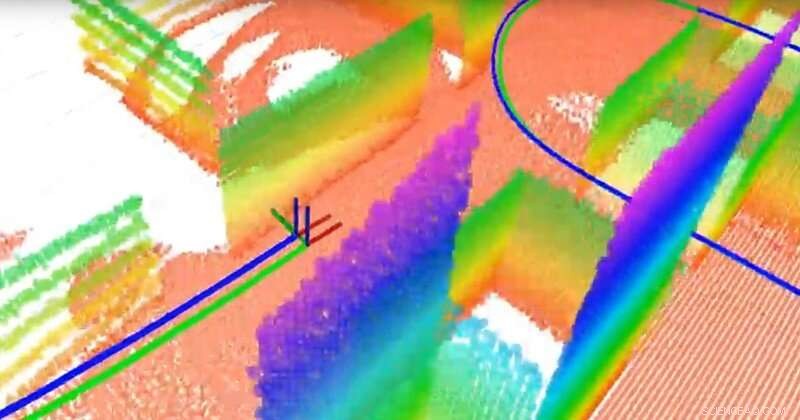

El equipo construyó un mapa 3D basado en un plano utilizando un LiDAR 3D y un sensor de inercia. LiDAR es como un radar pero usa luz en lugar de ondas de radio. Los puntos con diferentes colores son los diferentes planos (que sirven como puntos de referencia para la navegación), la línea verde es la trayectoria verdadera y la línea azul es la trayectoria estimada calculada por el algoritmo de localización y mapeo simultáneo (SLAM) del equipo. Crédito:Universidad de Delaware

Científicos de todo el mundo están compitiendo para desarrollar vehículos autónomos, pero algunos componentes esenciales aún no se han perfeccionado. Uno es la localización:la capacidad del vehículo para determinar su lugar y movimiento. Otro es el mapeo:la capacidad de los vehículos para modelar su entorno de modo que pueda transportar pasajeros de manera segura al lugar correcto.

La pregunta es:¿Cómo se le da a un vehículo un sentido de dirección? Si bien los dispositivos de posicionamiento global por satélite (GPS) pueden ayudar, no están disponibles ni son fiables en todos los contextos. En lugar de, muchos expertos están investigando la localización y el mapeo simultáneos, o SLAM, un problema notoriamente difícil en el campo de la robótica. Nuevos algoritmos desarrollados por Guoquan (Paul) Huang, un profesor asistente de ingeniería mecánica, ingeniería Eléctrica y Computación, e informática y ciencias de la información en la Universidad de Delaware, están acercando la respuesta a la vista.

Huang utiliza sistemas de navegación visual-inercial que combinan sensores inerciales, que contienen giroscopios para determinar la orientación y acelerómetros para determinar la aceleración, junto con las cámaras. Usando datos de estos relativamente económicos, componentes ampliamente disponibles, Huang mide y calcula el movimiento y la localización.

Por ejemplo, cuando su equipo conectó su sistema a una computadora portátil y lo llevó por el laboratorio Spencer de UD, sede del Departamento de Ingeniería Mecánica, generaron suficientes datos para mapear el edificio mientras rastreaban el movimiento de la computadora portátil. En un vehículo autónomo, sensores y cámaras similares se conectarían a un robot en el vehículo.

La capacidad de un vehículo autónomo para rastrear su propio movimiento y el movimiento de los objetos a su alrededor es fundamental. "Necesitamos localizar el vehículo antes de que podamos controlarlo automáticamente, ", dijo Huang." El vehículo necesita saber su ubicación para poder continuar ".

Luego está el tema de la seguridad. "En un escenario urbano, por ejemplo, hay peatones y otros vehículos, por lo tanto, lo ideal es que el vehículo pueda seguir su propio movimiento, así como el movimiento de los objetos en movimiento en su entorno, "dijo Huang.

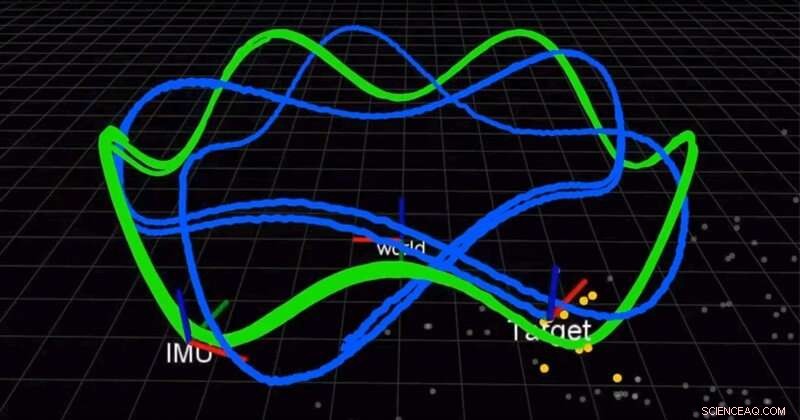

El equipo utiliza una cámara y una unidad de medición inercial (IMU) para localizar simultáneamente un robot y rastrear un objetivo en movimiento. La línea verde es la trayectoria del robot y la línea azul es la trayectoria del objetivo. Crédito:Universidad de Delaware

En un artículo publicado a principios de este año en Revista internacional de investigación robótica (IJRR), Huang y su equipo encontraron una mejor Solución más precisa para combinar las medidas inerciales. Hasta ahora, los científicos utilizaron la integración discreta, una técnica de cálculo que aproxima el área bajo una curva, para aproximar la solución. En lugar de, El grupo de Huang encontró una solución y demostró que era mejor que los métodos existentes. Aun mejor, están compartiendo su solución.

"Abrimos nuestro código. Está en GitHub, ", dijo Huang." Muchas personas han usado nuestro código para sus sistemas ". En otro artículo reciente de IJRR, Huang y su equipo reformularon el problema SLAM como una fórmula que calcula pequeños incrementos de movimiento de los robots equipados con sensores visuales e inerciales. Muchos de estos videos de investigación se pueden encontrar en el canal de YouTube del laboratorio de Huang.

Estos descubrimientos podrían tener aplicaciones más allá de los vehículos autónomos, desde automóviles hasta drones aéreos, embarcaciones submarinas y más. Los algoritmos de Huang también podrían usarse para desarrollar aplicaciones de realidad aumentada y realidad virtual para dispositivos móviles como teléfonos inteligentes, que ya cuentan con cámaras y sensores de inercia a bordo.

"Estos sensores son muy comunes, por lo que la mayoría de los dispositivos móviles teléfonos inteligentes, incluso los drones y los vehículos tienen estos sensores, ", dijo Huang." Intentamos aprovechar los sensores baratos existentes y proporcionar una solución de localización, una solución de seguimiento de movimiento ".

En 2018 y nuevamente en 2019, Huang recibió un premio de investigación de la facultad de Google Daydream (AR / VR) para apoyar este trabajo.

"La gente ve que los robots serán la próxima gran novedad en la vida real, por eso la industria impulsa mucho este campo de investigación, "dijo Huang.