La startup francesa LightOn está trabajando actualmente en el desarrollo de tecnologías basadas en la luz. Crédito:Dmitriy Rybin / Shutterstock

Estamos siendo testigos de la adopción acelerada de la inteligencia artificial (IA), que tiene el potencial de traducirse en una variedad de cambios sociales, incluyendo mejoras a la economía, mejores condiciones de vida, un acceso más fácil a la educación, bienestar, y entretenimiento. Un futuro tan esperado sin embargo, está contaminado con problemas relacionados con la privacidad, explicabilidad, responsabilidad, para nombrar unos pocos, que constituyen una amenaza para la adopción fluida de la IA, y que están en el centro de diversos debates en los medios de comunicación.

Un aspecto quizás más preocupante está relacionado con el hecho de que las tecnologías de IA actuales son completamente insostenibles. y a menos que actuemos rápidamente, esto se convertirá en el principal obstáculo para la amplia adopción de la inteligencia artificial en la sociedad.

IA y aprendizaje automático bayesiano

Pero antes de sumergirnos en los problemas de la sostenibilidad de la IA, ¿Qué es la IA? La IA tiene como objetivo construir agentes artificiales capaces de sentir y razonar sobre su entorno, y finalmente aprender interactuando con él. El aprendizaje automático (ML) es un componente esencial de la IA, lo que permite establecer correlaciones y relaciones causales entre variables de interés a partir de datos y conocimientos previos de los procesos que caracterizan el entorno del agente.

Por ejemplo, en ciencias de la vida, El ML puede ser útil para determinar la relación entre el volumen de materia gris y la progresión de la enfermedad de Alzheimer. mientras que en ciencias ambientales puede ser útil estimar el efecto del CO 2 emisiones sobre el clima. Un aspecto clave de algunas técnicas de aprendizaje automático, en particular ML bayesiano, es la posibilidad de hacer esto teniendo en cuenta la incertidumbre debida al desconocimiento del sistema, o el hecho de que se dispone de una cantidad finita de datos.

Tal incertidumbre es de fundamental importancia en la toma de decisiones cuando el costo asociado con diferentes resultados está desequilibrado. Un par de ejemplos de dominios en los que la IA puede ser de gran ayuda incluyen una variedad de escenarios médicos (por ejemplo, diagnóstico, pronóstico, trato personalizado), ciencias ambientales (por ejemplo, clima, terremoto / tsunami), y formulación de políticas (por ejemplo, tráfico, abordar la desigualdad social).

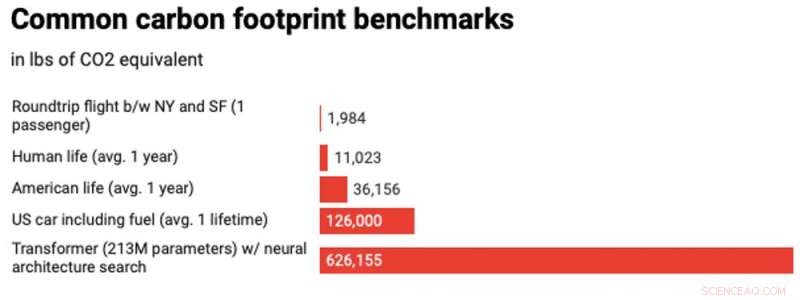

Crédito:MIT Technology Review Fuente:Strubell et al.

IA insostenible

Los recientes y espectaculares avances en ML han contribuido a un aumento sin precedentes del interés en la IA, que ha provocado enormes cantidades de financiación privada en el dominio (Google, Facebook, Amazonas, Microsoft, OpenAI). Todo esto está impulsando la investigación en el campo, pero de alguna manera está ignorando su impacto en el medio ambiente. El consumo de energía de los dispositivos informáticos actuales está creciendo a un ritmo descontrolado. Se estima que en los próximos diez años el consumo de energía de los dispositivos informáticos alcanzará el 60% de la cantidad total de energía que se producirá, y esto será completamente insostenible para 2040.

Estudios recientes muestran que la industria de las TIC en la actualidad genera aproximadamente el 2% de las emisiones globales de CO₂, comparable a la industria de la aviación mundial, pero la fuerte curva de crecimiento prevista para las emisiones basadas en las TIC es realmente alarmante y supera con creces a la aviación. Dado que el aprendizaje automático y la inteligencia artificial son disciplinas de las TIC de rápido crecimiento, esta es una perspectiva preocupante. Estudios recientes muestran que la huella de carbono de entrenar un modelo famoso de ML, llamado codificador automático, puede contaminar hasta cinco coches en su vida.

Si, con el fin de crear mejores condiciones de vida y mejorar nuestra estimación del riesgo, estamos impactando el medio ambiente en una medida tan amplia, estamos destinados a fallar. ¿Qué podemos hacer para cambiar esto radicalmente?

Que haya luz

Están comenzando a aparecer soluciones basadas en transistores para este problema. Google desarrolló la Unidad de procesamiento de tensor (TPU) y la puso a disposición en 2018. Las TPU ofrecen un consumo de energía mucho menor que las GPU y CPU por unidad de cálculo. Pero, ¿podemos romper con la tecnología basada en transistores para la informática con menor potencia y quizás más rápido? ¡La respuesta es sí! En los últimos años ha habido intentos de aprovechar la luz para cálculos rápidos y de bajo consumo. Tales soluciones son algo rígidas en el diseño del hardware y son adecuadas para modelos específicos de ML, p.ej., Redes neuronales.

Curiosamente, Francia está a la vanguardia en esto, con el desarrollo de hardware de financiación privada y financiación nacional para la investigación para hacer de esta revolución una posibilidad concreta. La empresa francesa LightOn ha desarrollado recientemente un novedoso dispositivo basado en óptica, a la que llamaron Unidad de Procesamiento Óptico (OPU).

En la práctica, Las OPU realizan una operación específica, que es una transformación lineal de vectores de entrada seguida de una transformación no lineal. Curiosamente, esto se hace en hardware que explota las propiedades de dispersión de la luz, de modo que en la práctica estos cálculos ocurren a la velocidad de la luz y con un bajo consumo de energía. Es más, es posible manejar matrices muy grandes (del orden de millones de filas y columnas), lo que sería un desafío con CPU y GPU. Debido a la dispersión de la luz, esta transformación lineal es el equivalente a una proyección aleatoria, p.ej. la transformación de los datos de entrada por una serie de números aleatorios cuya distribución se puede caracterizar. ¿Son útiles las proyecciones aleatorias? ¡Sorprendentemente sí! Una prueba de concepto de que esto puede ser útil para escalar cálculos para algunos modelos de ML (máquinas kernel, que son alternativas a las redes neuronales) se ha informado aquí. Otros modelos de ML también pueden aprovechar las proyecciones aleatorias para la predicción o la detección de puntos de cambio en series de tiempo.

Creemos que esta es una dirección notable para hacer que el aprendizaje automático moderno sea escalable y sostenible. El mayor desafío para el futuro, sin embargo, es cómo repensar el diseño y la implementación de modelos Bayesianos ML para poder explotar los cálculos que ofrecen las OPU. Recién ahora estamos comenzando a desarrollar la metodología necesaria para aprovechar al máximo este hardware para Bayesian ML. Recientemente me concedieron una beca francesa para que esto suceda.

Es fascinante cómo la luz y la aleatoriedad no solo son omnipresentes en la naturaleza, también son matemáticamente útiles para realizar cálculos que pueden resolver problemas reales.

Este artículo se ha vuelto a publicar de The Conversation con una licencia de Creative Commons. Lea el artículo original.