Crédito:Oliver, Lanillos y Cheng.

Un desafío clave para los investigadores de robótica es el desarrollo de sistemas que puedan interactuar con los humanos y el entorno que los rodea en situaciones que implican diversos grados de incertidumbre. De hecho, mientras que los humanos pueden aprender continuamente de sus experiencias y percibir su cuerpo como un todo mientras interactúan con el mundo, los robots aún no tienen estas capacidades.

Investigadores de la Universidad Técnica de Munich han llevado a cabo recientemente un ambicioso estudio en el que intentaron aplicar "inferencia activa, "un constructo teórico que describe la capacidad de unir percepción y acción, a un robot humanoide. Su estudio es parte de un proyecto más amplio financiado por la UE llamado SELFCEPTION, que une la robótica y la psicología cognitiva con el objetivo de desarrollar robots más perceptivos.

"La pregunta de investigación original que desencadenó este trabajo fue proporcionar a los robots humanoides y a los agentes artificiales en general la capacidad de percibir su cuerpo como lo hacen los humanos, "Pablo Lanillos, uno de los investigadores que realizó el estudio, dijo a TechXplore. "El objetivo principal era mejorar sus capacidades para interactuar en condiciones de incertidumbre. En el marco del proyecto Marie Skłodowska-Curie de Selfception.eu, inicialmente definimos una hoja de ruta para incluir algunas características de la percepción y la acción humanas en los robots".

En su estudio, Lanillos y sus colegas intentaron obtener una mejor comprensión de la percepción humana y luego la modelaron en un robot humanoide. Esta resultó ser una tarea muy difícil, tantos detalles de cómo la información sensorial (visual, táctil, etc.) es procesada por humanos aún se desconocen. Los investigadores se inspiraron en el trabajo de Hermann Von Helmholtz y Karl Friston, particularmente de su teoría de la inferencia activa, que se encuentra entre los constructos neurocientíficos más influyentes.

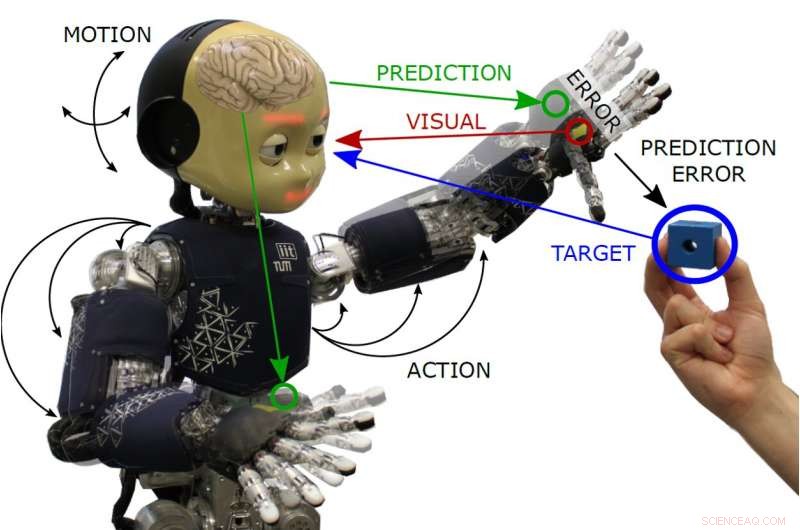

"En esencia, proponemos que el robot se aproxima continuamente a su cuerpo utilizando sus modelos aprendidos imperfectos, "Guillermo Oliver, otro investigador involucrado en el estudio, dijo a TechXplore. "El algoritmo, basado en el principio de energía libre, presenta la percepción y la acción trabajando para un objetivo común:reducir el error de predicción. En este enfoque, la acción hace que los datos sensoriales se correspondan mejor con la predicción hecha por el modelo interno ".

Lanillos, Oliver y el profesor Gordon Cheng fueron los primeros en aplicar la inferencia activa a un robot real. De hecho, hasta aquí, La inferencia activa solo se probó teóricamente o en simulaciones parcialmente sesgadas por la simplificación de los modelos utilizados.

Su enfoque intenta reproducir la capacidad de los humanos para cambiar sus acciones (por ejemplo, su forma de andar) en situaciones particulares, por ejemplo, cuando se acercan a una escalera mecánica del metro, pero de repente descubre que está roto o fuera de servicio, y adaptar sus movimientos en consecuencia. El algoritmo de percepción y control desarrollado por Lanillos, Oliver y Cheng replican un mecanismo similar en robots.

Por ejemplo, en una tarea de alcance en la que un robot necesita tocar un objeto, el modelo crea un error en la ubicación deseada de la mano que desencadena una acción hacia el objeto. El equilibrio (o minimización) se obtiene cuando la mano del robot y el objeto están en la misma ubicación.

"Este enfoque es poco común en la comunidad de la robótica, pero proporciona manejabilidad, permite la combinación de información sensorial de diferentes fuentes y permite ajustar la confiabilidad de la información de cada sensor, dependiendo de la precisión, "Dijo Oliver.

Los investigadores aplicaron su algoritmo a iCub, un robot humanoide cognitivo de código abierto desarrollado como parte de otro proyecto financiado por la UE, y evaluó su desempeño en tareas que involucraban el alcance de dos brazos y el seguimiento activo de la cabeza. En sus pruebas, el robot pudo realizar comportamientos de alcance avanzados y robustos, así como el seguimiento activo de la cabeza de los objetos en su campo visual.

"El robot humanoide fue capaz de realizar robustas tareas de seguimiento visual y alcance de dos brazos de un objeto utilizando el mismo modelo matemático, "Oliver dijo." Con este tipo de algoritmo, nos gustaría cambiar la visión actual de la canalización de percepción de entrada-salida (por ejemplo, redes neuronales de última generación) haciendo cumplir la idea de percepción de bucle cerrado, donde los pases hacia adelante y hacia atrás se procesan en línea, e incluir la acción como otra variable inevitable ".

Lanillos, Oliver y Cheng son los primeros en implementar un modelo basado en el principio de energía libre en un robot humanoide real. Sus hallazgos sugieren que es posible validar tales modelos en entornos del mundo real, al igual que analizar las ventajas de estos modelos en presencia de información sensorial ruidosa, oclusiones o cuando solo se dispone de información parcial. Los investigadores ahora planean aplicar su modelo a otros robots y probar su generalización.

"A largo plazo, Queremos posibilitar el desarrollo de agentes artificiales con las mismas capacidades de adaptación e interacción corporal que los humanos, "Lanillos dijo." Mientras tanto, estamos desarrollando nuevos algoritmos de inteligencia artificial bioinspirados. En el futuro, también usaremos este modelo para investigar la propiedad del cuerpo y la agencia, y quien sabe, algún día podríamos habilitar el autorreconocimiento en las máquinas ".

© 2019 Science X Network