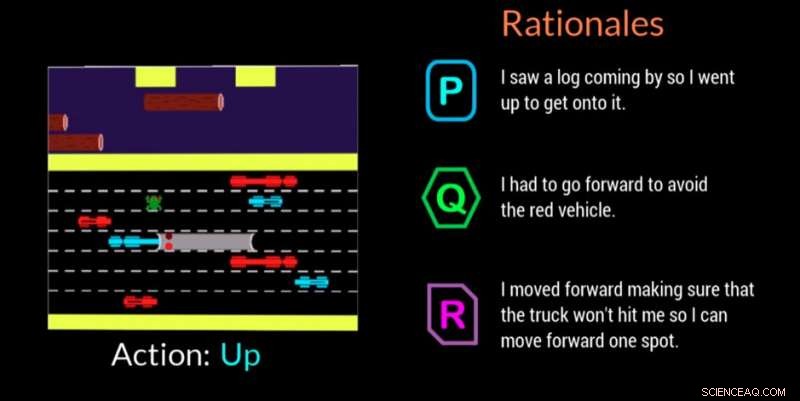

Un agente de inteligencia artificial proporciona sus razones para tomar una decisión en este videojuego. Crédito:Georgia Tech

Investigadores del Instituto de Tecnología de Georgia, en colaboración con la Universidad de Cornell y la Universidad de Kentucky, han desarrollado un agente de inteligencia artificial (IA) que puede generar automáticamente explicaciones en lenguaje natural en tiempo real para transmitir las motivaciones detrás de sus acciones. El trabajo está diseñado para dar a los humanos que se relacionan con agentes de IA o robots la confianza de que el agente está realizando la tarea correctamente y puede explicar un error o comportamiento errado.

El agente también usa un lenguaje cotidiano que los no expertos pueden entender. Las explicaciones, o "justificaciones", como los llaman los investigadores, están diseñadas para ser identificables e inspirar confianza en aquellos que podrían estar en el lugar de trabajo con máquinas de IA o interactuar con ellas en situaciones sociales.

"Si se quiere democratizar el poder de la IA, debe ser accesible para cualquier persona independientemente de sus habilidades técnicas, "dijo Upol Ehsan, Doctor. estudiante de la Escuela de Computación Interactiva de Georgia Tech e investigador principal.

"Dado que la IA impregna todos los aspectos de nuestras vidas, Existe una clara necesidad de un diseño de IA centrado en el ser humano que haga que los sistemas de IA de caja negra sean explicables para los usuarios cotidianos. Nuestro trabajo da un paso formativo hacia la comprensión del papel de las explicaciones basadas en el lenguaje y cómo las perciben los humanos ".

El estudio fue apoyado por la Oficina de Investigación Naval (ONR).

Los investigadores desarrollaron un estudio participante para determinar si su agente de IA podría ofrecer razones que imitaran las respuestas humanas. Los espectadores vieron al agente de IA jugar el videojuego Frogger y luego clasificaron tres razones en la pantalla en orden de qué tan bien cada uno describía el movimiento del juego de la IA.

De las tres justificaciones anónimas para cada movimiento:una respuesta generada por humanos, la respuesta del agente de IA, y una respuesta generada al azar:los participantes prefirieron primero los fundamentos generados por humanos, pero las respuestas generadas por la IA fueron un segundo cercano.

Frogger ofreció a los investigadores la oportunidad de entrenar a una IA en un "entorno secuencial de toma de decisiones, "que es un desafío de investigación importante porque las decisiones que el agente ya ha tomado influyen en las decisiones futuras. Por lo tanto, explicar la cadena de razonamiento a los expertos es difícil, y más aún cuando se comunica con no expertos, según los investigadores.

Los espectadores humanos entendieron el objetivo de Frogger de llevar a la rana a salvo a casa sin ser atropellada por vehículos en movimiento o ahogada en el río. La simple mecánica del juego de ascender, abajo, izquierda o derecha, permitió a los participantes ver lo que estaba haciendo la IA, y evaluar si los fundamentos en la pantalla justificaron claramente la mudanza.

Los espectadores juzgaron los fundamentos basados en:

Los fundamentos generados por la IA que fueron calificados más alto por los participantes fueron aquellos que mostraron reconocimiento de las condiciones ambientales y adaptabilidad, así como aquellos que comunicaron la conciencia de los peligros venideros y los planificaron. Se descubrió que la información redundante que solo indicaba lo obvio o que describía mal el medio ambiente tenía un impacto negativo.

"Este proyecto trata más sobre la comprensión de las percepciones y preferencias humanas de estos sistemas de IA que sobre la construcción de nuevas tecnologías, ", dijo Ehsan." En el corazón de la explicabilidad está la construcción de sentido. Estamos tratando de comprender ese factor humano ".

Un segundo estudio relacionado validó la decisión de los investigadores de diseñar su agente de IA para poder ofrecer uno de dos tipos distintos de fundamentos:

En este segundo estudio, a los participantes solo se les ofrecieron los fundamentos generados por la IA después de ver a la IA jugar Frogger. Se les pidió que seleccionaran la respuesta que preferían en un escenario en el que una IA cometió un error o se comportó de forma inesperada. No sabían que los fundamentos estaban agrupados en las dos categorías.

Por un margen de 3 a 1, los participantes favorecieron las respuestas que se clasificaron en la categoría de "imagen completa". Las respuestas mostraron que la gente apreciaba que la IA pensara en los pasos futuros en lugar de solo en lo que había en el momento. lo que podría hacerlos más propensos a cometer otro error. La gente también quería saber más para poder ayudar directamente a la IA a corregir el comportamiento errado.

"La comprensión situada de las percepciones y preferencias de las personas que trabajan con máquinas de inteligencia artificial nos brinda un poderoso conjunto de conocimientos prácticos que pueden ayudarnos a diseñar mejor centrado en el ser humano, generador de justificación, agentes autónomos, "dijo Mark Riedl, profesor de Computación Interactiva y miembro principal de la facultad del proyecto.

Una posible dirección futura para la investigación aplicará los hallazgos a agentes autónomos de varios tipos, como agentes acompañantes, y cómo podrían responder en función de la tarea en cuestión. Los investigadores también analizarán cómo los agentes podrían responder en diferentes escenarios, como durante una respuesta de emergencia o al ayudar a los maestros en el aula.

La investigación se presentó en marzo en la Conferencia de Interfaces de Usuario Inteligentes 2019 de la Association for Computing Machinery. El artículo se titula "Generación automatizada de fundamentos:una técnica para explicar la IA y sus efectos en las percepciones humanas". Ehsan presentará un documento de posición que destaca los desafíos de diseño y evaluación de los sistemas de IA explicables centrados en el ser humano en el próximo taller de Perspectivas emergentes en el aprendizaje automático centrado en el ser humano en la conferencia ACM CHI 2019, 4-9 de mayo en Glasgow, Escocia.