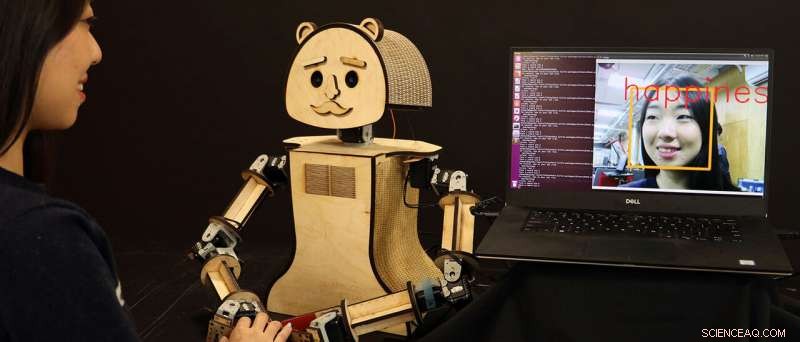

"Leñoso, "un robot social de bajo costo, está leyendo las emociones en el rostro del ser humano, basado en los algoritmos que está desarrollando la investigadora Kiju Lee y su equipo en la Universidad Case Western Reserve. Crédito:Universidad Case Western Reserve

Los robots se están volviendo más inteligentes y más rápidos para saber lo que los humanos sienten y piensan con solo "mirarlos" a la cara, un desarrollo que algún día podría permitir que máquinas más perceptivas emocionalmente detecten cambios en la salud o el estado mental de una persona.

Los investigadores de la Case Western Reserve University dicen que están mejorando la inteligencia artificial (IA) que ahora impulsa los videojuegos interactivos y que pronto mejorará la próxima generación de robots personalizados que probablemente coexistan con los humanos.

Y los robots de Case Western Reserve lo están haciendo en tiempo real.

Nuevas máquinas desarrolladas por Kiju Lee, el profesor adjunto distinguido de Nord en ingeniería mecánica y aeroespacial en la Case School of Engineering, y el estudiante graduado Xiao Liu, están identificando correctamente las emociones humanas a partir de las expresiones faciales el 98 por ciento de las veces, casi al instante. Los resultados anteriores de otros investigadores habían logrado resultados similares, pero los robots a menudo respondían con demasiada lentitud.

"Incluso una pausa de tres segundos puede resultar incómoda, "Dijo Lee." Es bastante difícil para los humanos, e incluso más difícil para los robots, descubrir lo que alguien siente basándose únicamente en sus expresiones faciales o lenguaje corporal. "Todas las capas y capas de tecnología, incluida la captura de video, para hacer esto, desafortunadamente, también ralentiza la respuesta".

Lee y Liu aceleraron el tiempo de respuesta al combinar dos filtros de video de preprocesamiento con otro par de programas existentes para ayudar al robot a clasificar las emociones basándose en más de 3, 500 variaciones en la expresión facial humana.

Pero ese no es el alcance de nuestra variación facial:los humanos pueden registrar más de 10, 000 expresiones, y cada uno también tiene una forma única de revelar muchas de esas emociones, Dijo Lee.

Pero las computadoras de "aprendizaje profundo" pueden procesar grandes cantidades de información una vez que esos datos se ingresan en el software y se clasifican.

Y, agradecidamente, Las características expresivas más comunes entre los humanos se dividen fácilmente en siete emociones:neutrales, felicidad, enfado, tristeza, asco, sorpresa y miedo, incluso teniendo en cuenta las variaciones entre diferentes orígenes y culturas.

Aplicaciones ahora y en el futuro

Este trabajo reciente de Lee y Liu, presentado en los Juegos IEEE 2018, Entretenimiento, y conferencia de prensa, podría conducir a una gran cantidad de aplicaciones cuando se combina con los avances de decenas de otros investigadores en el campo de la IA, Dijo Lee.

Los dos también están trabajando ahora en otro enfoque basado en el aprendizaje automático para el reconocimiento de emociones faciales, que hasta ahora ha logrado más del 99 por ciento de precisión con una eficiencia computacional aún mayor.

Algún día, un robot personal puede notar con precisión cambios significativos en una persona a través de la interacción diaria, incluso hasta el punto de detectar los primeros signos de depresión, por ejemplo.

"El robot podría programarse para detectarlo temprano y ayudar con intervenciones simples, como música y video, para personas que necesitan terapias sociales, ", Dijo Lee." Esto podría ser muy útil para los adultos mayores que podrían estar sufriendo de depresión o cambios de personalidad asociados con el envejecimiento ".

Lee planea explorar el uso potencial de robots sociales para la intervención social y emocional en adultos mayores a través de la colaboración con Ohio Living Breckenridge Village. Se espera que los residentes de la tercera edad interactúen con un robot socialmente interactivo y ayuda a probar la precisión y confiabilidad de los algoritmos integrados.

Otra posibilidad futura:un robot social que aprende los cambios faciales más sutiles en alguien en el espectro del autismo y que ayuda a "enseñar" a los humanos a reconocer con precisión las emociones entre sí.

"Estos robots sociales tomarán algún tiempo para ser capturados en los EE. UU., ", Dijo Lee." Pero en lugares como Japón, donde existe una fuerte cultura en torno a los robots, esto ya está empezando a suceder. En todo caso, nuestro futuro estará al lado de robots emocionalmente inteligentes ".