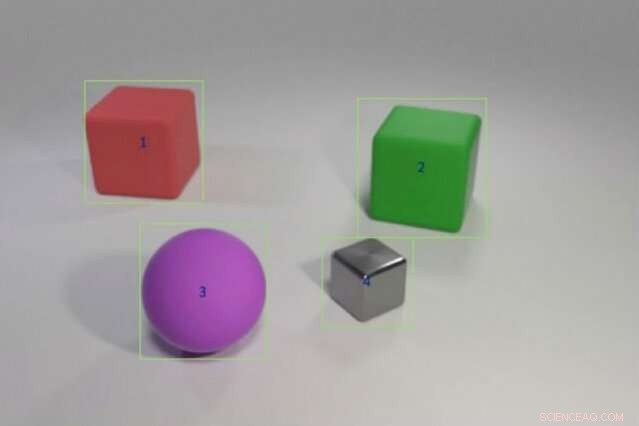

Los investigadores entrenaron un modelo híbrido de IA para responder preguntas como "¿El objeto rojo que queda del cubo verde tiene la misma forma que el mate púrpura?" alimentándolo con ejemplos de colores y formas de objetos seguidos de escenarios más complejos que involucran comparaciones de múltiples objetos. El modelo podría transferir este conocimiento a nuevos escenarios tan bien como o mejor que los modelos de vanguardia utilizando una fracción de los datos de entrenamiento. Crédito:Justin Johnson

Un niño que nunca ha visto un elefante rosa todavía puede describirlo, a diferencia de una computadora. "La computadora aprende de los datos, "dice Jiajun Wu, un doctorado estudiante en el MIT. "La capacidad de generalizar y reconocer algo que nunca antes había visto, un elefante rosa, es muy difícil para las máquinas".

Los sistemas de aprendizaje profundo interpretan el mundo seleccionando patrones estadísticos en los datos. Esta forma de aprendizaje automático está ahora en todas partes, etiquetar automáticamente a amigos en Facebook, narrando el último pronóstico del tiempo de Alexa, y entrega de datos divertidos a través de la búsqueda de Google. Pero el aprendizaje estadístico tiene sus límites. Requiere toneladas de datos, tiene problemas para explicar sus decisiones, y es terrible aplicando conocimientos pasados a situaciones nuevas; No puede comprender un elefante rosado en lugar de gris.

Para dar a las computadoras la capacidad de razonar más como nosotros, Los investigadores de inteligencia artificial (IA) están volviendo a lo abstracto, o simbólico, programación. Popular en las décadas de 1950 y 1960, La IA simbólica conecta las reglas y la lógica que permiten a las máquinas hacer comparaciones e interpretar cómo se relacionan los objetos y las entidades. La IA simbólica usa menos datos, registra la cadena de pasos necesarios para tomar una decisión, y cuando se combina con el poder de procesamiento bruto de las redes neuronales estadísticas, incluso puede vencer a los humanos en una complicada prueba de comprensión de imágenes.

Un nuevo estudio de un equipo de investigadores del MIT, MIT-IBM Watson AI Lab, y DeepMind muestra la promesa de fusionar IA estadística y simbólica. Dirigido por Wu y Joshua Tenenbaum, profesor del Departamento de Ciencias Cerebrales y Cognitivas del MIT y del Laboratorio de Ciencias de la Computación e Inteligencia Artificial, el equipo muestra que su modelo híbrido puede aprender conceptos relacionados con objetos como el color y la forma, y aprovechar ese conocimiento para interpretar relaciones complejas de objetos en una escena. Con datos de entrenamiento mínimos y sin programación explícita, su modelo podría transferir conceptos a escenas más grandes y responder preguntas cada vez más complicadas tan bien o mejor que sus pares más avanzados. El equipo presenta sus resultados en la Conferencia Internacional sobre Representaciones del Aprendizaje en mayo.

"Una forma en que los niños aprenden conceptos es conectando palabras con imágenes, "dice el autor principal del estudio, Jiayuan Mao, un estudiante de la Universidad de Tsinghua que trabajó en el proyecto como investigador visitante en el MIT. "Una máquina que puede aprender de la misma manera necesita muchos menos datos, y está mejor capacitado para transferir sus conocimientos a nuevos escenarios ".

El estudio es un fuerte argumento para retroceder hacia enfoques de programas abstractos, dice Jacob Andreas, un recién graduado de la Universidad de California en Berkeley, que comienza en el MIT como profesor asistente este otoño y no participó en el trabajo. "El truco, resulta, es agregar más estructura simbólica, y alimentar a las redes neuronales con una representación del mundo que se divide en objetos y propiedades en lugar de alimentarlo con imágenes en bruto, ", dice." Este trabajo nos da una idea de lo que las máquinas necesitan comprender antes de que sea posible el aprendizaje de idiomas ".

El equipo entrenó su modelo en imágenes emparejadas con preguntas y respuestas relacionadas, parte de la prueba de comprensión de imágenes CLEVR desarrollada en la Universidad de Stanford. A medida que aprende el modelo, las preguntas se hacen cada vez más difíciles, de, "¿Cuál es el color del objeto?" a "¿Cuántos objetos están a la derecha del cilindro verde y tienen el mismo material que la pequeña bola azul?" Una vez que se dominan los conceptos a nivel de objeto, el modelo avanza para aprender a relacionar los objetos y sus propiedades entre sí.

Al igual que otros modelos de IA híbrida, El MIT funciona dividiendo la tarea. Un módulo de percepción de redes neuronales procesa los píxeles de cada imagen y mapea los objetos. Un módulo de idioma, también hecho de redes neuronales, extrae un significado de las palabras en cada oración y crea programas simbólicos, o instrucciones, que le dicen a la máquina cómo responder a la pregunta. Un tercer módulo de razonamiento ejecuta los programas simbólicos en la escena y da una respuesta, actualizar el modelo cuando comete errores.

La clave del enfoque del equipo es un módulo de percepción que traduce la imagen en una representación basada en objetos, facilitando la ejecución de los programas. También es único lo que ellos llaman aprendizaje curricular, o entrenar selectivamente el modelo en conceptos y escenas que se vuelven progresivamente más difíciles. Resulta que alimentar los datos de la máquina de forma lógica, en lugar de al azar, ayuda al modelo a aprender más rápido mientras mejora la precisión.

Una vez que el modelo tenga una base sólida, puede interpretar nuevas escenas y conceptos, y preguntas cada vez más difíciles, casi perfectamente. Se le pidió que respondiera una pregunta desconocida como, "¿Cuál es la forma de la gran cosa amarilla?" superó a sus pares en Stanford y el cercano Laboratorio Lincoln del MIT con una fracción de los datos.

Mientras que otros modelos entrenados en el conjunto de datos CLEVR completo de 70, 000 imágenes y 700, 000 preguntas, el modelo MIT-IBM utilizó 5, 000 imágenes y 100, 000 preguntas. Como el modelo se basó en conceptos aprendidos previamente, absorbió los programas subyacentes a cada pregunta, acelerar el proceso de formación.

Aunque estadístico, Los modelos de aprendizaje profundo ahora están integrados en la vida diaria, gran parte de su proceso de decisión permanece oculto a la vista. Esta falta de transparencia dificulta anticipar dónde el sistema es susceptible de manipulación, error, o sesgo. Agregar una capa simbólica puede abrir el cuadro negro, explicando el creciente interés en los sistemas híbridos de IA.

"Dividir la tarea y dejar que los programas hagan parte del trabajo es la clave para construir la interpretabilidad en los modelos de aprendizaje profundo, "dice el investigador del Laboratorio Lincoln, David Mascharka, cuyo modelo híbrido, Transparencia por Design Network, se compara con el estudio MIT-IBM.

El equipo de MIT-IBM ahora está trabajando para mejorar el rendimiento del modelo en fotos del mundo real y extenderlo a la comprensión de video y la manipulación robótica. Otros autores del estudio son Chuang Gan y Pushmeet Kohli, investigadores del MIT-IBM Watson AI Lab y DeepMind, respectivamente.

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre la investigación del MIT, innovación y docencia.